人工智能学习

大型语言模型中的“出现的特性”的合理性检验

关于大型语言模型(LLMs),我们在ICML’24立场论文中经常提到的一个观点是,它们具有所谓的“涌现特性”。不幸的是,在大多数情况下,说话者/写作者并没有具体解释他们所说的“涌现”。但是,对于研究方向和公共政策来说,对这一问题的误解可能产生重要影响。

根据我在学术论文中的观察,从事NLP研究的研究人员至少在以下四种意义上使用这个术语:自然语言处理(NLP)。

1. 模型显示的属性,尽管这种属性并未被明确训练。例如,Bommasani 等人 (2021, p. 5) 将 GPT-3 的少量样本性能称为“既未专门训练也未预料到会出现的涌现特性”。

2. (与定义 1 相对)模型从训练数据中学到的属性。例如,Deshpande 等人 (2023, p. 8) 将涌现视为“预训练的好处的证据”。

3. 如果一个属性在较小的模型中不存在,而在更大的模型中存在,那么这个属性就是涌现的。(Wei 等人,2022, p. 2)。

4. 定义 3 的一种版本,其中使涌现属性“令人着迷”的是“它们的尖锐性,从不存在到突然出现的瞬间转变,以及它们的不可预测性,在看似不可预见的模型规模上突然出现”(Schaeffer, Miranda, & Koyejo, 2023, p. 1)。

对于一个技术术语来说,这种模糊性是相当不幸的。如果许多人重复宣称“LLLs(示例术语)具有涌现特性(emergent properties)”而没有明确说明他们的意思,读者可能会认为存在广泛的科学共识认为这个说法是正确的,按照读者自己的理解。

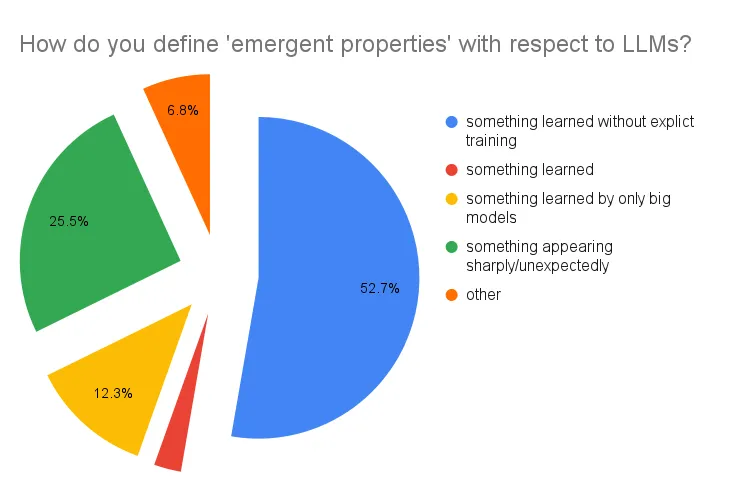

我在世界各地的NLP研究小组做了许多关于这个主题的演讲后写了这篇帖子——包括美国的阿默斯特和乔治敦、英国的剑桥、卡迪夫和伦敦、丹麦的哥本哈根、瑞典的哥德堡以及意大利的米兰,还有在新加坡举行的EMNLP’23的Genbench工作坊(感谢所有在场的朋友们!)。我有机会向许多NLP研究人员和博士生收集了他们对“涌现”(emergence)的看法。根据220名NLP研究人员和博士生的回答,最受欢迎的定义是(1),紧随其后的是(4)。

在定义(1)中表达的想法也经常在公共讨论中被提及。例如,你可以在关于“谷歌的PaLM模型‘懂得’它未经过训练的语言”的说法(这几乎可以肯定是不对的)中看到它。同样的想法还引发了美国参议员与圣菲研究所的著名AI研究人员梅利莎·米特之间的公开对话:

这种想法显示,大型语言模型(LLM)的“涌现属性”概念按照定义不仅限于研究界,对社会也有影响。它加剧了对超级AGI即将统治的焦虑,引发了[暂停研究]的呼吁。这可能会引导政策制定者走向错误的方向,例如禁止开源研究——这将进一步集中资源在少数大型科技实验室中,并确保他们不会有太多竞争者。它还造成了这样一种印象,即LLM被看作是与其开发者和部署者的决策无关的独立实体——这会对因这些模型引发的任何损害的问责制产生巨大影响。在这种情况下,考虑到如此高的利害关系,我们至少应该确保科学的严谨性,不是吗?

这些“涌现”的概念对科学理解大规模语言模型(LLMs)有多大帮助?

关于“涌现”在大规模语言模型中的这些说法仍然存在争议:与现有的其他术语和已知原则相比,这些说法实际上推进了科学讨论多少?我想强调的是,这个讨论完全独立于大规模语言模型是否有用或有价值的问题。无数模型在没有声称“涌现”的情况下,已经或将会有实际价值。

我们从定义2开始:从训练数据中模型学到的东西。既然这正是机器学习模型所应做的,这个版本的“涌现”相对于“学习”来说,增加了多少呢?

对于定义 (3)(“只有大型模型才会做某特定的事”),根据基本的机器学习原理,大型模型表现更好是合乎情理的,因为大型模型拥有更大的能力来学习训练数据中的模式。因此,这一版本的“涌现”也没有增添太多内容。除非我们期望大型模型去做一些它们没有受过训练的事情,而小型模型则不会,但是这就依赖于定义 (1)。

在定义(4)的背景下,性能的急剧变化现象被发现是由于非连续性的评估标准(例如多选问答等分类任务),而不是LLMs本身(Schaeffer, Miranda, & Koyejo, 2023)。此外,J. Wei自己承认关于急剧变化的当前主张是基于仅在少数规模的模型上得到的结果(如1B, 7B, 13B, 70B, 150B…),如果我们能获得更多不同规模的中间模型数据,性能的增加可能更平滑(Wei, 2023)。

定义(4)中的“不可预测性这一部分”被J. Wei (2023) 重申如下:“即使预测准确性存在显著差异,‘涌现’现象仍然具有研究价值:对于某些问题,大型模型的性能可以从仅1000分之一体积的模型性能中轻松推断;而对于其他问题,即使从两倍大小的模型中也无法推断其性能。”

然而,提到的在计算量减少到原来的千分之一时的可预测性指的是GPT-4报告(OpenAI, 2023),开发人员提前知道了目标评估,并且专门针对它进行了优化。考虑到这一点,可预测性在理论上其实并不奇怪(尽管从工程角度来看仍然令人印象深刻)。这与在计算量减半的未计划BIG-Bench评估中的不可预测性表现形成对比,见(Wei等人, 2022)。这种不可预测性是可以预料到的,仅仅是因为我们不知道训练数据与测试数据的相似性以及模型是否拥有足够的容量来学习特定模式之间的相互作用。

因此,我们有了定义 (1):涌现属性是指模型没有明确训练过的特征。这可以从两个角度来看待。

如果模型没有被该属性的训练数据训练过,那么该属性就是涌现的特性。

- 即使模型曾接触过相关的训练数据,只要开发者对此并不知情,该属性仍然是涌现的特性。

依照定义6,研究问题似乎是“网络上存在哪些数据?”(或生成式AI公司的专有训练数据集等),而我们训练大规模语言模型(LLM)实际上是以一种非常昂贵的方式回答这个问题。例如,ChatGPT可以生成看起来合理的国际象棋走法(但经常是非法的)。如果我们认为ChatGPT是一个“语言”模型,这会让人感到惊讶,但如果知道它是在网络上的文本资料上训练的模型,那么这就不奇怪了,因为这样的资料不仅包括自然语言文本,还包括棋谱等资料、ASCII艺术、MIDI音乐、编程代码等。术语“语言模型”实际上应该称为“语料库”模型 (Veres, 2022)。

根据定义5,我们可以证明,只有当模型在训练数据中没有接触到能够作为模型输出基础的证据时,某些属性才能被认为是涌现属性。也不能是因为在连续表示的潜在空间中的偶然采样。如果我们被允许生成任意数量的样本并随意挑选,我们最终会从一个随机初始化的模型中得到一些流畅的文本——但是根据定义(5),这不应该被视为真正的“涌现属性”。

对于像ChatGPT这样的训练数据未公开的商业模型,这样的证明是不可能实现的。但对于那些所谓的“开放”大型语言模型来说,这仅仅是一个假设(甚至是一种奢望),因为到目前为止,我们还缺乏详细的研究(甚至是一套研究方法)来考虑特定模型输出与训练文本数据的量和类型之间的精确关联。按照定义5,涌现性质是机器学习中的炼金术般的存在——因此,提出此类假设的标准应该是相当高的。

特别是在有相反证据的情况下。

以下是一些实验结果,这些结果使得人们怀疑LLM是否真的具有“未经训练便能展现的新特性”(5),该模型没有接触过具有该性质的训练数据。

- 提示敏感现象(Lu, Bartolo, Moore, Riedel, & Stenetorp, 2022; Zhao, Wallace, Feng, Klein, & Singh, 2021): 大型语言模型(LLMs)对语义上等价的提示做出不同的反应。如果我们说模型具有回答问题的涌现特性,那么提出这些问题的不同方式,尤其是少数样本示例的顺序不同,不应该有影响。最可能的解释是模型对更类似于其训练数据的提示有更好的响应。

- Liang 等人评估了 30 个大型语言模型,并得出结论:“重复受版权保护材料的风险明显与模型准确性相关”(2022, p. 12)。这表明,“记住”更多训练数据的模型表现更好。

- McCoy, Yao, Friedman, Hardy, & Griffiths (2023) 表明,大型语言模型的表现依赖于网络文本中输出词序列的概率。

- Lu, Bigoulaeva, Sachdeva, Madabushi, & Gurevych (2024) 表明,18 个大型语言模型的“涌现”能力大多归因于上下文学习。指令调优促进了上下文学习,但似乎没有独立效果。

- 对于上下文学习本身(首次展示在 GPT-3 (Brown et al., 2020) 中),以及作为“涌现”示例的 Bommasani 等人 (2021, p. 5) 中的例子,Chen, Santoro 等人 (2022) 的结果表明,它只在训练结构与所测试上下文序列类似的 Transformer 中发生。

- Liu 等人 (2023) 报告称,ChatGPT 和 GPT-4 在较旧的基准测试上的表现优于新发布的基准测试,这表明许多评估结果可能因数据污染而被夸大。OpenAI 本身在 GPT-3 论文(Brown et al., 2020)中花费了大量精力展示缓解这一问题的难度。由于我们对最新模型的训练数据一无所知,外部评估结果可能并不具有参考意义,而销售其模型作为商业服务的公司内部的评估报告可能存在明显的利益冲突。

一种广为人知的努力是提出一种方法来避免至少数据污染问题的研究,即“AGI的火花”研究(Bubeck等人, 2023)。使用新构建的测试案例,这些案例与公共网络数据进行对比,并对其进行了扰动,作者们得出结论,GPT-4具备“非常先进的心理理论”。至少有两项研究得出了相反的结论(Sap, Le Bras, Fried, & Choi, 2022; Shapira等人, 2024)。这种方法最可能失败的原因是,虽然我们可以检查网络上的直接匹配,但我们仍然可能会错过一些高度相似的情况(例如,该论文中著名的用tikz绘制的独角兽的例子可能是基于Stack Overflow社区用tikz绘制其他动物的情况)。此外,像GPT-4这样的商业LLM还可以在未公开的数据上进行训练。在OpenAI的情况下,许多研究人员和其他用户通过API提交了大量数据来研究GPT-3,在OpenAI更改其服务条款,停止默认使用此类数据进行训练之前,已经通过API提交了大量数据。

这并不是说LLM在训练分布之外绝对不可能表现得很好,但这不是绝对的。一定程度的泛化确实存在,最好的情况是这些模式在训练数据中独立出现,但并未共同出现,因此导致了某种插值。这些模式在训练数据中单独出现,但并没有同时出现。然而,我们需要在什么时刻认定这些结果是本质上的新事物,什么样的相似性被视为重要,以及我们如何识别这些特征——这些都是尚未解决的研究问题。

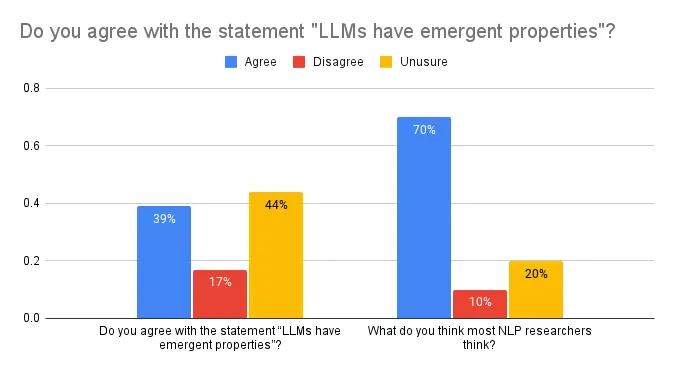

正如我之前提到的,我有机会在几个自然语言处理(NLP)研究小组中介绍这个话题。在这些演讲的开始,在展示上述讨论之前,我向听众提问了几个问题,包括他们个人是否认为大型语言模型(LLMs)具有涌现特性(根据他们个人的定义,如上所述,大多数情况下是(1))。我还问了他们对领域内共识的看法——他们认为其他大多数NLP研究者对此有何看法?对于第一个问题,我收到了259名研究人员和博士生的回答,而对于第二个问题,则收到了360名(提示:下次应留出更多的时间让大家参与投票)。

这些结果令人惊讶:虽然大多数受访者对LLM涌现性质持怀疑或不确定态度(只有39%的人同意这一说法),但70%的人认为大多数其他研究人员确实相信这一点。

这与几种其他错误的社会学信念一致:例如,许多NLP研究人员并不认为NLP排行榜特别重要,或者扩大规模不能解决所有问题,但他们确实认为其他NLP研究人员也持有这种看法(Michael等人,2023)。在我的样本中,认为LLM具有涌现属性的想法仅被少数研究人员持有,但它被误认为是大多数人的看法。即使是这些人中的少数,他们的信念也不是很坚定。在我的四次演讲中,每次在介绍完上述讨论后,我也询问了观众他们的想法。在70份样本反馈中,最初同意“LLM具有涌现属性”这个说法的人中有83%改变了他们的看法,其中13.9%表示不同意,69.4%表示不确定。

回顾来看,“同意/不同意/不确定”并不是这个调查的最佳选项选择。作为科学家,我们几乎不可能做到100%确定:正如Yann LeCun在与Munk的辩论中所说,我们甚至无法证明现在没有茶壶在绕着木星转。我们的工作不是不要陷入这种分散注意力的兔子洞,而是要提出和测试有助于我们正在研究的现象理解的假设。对于大语言模型中的‘涌现’,我认为我们仍然处于‘提出假设’的初期阶段——即使经过了上述关于‘涌现’的澄清工作,我们仍然没有一个明确的研究问题,能够清楚地获得实证证据。

关键问题是,现有的模式需要如何插值,才能被看作是新到足以被归类为自然语言数据领域的“新兴现象”?这个领域特别难,因为它混合了各种信息(语言学的、社会的、事实的、常识的),这些信息可能在上下文中显式存在、隐式存在,或者需要通过推理来理解。关于问答任务中涉及的不同技能的讨论,请参阅Rogers, Gardner, & Augenstein (2023, pp. sec. 8.2)。

📢 如果您(或您认识的人)有兴趣解决大语言模型(LLM)输出与其训练数据之间的关系问题——哥本哈根有一个美丽的城市提供博士后研究员或博士生职位,欢迎前来研究!申请截止日期为2024年11月15日(22/24)。

如果你想引用这篇文章的话:上述大部分观点(不包括民意调查的数据)基于这篇ICML 2024立场论文,该论文还讨论了“涌现现象”的科学哲学含义及其在LLM中的应用。我们还讨论了“大型语言模型”具体指的是什么(相对于“基础”和“前沿”模型),以及几个常见的带有大量脚注的声明:LLM是稳健可靠,LLM是最先进的技术,(LLM)规模至上的说法,LLM是通用工具。

感谢:

- 我的优秀合著者 Sasha Luccioni

- 上述论文的所有匿名审稿人

- Rob van der Goot, Christian Hardmeier, Yacine Jernite, Margaret Mitchell, Dennis Ulmer,他们对早期版本提供了反馈

- Ryan Cotterell, Ishita Dasgupta, Laura Gwilliams, Julia Haas, Anna Ivanova, Tal Linzen, Ben Lipkin, Asad Sayeed,感谢他们提供的见解和讨论

- 所有在Cambridge LTL,Cardiff NLP,Center for Language Technology @ Copenhagen University,CLASP,CL@Georgetown,Genbench @ EMNLP23(生成基准@EMNLP23),Milan NLP,QMUL,和UMass Amherst的民意调查中回应的人。

原发布于 https://hackingsemantics.xyz ,2024年7月15日.

故事中的所有图片均由作者创作而成。页首图片包含爱德华·冯·隆古斯创作的喷漆壁画《裸体皇帝》,在CC-BY-SA 4.0许可下使用。

-

酒店香薰厂家:创造独特客户体验12-24

-

程序员出海做 AI 工具:如何用 similarweb 找到最佳流量渠道?12-22

-

自建AI入门:生成模型介绍——GAN和VAE浅析12-20

-

游戏引擎的进化史——从手工编码到超真实画面和人工智能12-20

-

利用大型语言模型构建文本中的知识图谱:从文本到结构化数据的转换指南12-20

-

揭秘百年人工智能:从深度学习到可解释AI12-20

-

复杂RAG(检索增强生成)的入门介绍12-20

-

基于大型语言模型的积木堆叠任务研究12-20

-

从原型到生产:提升大型语言模型准确性的实战经验12-20

-

啥是大模型112-20

-

英特尔的 Lunar Lake 计划:一场未竟的承诺12-20

-

如何在本地使用Phi-4 GGUF模型:快速入门指南12-20

-

2025年数据与AI的十大发展趋势12-20

-

用Graph Maker轻松将文本转换为知识图谱12-20

-

视觉Transformer详解12-20