人工智能学习

如何在本地使用Phi-4 GGUF模型:快速入门指南

微软的Phi-4是一款最近发布的高级语言模型,采用GGUF格式。该模型支持本地部署和使用。本指南将指导您在自己的机器上安装和使用Phi-4 GGUF的过程,让您能够利用其进行各种自然语言处理任务。

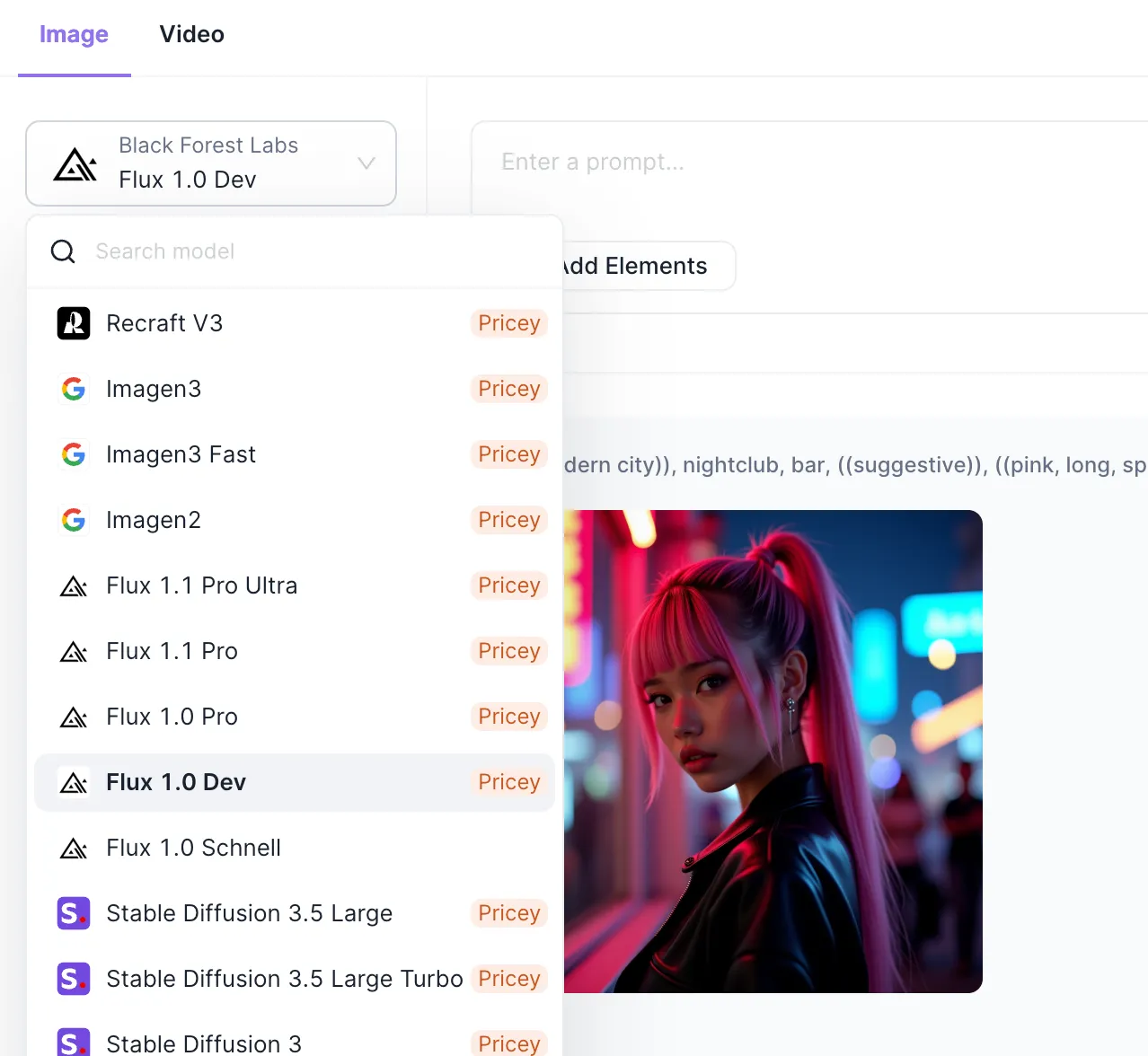

如果你在寻找一个集成了所有功能的人工智能平台,它可以集中管理所有AI订阅,包括但不限于:

- 几乎任何大型语言模型,例如:Claude 3.5 Sonnet,Google Gemini,GPT-40 和 GPT-o1,Qwen 模型及其他开源模型。

- 你甚至可以使用未经过滤的 Dolphin Mistral 和 Llama 模型!

- 最佳的 AI 图像生成模型,例如:FLUX、Stable Diffusion 3.5 和 Recraft

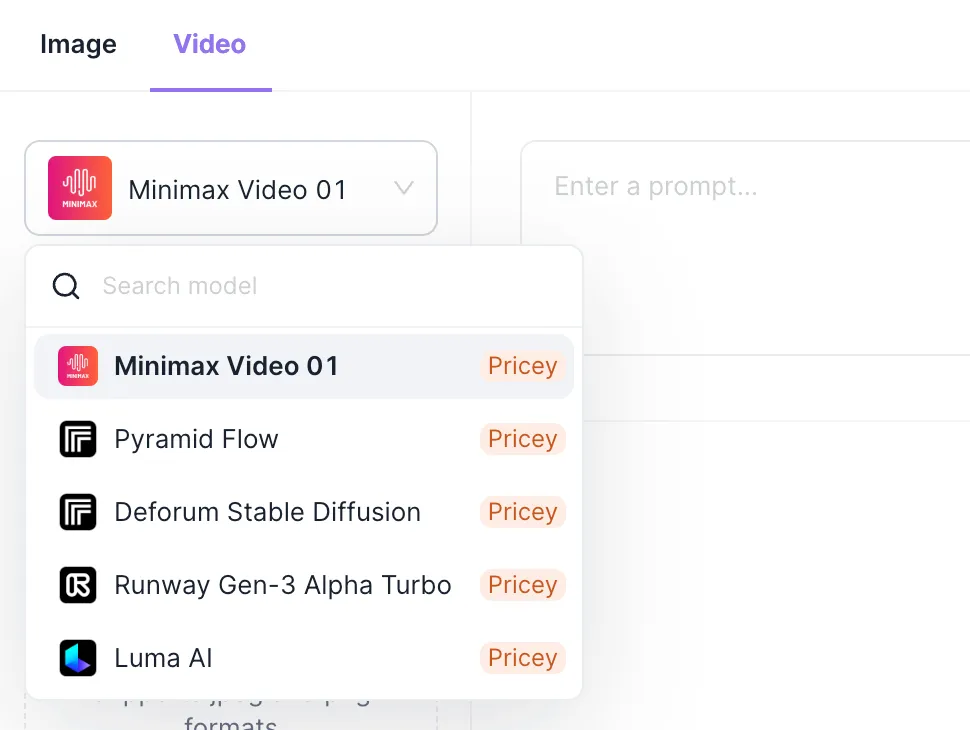

- 你甚至可以将 Minimax、Runway Gen-3 和 Luma AI 这样的 AI 视频生成模型与 Anakin AI 一起使用

Phi-4 是微软 Phi 系列语言模型的最新迭代。它代表了人工智能技术的显著进步,旨在更高效和更准确地处理各种语言任务。GGUF(GPT 生成的统一格式)是一种文件格式,用于在消费级硬件上高效加载和推理大型语言模型。

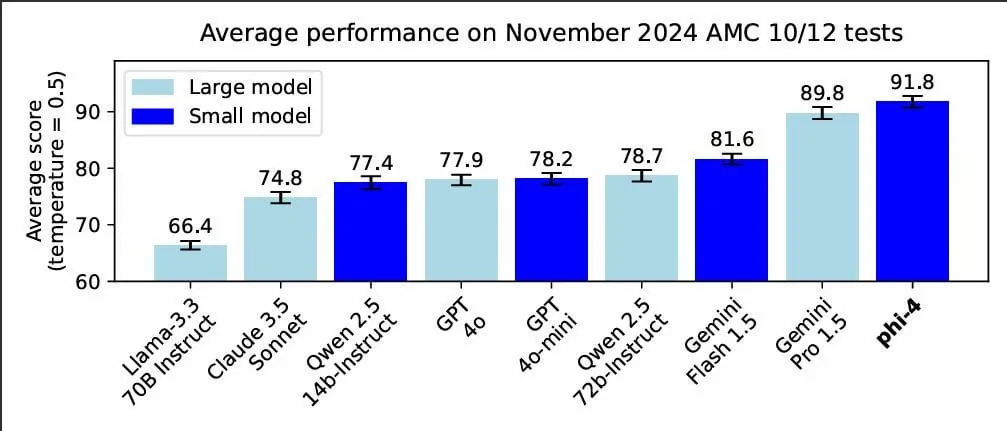

微软Phi-4性能基准

Phi-4的关键特点如下:

高级自然语言理解,改进的上下文保持能力,以及在各种NLP任务上的表现得到增强。

关于GGUF格式的优势:

- 更小的内存占用

- 更快的加载速度

- 更适合消费级硬件

我们来看看Phi-4和其他流行模型在AMC 10/12测试中的表现对比。

要开始使用Phi-4 GGUF,首先需要下载模型文件。截至目前,一个非官方的版本可以通过Hugging Face上某个社区成员的仓库获取。

下载步骤如下:

- 访问Hugging Face仓库:https://huggingface.co/matteogeniaccio/phi-4/tree/main

- 根据您的需求选择合适的量化版本(Q8_0、Q6_K或f16)

- 下载您选择的模型文件

请注意:微软官方很快就会发布,可能会包含更多功能和优化。

在运行Phi-4 GGUF之前,配置环境,安装所需的工具和依赖项。所需软件包括:

- Python 3.7 或更高版本(推荐使用)

- Git(用于克隆代码库)

- 兼容的推理引擎(如 llama.cpp 或 Ollama)

安装步骤:

- 如果没有安装,从官方网站安装Python

- 如果您的系统中没有Git,从git-scm.com下载并安装Git

- 选择并安装一个推断引擎(详情请见下文)

llama.cpp 是一个流行的推理工具,用于在本地运行大规模语言模型。下面是如何设置它以配合 Phi-4 GGUF 使用。

开始搭建 llama.cpp:

- 首先,克隆 llama.cpp 代码库:

在终端输入以下命令克隆代码库:

git clone https://github.com/ggerganov/llama.cpp.git

使用git clone命令来克隆仓库。

- 进入克隆后的文件夹。

cd llama.cpp # 切换到名为llama.cpp的目录

- 来构建项目吧:

做

使用 Phi-4 和 llama.cpp:

- 将下载的Phi-4 GGUF文件放于models目录中

- 使用下面的命令运行这个模型:

./main -m models/phi-4-q8_0.gguf -n 1024 --repeat_penalty 1.1 --temp 0.1 -p "在这里输入您的提示语"

根据您的具体需求调整参数。

更多详情请参考这个 PR 在 llama.cpp 仓库里的内容。

Ollama 是另一个优秀的工具,用于本地运行语言模型,拥有更友好的用户界面。以下是安装 Ollama 的步骤:

- 浏览 https://ollama.ai/ 并下载适合您操作系统的版本并安装

- 按照网站上的安装指南进行操作

在 Ollama 中运行 Phi-4 模型。

- 创建一个名称为

Modelfile的文件,其内容如下:

试试这个命令来测试模型:看看效果如何:

运行ollama run vanilj/Phi-4

更多详情请见链接:

Phi-4 GGUF 代表在使高级语言模型可供本地部署方面是一个重大进步。通过遵循本指南,你现在应该能够下载、设置和使用 Phi-4 GGUF 进行各种自然语言处理任务。在探索其功能的过程中,请随时关注 AI 和语言模型领域的最新发展和最佳实践。

-

自建AI入门:生成模型介绍——GAN和VAE浅析12-20

-

游戏引擎的进化史——从手工编码到超真实画面和人工智能12-20

-

利用大型语言模型构建文本中的知识图谱:从文本到结构化数据的转换指南12-20

-

揭秘百年人工智能:从深度学习到可解释AI12-20

-

复杂RAG(检索增强生成)的入门介绍12-20

-

基于大型语言模型的积木堆叠任务研究12-20

-

从原型到生产:提升大型语言模型准确性的实战经验12-20

-

啥是大模型112-20

-

英特尔的 Lunar Lake 计划:一场未竟的承诺12-20

-

2025年数据与AI的十大发展趋势12-20

-

用Graph Maker轻松将文本转换为知识图谱12-20

-

视觉Transformer详解12-20

-

2030年,这将是科技界最重要的技能。12-20

-

基于知识图谱构建带LLama 3.1的智能药物副作用查询代理12-20

-

动态表格学习:轻松入门与实践教程12-20