C/C++教程

CVPR 2024 最佳论文综述:全面概览

一个在人工智能领域享有盛誉的会议,CVPR(计算机视觉和模式识别会议),目前正在2024年6月17日至21日于西雅图(美国)举行。本届会议共收到了超过11,532篇论文提交,其中只有2,719篇被接受,整体接受率为23.6%。

在本文中,我将为你全面概述计算机视觉领域的趋势,通过展示这一届中一些最有趣(根据我个人高度主观且无疑非常聪明的判断)和创新的论文。

目录:- 最佳论文奖获奖者

- 视觉变压器

- 扩散模型

- 大型语言模型

- 参考文献

今年,有两篇论文获得了最佳论文奖:

生成图像动态(郑奇李等人):

在这篇论文中,研究人员提出了一种从单张图像生成逼真动画的新方法。该模型是在从真实视频序列中提取的运动轨迹集合上进行训练的。密集和长期的运动在傅里叶域中被建模为谱体。可能的应用包括:

- 图像到视频:通过为静止图像添加动画效果。

- 无缝循环:作者指出了在训练过程中难以找到无缝循环的视频集合的困难;此方法可以解决这一需求(详情请参阅论文)。

- 从单张图像生成交互动态。

© 来自 Generative Image Dynamics (generative-dynamics.github.io) 的插图

丰富的用户反馈在文本到图像生成中的应用(Y Liang等人):

受人类反馈增强的强化学习(RLHF)在大型语言模型(LLMs)中取得成功的启发,本文提出了首个用于图像生成的人类评论数据集,该数据集基于18,000张图像收集(RichHF18K)。与以往依赖人类收集的评分来改进模型的工作不同,Y. Liang等人进一步提出通过标记图像中生成不佳的部分来推进研究。

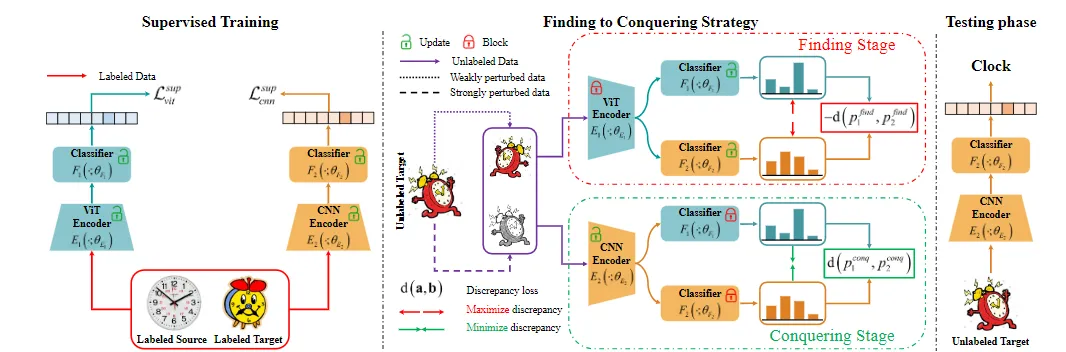

2. 视觉变压器在ViT上学习CNN:一种混合模型,用于领域适应中的显式类特定边界(Ngo, Do-Tran等人):

本文提出了一种结合CNN和ViT的混合方法,以利用这两种架构的优点。ViT由于能够捕捉全局表示而表现出色,而CNN则因其能够捕捉局部表示而著称。这种方法被称为显式类特定边界(ECB),与传统的领域适应方法相比,表现更好。

© 提出的从发现到征服策略的框架图 — 图片来自 在ViT上学习CNN:一种用于域适应的显式类特定边界的混合模型 | 项目页面 (dotrannhattuong.github.io)

在视觉变压器的每个阶段你只需要较少的注意力(Zhang, liu et al.) :

在这篇论文中,重点在于每一层中实际需要的注意力计算及其带来的巨大成本。确实,训练一个Vision Transformer(ViT)可能非常耗时,尤其是在计算复杂性和注意力饱和度不断增加的情况下。为了解决这两个问题,研究人员提出了一种新方法,即在每一阶段仅计算少数几个注意力操作,并利用之前计算的变换。

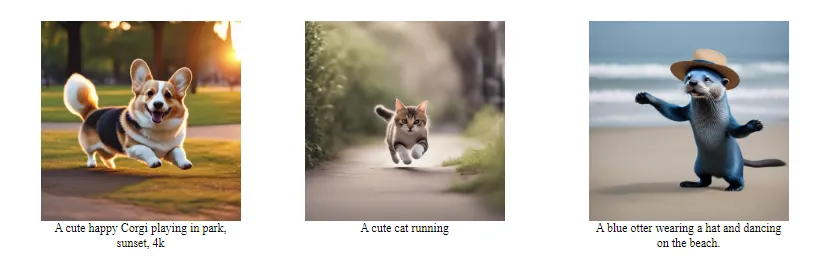

3. 扩散模型:GenTron:用于图像和视频生成的扩散变换器(陈,徐等):

GenTron旨在成为基于Transformer的新型扩散模型,用于图像和视频生成。众所周知,计算机视觉(CV)中用于图像生成的最优秀的模型基于CNN。这项研究证明了我们可以构建能够与现有最佳模型相媲美的模型,以下是他们是如何做到的:

- 将扩散变换器(DiTs)从类别适应到文本条件(更多信息见此处)。

- 从9亿参数增加到超过30亿参数以提高图像质量。

- 将GenTron扩展到无运动引导的文本到视频生成。

© 图像来自 GenTron (shoufachen.com)

4. 大型语言模型:大型语言模型是低样本图像分类的良好提示学习者(Zheng等人):

近年来,基于少量样本学习的视觉模型有了显著的增长,模型不再需要成千上万的图片进行训练。值得一提的是,像CLIP这样的预训练视觉语言模型因其强大的泛化能力而崭露头角。

在这篇论文中,作者旨在利用大规模语言模型(LLMs)的广泛知识来构建更强大的视觉模型。他们提出了 LLaMP(Large Language Models as Prompt learners),该模型为 CLIP 的文本编码器生成自适应提示。

LLaMP 在零样本泛化和少量样本学习方面已经超过了最先进的方法。然而,由于目前视觉与大语言模型之间的交互仍然较为表面,改进视觉模型可能会带来更好的性能。

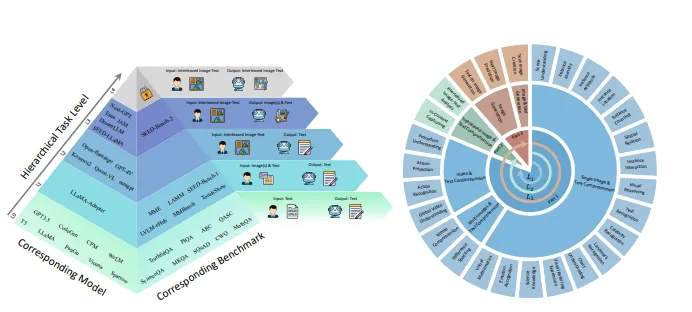

SEED-Bench-2: 多模态大型语言模型基准测试 (Li, Ge 等) :

目前我们正在研究多模态大语言模型(LLMs),这篇论文恰逢其时。确实,到目前为止,还没有一个真正的基准来评估不同多模态大语言模型及其性能。当我们想要测试它们时,通常会转向最知名的那一个(即LLaVa),这通常是我们的首选(好吧,这是我这么说 :D)。在这篇论文中,你会发现一个多模态大语言模型(MLLMs)的分类,基于从L0到L4的层级水平,这取决于它们可以接受和生成的模态。作者还提出了SEED-Bench-2,一个全面的基准,用于评估多模态大语言模型的层级能力。

MLLMs 的分层能力级别概述和 SEED-Bench-2 的 27 个评估维度概述 — © 图片来自 2311.17092 (arxiv.org)

幻觉增强的对比学习用于多模态大型语言模型 (Jiang 等) :

在这篇论文中,作者提出了一种基于对比学习的新方法来解决多模态大语言模型中的幻觉问题。

对比学习 是一种无监督表示学习的深度学习技术。其目标是学习数据的表示,使得相似的实例在表示空间中距离较近,而不相似的实例距离较远。 — 对比学习 | Papers With Code

该方法非常直接,使用包含幻觉的文本作为硬负例。这种方法有助于将非幻觉文本的表示拉近到视觉表示,同时将非幻觉文本的表示与幻觉文本的表示拉开距离。

该方法相比MiniGPT-4提升了34.66%,相比LLaVA提升了29.5%(我之前在几个月前的另一篇文章中提到过LLaVA,链接这里)。

结论在本文中,我简要介绍了我认为具有创新性的几篇论文,当然还有很多我没有探索过的。敬请期待潜在的第二部分,我们将更深入地探讨计算机视觉这一令人着迷的领域。

生成图像动态

丰富的用户反馈在文本到图像生成中的应用

在ViT上学习CNN

[2406.00427] 在视觉变压器中,每个阶段只需要较少的注意力 (arxiv.org)

GenTron

大型语言模型是低样本图像分类的良好提示学习者 (thecvf.com)

[2311.17092] SEED-Bench-2: 多模态大型语言模型的基准测试 (arxiv.org)

[2312.06968] 用于多模态大型语言模型的幻觉增强对比学习(arxiv.org)

-

文件掩码什么意思?-icode9专业技术文章分享12-27

-

如何使用循环来处理多个订单的退款请求,代码怎么写?-icode9专业技术文章分享12-27

-

VSCode 在编辑时切换到另一个文件后再切回来如何保持在原来的位置?-icode9专业技术文章分享12-27

-

Sealos Devbox 基础教程:使用 Cursor 从零开发一个 One API 替代品 审核中12-27

-

TypeScript面试真题解析与实战指南12-27

-

TypeScript大厂面试真题详解与解析12-27

-

怎么使用nsenter命令进入容器?-icode9专业技术文章分享12-26

-

导入文件提示存在乱码,请确定使用的是UTF-8编码怎么解决?-icode9专业技术文章分享12-26

-

csv文件怎么设置编码?-icode9专业技术文章分享12-26

-

TypeScript基础知识详解12-25

-

安卓NDK 是什么?-icode9专业技术文章分享12-25

-

caddy 可以定义日志到 文件吗?-icode9专业技术文章分享12-25

-

wordfence如何设置密码规则?-icode9专业技术文章分享12-25

-

有哪些方法可以实现 DLL 文件路径的管理?-icode9专业技术文章分享12-25

-

错误信息 "At least one element in the source array could not be cast down to the destination array-icode9专业技术文章分享12-25