人工智能学习

从单声道到立体声:AI如何为音乐注入新活力

DALL-E 3生成的图片。

单声道录音就像是历史的快照,但它们缺乏让音乐听起来更鲜活的空间感。利用AI,我们可以将单声道录音转换成立体声,甚至可以重新混音现有的立体声录音。在这篇文章中,我们将探讨单声道转立体声的实际应用案例和方法。

这张照片由 J 拍摄,来自 Unsplash。

当乐团现场演奏时,声音的波动从不同的乐器通过房间传到您的耳朵。这导致了时间上的差异(声音何时到达您的耳朵)和响度上的差异(每个耳朵听起来有多响)。通过这一过程,一场音乐表演不仅仅是和声、音色和节奏。每件乐器都带来了空间信息,让听众沉浸在一种“当下”的体验中,抓住了他们的注意力和情感。

倾听第一个片段(没有空间信息)和第二个片段(左右耳朵有明显差异)的不同之处:

文章中强烈推荐使用耳机,但并非绝对必要。

例子:Mono

原曲来自Lexin Music,适用Pixabay的内容使用协议。

例子:立体声音响

这首曲子由 Lexin Music 制作。Pixabay 的 内容许可协议 适用于此。

正如你所听到的,录音中包含的空间信息对我们感受到的生动性和兴奋有着强烈的影响。

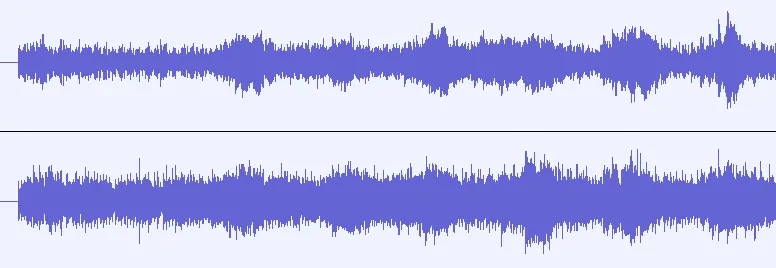

在数字音频领域中,最常见的格式是 单声道 和 立体声。单声道格式只包含一个音频信号,在耳机两侧听起来完全一样(我们称之为 声道,或简称为 道)。立体声格式则包含两个独立的信号,分别完全分布在左右两个声道。

一个包含分别代表左右声道的两个声道的立体声音频波形示例图。图由作者。

现在我们已经体验了立体声如何让听觉体验变得更加生动和吸引人,并且我们也了解了关键术语,我们可以更深入地探讨我们接下来要讨论的内容:AI在单声道转立体声中的作用,也称为单声道转立体声的上混。

AI本身并不是目的。为了使开发和使用这种先进技术合理化,我们需要具体应用。单声道转立体声的应用场景有。

虽然立体录音技术早在20世纪30年代初就被发明出来了,但直到20世纪60年代才在录音棚成为标准,甚至更晚才开始在普通家庭中流行起来。到了50年代末,新上映的电影仍然会附带一个立体声轨和一个额外的单声道音轨,以适应尚未安装立体声系统的影院。简单来说,有很多流行歌曲是在单声道下录制的。例如:比如The Beatles的《Yesterday》就是一首经典的单声道歌曲。

- Elvis Presley: 就是这样了 (That's All Right)

- Chuck Berry: 约翰尼,你走好 (Johnny Be Good)

- Duke Ellington: 乘A线 (Take the 'A' Train)

“埃尔维斯·普雷斯利:就是这样”这首1954年发布的单声道录音版本的官方录音

即使在今天,业余乐手也可能发布单声道录音,要么是因为技术水平不够,要么就是懒得制作立体声。

将单声道转换成立体声可以让我们以前喜爱的老录音以全新的方式体验,并且也可以使业余录音或示范曲目更加生动。

即使有立体声录音可用,我们仍然可能想要提升它。虽然很多60年代和70年代的录音是立体声录制的,但每件乐器都被完全独占一边。不妨听听大门乐队的《灵魂厨房》,你会发现贝斯和鼓完全在左边,键盘和吉他则在右边,人声则居中。这首歌确实不错,有种独特的美感,但这样的立体声混音可能不会赢得现代听众的青睐。

过去的技术限制影响了立体声的效果。此外,立体声混合不仅仅是一种技艺,它也是艺术创作的一部分。立体声混音虽然在客观上可能很好,但仍可能在风格上不协调。可以使用立体声转换工具来创建一个更符合某些风格偏好的版本。

现在我们讨论了单声道转立体声技术的相关性之后,你可能想知道它内部是如何运作的。实际上,有多种基于AI的方法可以解决这个问题。接下来,我将介绍四种不同的方法,范围从传统的信号处理到生成式的AI。这并不是一个详尽的方法列表,而是过去20年里解决这个问题的部分灵感来源。

在机器学习如今天这般流行之前,音乐信息检索(MIR)领域 一直被精心设计的智能算法所主导。因此,类似的 mono-to-stereo 上混方法也并不罕见,这并不令人惊讶。

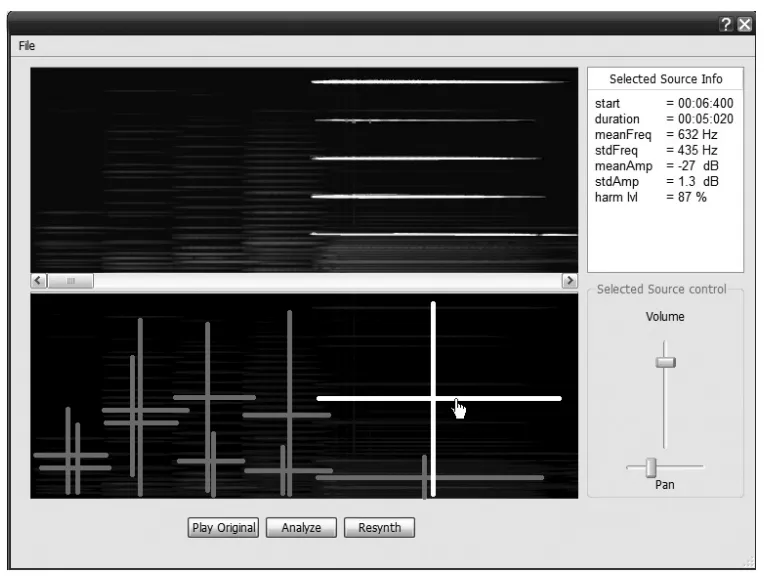

一个2007年的学术论文(Lagrange, Martins, Tzanetakis, [1])的主要想法其实很简单:

如果我们可以找到录音中不同的声音来源并从信号中把它们提取出来,我们就可以重新混合,从而获得真实的立体声体验。

这听起来简单,但我们要如何区分信号中的声源呢?怎么定义这些声源,让算法能够从中分离出来?这些问题很难解决,这篇论文采用了多种高级技术来实现这一点。说白了,这就是他们的解决方案:

- 将录音分割成短片段,并识别每个片段中的峰值频率

- 利用聚类算法将哪些峰值分组到同一个声音来源

- 决定每个声音来源在立体声混音中的位置(手动步骤)

- 对每个声音来源,从信号中提取其频率

- 将所有提取的声音来源混合在一起,最终形成立体声混音

这是为研究设计的用户界面示例。用户会浏览所有提取的来源,并手动将它们放入立体声混音中,最后重新合成整个信号。图片来自 [1]。

虽然细节很复杂,但直觉很清楚:找到来源,提取它们,再把它们混回来。

自拉格朗日2007年的论文以来,已经过去了很长一段时间。自从Deezer在2019年发布了他们的stem拆分工具Spleeter以来,基于AI的源分离系统变得极其有用和实用。现在,像Lalal.ai或Audioshake这样的领先公司,使得快速实现变得容易。

- 使用免费或商业的 Stem 分离器将单声道录音分离成单独的声部。

- 将这些声部加载到数字音频工作站 (DAW) 中,并根据您的喜好进行混音至您满意。

这种方法在2011年的一篇研究论文中被提出(参见 [2]),但因为最近茎分离工具的改进,它现在变得更为实用了。

源分离方法的缺点是它们会产生明显的听觉伪影,因为源分离本身还存在一些不足,而且这些方法仍然需要人工干预进行混音,因此只能算作半自动的。

要实现单声道到立体声的全自动混音,需要使用机器学习。通过学习真实的立体声混音,机器学习系统可以调整人类制作人的混音风格。

这张照片由 Zarak Khan 在 Unsplash 分享。

在2023年ISMIR会议上,Serrà和他的团队提出了一种非常有创意且高效的利用机器学习进行单声道到立体声的上混的方法(3)。这项工作基于一种称为参数立体声的音乐压缩技术。立体声混音包含两个音频通道,在低带宽环境下(比如音乐流媒体、广播电台或电话连接)难以融合。

参数立体声是一种从单一的单声道信号生成立体声的技术,通过关注大脑用来判断声音来源的重要空间提示。这些线索是:

- 左耳和右耳声音的音量差异(双通道强度差,IID)

- 左右耳声音在时间或相位上的差异(双通道时间或相位差)

- 左右耳信号的相似度或差异度(双通道相关性,IC)

通过这些参数,可以从单一信号中创造出类似立体声的效果。

研究人员采用以下方法来开发他们的单声道到立体声混音模型:

- 收集一大型立体声音轨的数据集

- 将立体声音轨转换为参数立体声(单声道音轨加上空间参数)

- 训练一个神经网络,以根据单声道录音预测空间参数

- 使用训练好的模型从单声道信号中推断空间参数,并将其与单声道信号结合,以获得参数立体声体验

目前,这篇论文似乎没有提供任何可以获取的代码或演示听力样本。作者们自己也承认说“专业立体声混音与所提出的方法之间仍存在一定的差距”(第6页)。不过,该论文概述了一种利用机器学习实现全自动单声道到立体声转换过程的既创新又高效的方法。

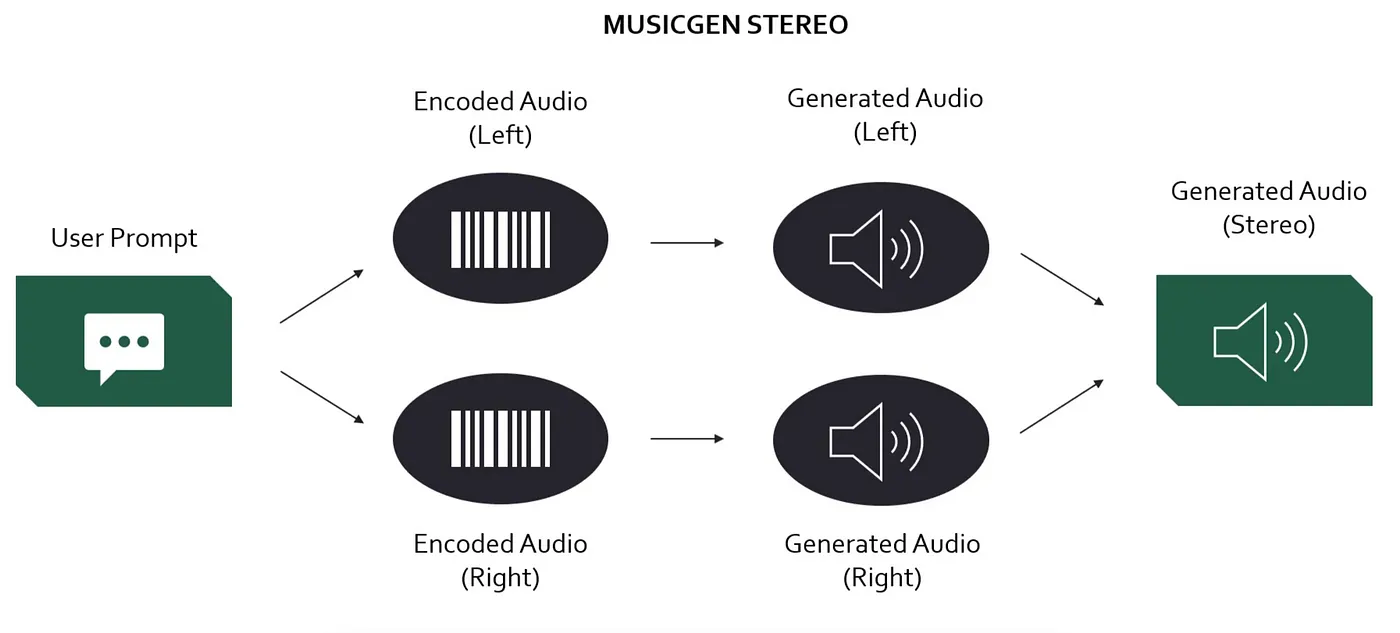

生成型AI:基于Transformer的生成

立体声生成技术在Meta的音乐生成模型MusicGen中。这张图片来自作者的另一篇文章,更多信息参见原文链接。

现在,我们将要探讨看似最直接的方法是从单声道生成立体声。将其训练成可以将单声道输入直接转换为双声道输出。虽然概念上很简单,但从技术角度看,这是最具挑战性的方法。一秒钟的高分辨率音频有44.1k个数据点。因此,生成一首三分钟的立体声歌曲意味着生成超过1500万的数据点。

随着当今的技术如卷积神经网络、变压器和神经音频编解码器,这项任务的复杂性已经变得可以处理。有一些论文选择直接生成立体声信号(参见[4],[5],[6])。然而,只有[5]训练了一个可以直接用于单声道到立体声生成的模型。我觉得还有空间撰写一篇专注于“简单”的单声道到立体声生成任务的论文,并且完全致力于解决这一目标。有谁在找博士论文题目吗?

照片由 Samuel Spagl 在 Unsplash 上分享

在结束这篇文章之前,我想讨论一下单声道转立体声领域的未来发展方向。最重要的是,我发现这一领域的研究相当有限,与那些热门话题,比如文本生成音乐相比。我认为研究社区应该关注以下几个重点,以提升单声道转立体声研究的水平:

在这个研究领域里,只有少数几篇论文被发布。更令人沮丧的是,这使得许多论文并没有与社区分享他们的代码或工作结果。我多次读到一篇篇令人着迷的论文,却发现唯一能验证该方法输出质量的方式是自己理解论文中的每一个公式,并从零开始自己实现算法。

分享代码和创建公开演示从未如此简单。研究人员应该优先考虑,让更多的音频爱好者能够理解和欣赏他们的工作。

传统的信号处理和机器学习确实很有趣,说到输出质量这一块,现在已经离不开生成式AI了,这一点无可否认。文本转音乐模型已经能生成听起来很棒的立体声混音。为什么还没有一个易用的、最先进的单声道转立体声的工具库呢?

从我的研究来看,构建一个高效且有效的模型可以通过合理大小的数据集和对现有模型架构及训练方法进行少量到中等程度的改动来实现。在我看来,这就像“直接动手做”的简单任务,不需要太多改动。

一旦我们有了一个优秀的开源上混音处理模型,下一步我们需要的是可控制性。我们不应该被迫在黑盒模型的“要么接受要么放弃的神经网络生成结果”和传统的基于源分离的手动混音技术之间做出选择。我觉得我们能够同时拥有这两者。

这种上混模型可以在大规模数据集上进行训练,然后进行调整,根据用户的输入调整其立体声混音。这样,音乐人可以根据个人喜好调整生成的立体声效果。

简单易用且公开的单声道转立体声技术能够使老旧录音或业余制作焕发生机,同时也让我们能够为喜爱的歌曲制作不同的立体声版本。

尽管已经有多次尝试解决这个问题,但还没有建立一种标准的方法。通过利用最近在生成式AI领域的进步,我们可以创建新的一代单声道到立体声的上混模型。这将使这项技术更加有效,并在社区中更广泛地普及。

我是音乐学专家和数据科学家,在这里分享我对AI与音乐的一些思考。这里有一些我之前与此主题相关的工作。

- 听觉图像:用AI创作惊人的视听艺术

- Meta的AI如何根据参考旋律生成音乐作品

- AI音乐源分离:具体来说它是如何工作的以及为什么如此困难

在 Medium 和 领英 上关注我!

[1] M. Lagrange, L. G. Martins, 和 G. Tzanetakis (2007): “从单声道到立体声的半自动上混音,采用声源分离技术”,在AES Convention 122 (2007)。

[2] D. Fitzgerald (2011): “基于单声道信号源的音轨分离上混处理”,在2011年第17届数字信号处理国际会议(DSP)上发表。IEEE, 2011, pp. 1–7.

[3] J. Serrà, D. Scaini, S. Pascual, 等 (2023): “单声道到立体声的参数化生成”:https://arxiv.org/abs/2306.14647

[4] J. Copet, F. Kreuk, I. Gat 等 (2023): “简单且可控的音乐创作”(2024年1月30日修订).https://arxiv.org/abs/2306.05284

[5] Zang Y., Wang Y. & Lee M. (2024): “Ambisonizer:利用神经网络生成球面调和的上混音技术”. https://arxiv.org/pdf/2405.13428

[6] K.K. Parida, S. Srivastava & G. Sharma (2022): “从单声道到双耳声:利用深度和跨模态注意力生成双耳音频”,发表于2022年WACV会议,第3347-3356页。链接

-

AI元年2024:全球人工智能大事件概览01-02

-

2024年20款热门好用AI工具,助力创作与工作管理01-02

-

揭秘:Fluss 与数据湖Paimon深度解析(一)01-02

-

效率革命:AI工具助力团队沟通12-31

-

消失的一个多月,我用 AI 做了三个项目,简直不要太爽!12-31

-

时间与生产力:如何用 AI 工具高效管理时间12-31

-

火爆全网的AI+视频API推荐12-31

-

??LlamaIndex中的实体链接与关系抽取:使用Relik构建知识图谱12-30

-

Gemini中的批量预测生成12-30

-

用知识图谱提升检索增强生成应用的准确性12-30

-

小规模语言模型的量化技术及混合模式应用12-30

-

知识图谱与大模型:微调 vs. 检索增强生成12-30

-

现代BERT:更先进的文本嵌入模型12-30

-

基于Transformer模型预测用户行为:提升游戏体验与收益12-30

-

揭秘Fluss 与 Kafka、Paimon 的区别与联系12-27