C/C++教程

在Macbook上本地运行Meta Llama 3 80亿参数模型指南

本文主要是介绍在Macbook上本地运行Meta Llama 3 80亿参数模型指南,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

部署新的 Meta Llama 3 模型,并在 M1/M2/M3 Pro MacBook 上使用 Ollama 部署 80亿参数的模型。

Ollama 是一个部署开源大型语言模型(LLM)的平台,可轻松地在您的 Mac、Windows 或 Linux 机器上本地部署。在一台配备 16GB 内存的 M1 Pro MacBook 上,整个设置过程大约需要 10 到 15 分钟。设置完成后,模型会在不到 10 秒的时间内启动。

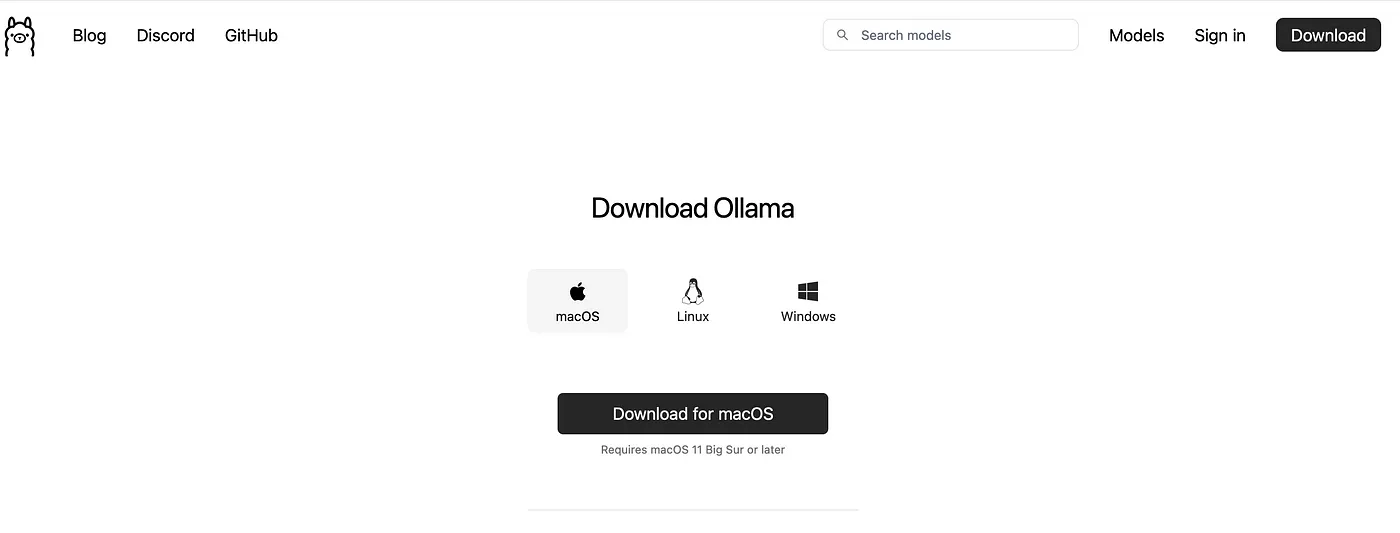

- 去 >> https://ollama.com/download/mac 下载适合您操作系统的软件

我们下载macOS的zip文件并解压缩它。

2. 打开 Ollama 应用并找到 Ollama 应用运行一下 llama3 命令

下载和构建大约需要10到15分钟,这取决于您的网络带宽。您可以打开 http://localhost:11434/ 来检查Ollama是否正在运行。

如果浏览器显示“Ollama 正在运行中”,那就说明一切正常。

4.. 现在我们来运行Ollama,看看它的推理速度如何

最后,让我们为你的macOS添加一些常用的别名快捷方式,以便你快速启动和停止Ollama

vim ~/.zshrc #在文件中添加以下两行命令 alias ollama_stop='osascript -e "tell application \"Ollama\" to quit"' alias ollama_start='ollama run llama3' #在新的会话中运行以下命令以启动或停止Ollama, ollama_start, ollama_stop,5. 其他模型文件的下载

ollama run dolphin-llama3

ollama run mistral

ollama 运行 codellama:7b-code

6. 评估Llama3性能

git clone https://github.com/shadabshaukat/llm-benchmark.git

cd llm-benchmark

python3.11 -m venv venv

source venv/bin/activate

pip install -r requirements.txt

# 确保运行 'ollama serve',以启动 ollama

python benchmark.py --verbose --prompts "What is the sky blue?"

----------------------------------------------------

平均性能指标:

----------------------------------------------------

dolphin-llama3:latest

Prompt 评估时间: 40.44 t/s

响应时间: 30.13 t/s

总计时间: 30.45 t/s

统计:

Prompt 代币数: 25

响应代币数: 576

模型加载时间: 0.00s

Prompt 评估时间: 0.62s

响应时间: 19.12s

总时间: 19.75s

----------------------------------------------------

开心玩AI吧 :)

这篇关于在Macbook上本地运行Meta Llama 3 80亿参数模型指南的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

您可能喜欢

-

增量更新怎么做?-icode9专业技术文章分享11-23

-

压缩包加密方案有哪些?-icode9专业技术文章分享11-23

-

用shell怎么写一个开机时自动同步远程仓库的代码?-icode9专业技术文章分享11-23

-

webman可以同步自己的仓库吗?-icode9专业技术文章分享11-23

-

在 Webman 中怎么判断是否有某命令进程正在运行?-icode9专业技术文章分享11-23

-

如何重置new Swiper?-icode9专业技术文章分享11-23

-

oss直传有什么好处?-icode9专业技术文章分享11-23

-

如何将oss直传封装成一个组件在其他页面调用时都可以使用?-icode9专业技术文章分享11-23

-

怎么使用laravel 11在代码里获取路由列表?-icode9专业技术文章分享11-23

-

怎么实现ansible playbook 备份代码中命名包含时间戳功能?-icode9专业技术文章分享11-22

-

ansible 的archive 参数是什么意思?-icode9专业技术文章分享11-22

-

ansible 中怎么只用archive 排除某个目录?-icode9专业技术文章分享11-22

-

exclude_path参数是什么作用?-icode9专业技术文章分享11-22

-

微信开放平台第三方平台什么时候调用数据预拉取和数据周期性更新接口?-icode9专业技术文章分享11-22

-

uniapp 实现聊天消息会话的列表功能怎么实现?-icode9专业技术文章分享11-22

栏目导航