人工智能学习

可解释性为什么在AI中重要

AI模型结果的解释重要吗?

我的第一个回答是:其实并不是很。

当一个解释只是为了说服我你做出某个决定是有理由的而进行的修辞表演时,我称之为华而不实。如果我正在等待基于我的MRI的癌症诊断结果,我更感兴趣的是将准确性从80%提高到99%,而不是看到一个吸引人的图像来显示证据所在。毕竟,可能需要专家才能看出这些证据。更糟糕的是,证据可能分散得很广,遍布数百万像素,因此没有人类能理解它。仅仅为了让自己感觉好而追寻解释来信任AI是没有意义的。我们真正应该关注的是准确性,如果数据表明结果胜过了人类的表现,那么解释就是不必要的。

但有时候解释不仅仅是修辞上的花言巧语。以下是解释真正重要的时候:

注:原文中的“Here’s”翻译为“此处是指解释真正重要的时候”,以使译文更加通顺。

- 当准确性至关重要,且人类可以 验证 结果时,解释可以帮助你显著降低错误率,例如从1%降到0.01%。

- 当原始预测并不是你唯一关心的内容,且解释可以提供有用的行动时,例如,仅仅说“合同中存在一条不公平的条款”并不如指出这条不公平条款的具体位置有用。突出显示这条不公平条款可以让我们采取行动,比如提议修改合同内容。

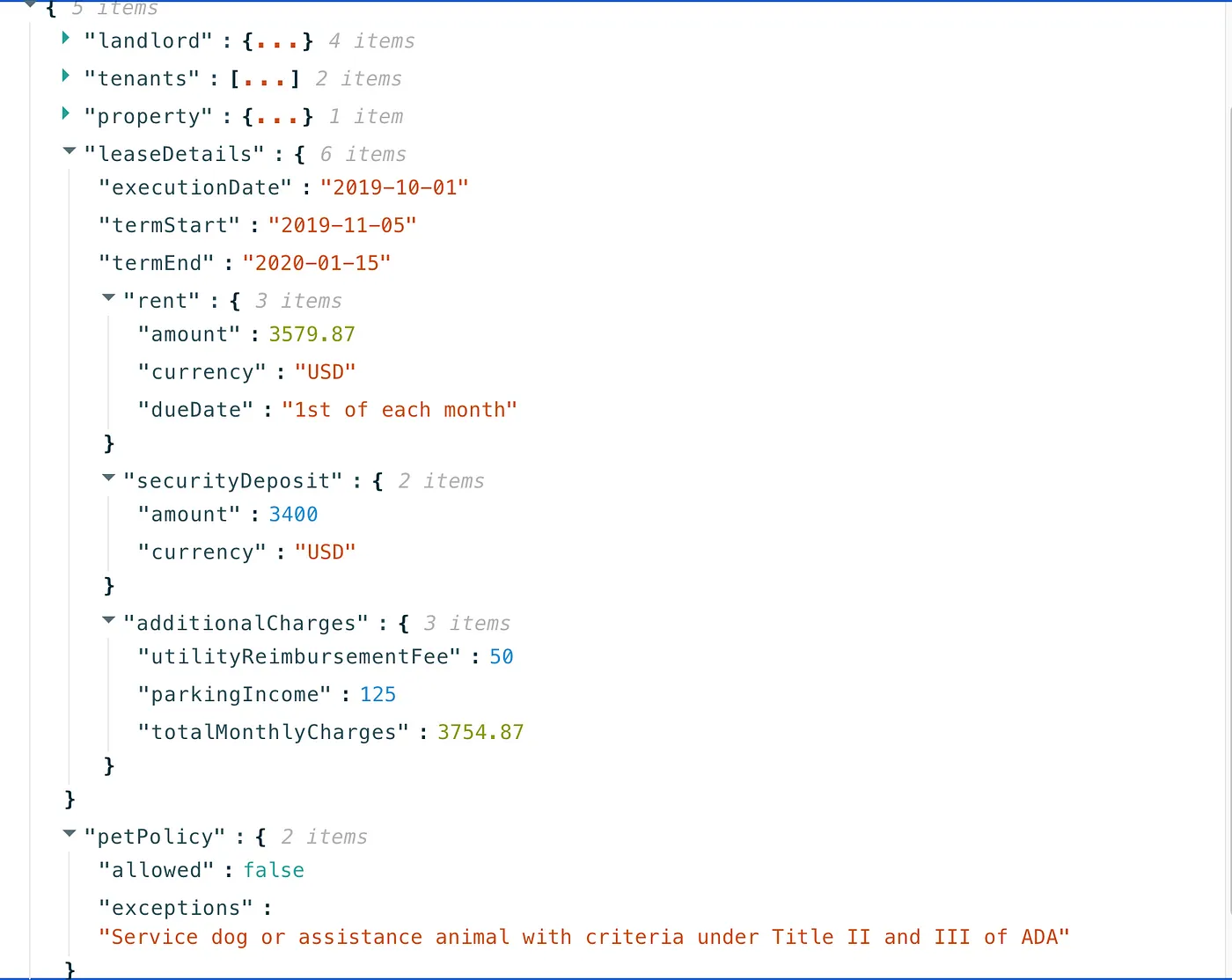

我共同创立了这个服务——DocuPanda,我们以它为例来看一个具体实例。简单来说,我们让用户的复杂文档转换成一个包含一致且正确输出的JSON格式。

所以可能我们扫描整个租房合同,然后发送一个简短的JSON: “{“monthlyRentAmount”: 2000, “dogsAllowed” : true}”。

为了更加具体,这里是我当时在伯克利(加利福尼亚)签订的51页租约,查看我的租约全文(共51页):点击这里。

是啊,旧金山湾区的房租简直高得离谱,谢谢关心我。

如果你不是美国人,你可能会惊讶于需要51页来表述“你得每月付3700美元,以3700美元来换取住在这里的机会”。我认为这可能并不是必要的见此法律文章,不过我岔开话题了。

现在,通过使用Docupanda,我们可以获得明确的答案,比如租金是多少,我可以带我的狗入住吗,入住日期是什么等。

我们来看看提取的这个 JSON 吧

似乎Roxy不能跟我住一起了

如果你一直往下翻,可以看到有一个标志表明不允许带宠物,并且在租赁协议中有说明例外情况。

这里有两个原因说明为什么可解释性会很有用:

- 也许最关键的是我们要把这一点弄清楚。通过查看这一段,我可以确保我们理解政策没有偏差。

- 也许我想要提出一次修改建议。光知道在这些51页中某个地方有宠物禁令帮助不大——我仍然需要翻阅所有页面来提出修改建议。

所以我们这样解决这个问题。我们没有简单地给你一个黑盒子,里面有一个金额,一个真/假结果等——我们设计了DocuPanda,使其预测基于具体的像素位置。你可以点击结果,然后滚动到具体的页面和段落,以此来支持我们的预测。

点击“不允许宠物 = false”,就会直接跳转到写有“如不允许哺乳动物宠物等”的页面。

在DocuPanda,我们发现了三种主要使用可解释性的方式。

第一个模式,我们一开始就知道会是这样的情况,即可解释性可以减少错误并使预测更加可靠。当你有一张金额为12,000美元的账单时,你真的希望有人来核实这个数字是否准确且没有被误用,因为如果这个数字被输入会计自动化软件中,这样风险太大。

文档处理的一个很好的地方在于,人类非常擅长。虽然我们成本较高,但我们物有所值。这使我们处于一个很好的位置,人类可以很高效地验证结果,通常能显著减少错误。

这个范式自然而然地从我们的用户群体中产生出来,一开始我们并没有完全预料到这一点。事实证明,有时候我们不仅想要问题的直接答案,还希望利用AI把正确的信息直接呈现在眼前。之前我已经提到过这种用例——这比展示是什么条款使得合同不公平要无用得多。

作为一个更完整的例子,考虑一家生物研究公司,希望查阅所有生物学出版物以识别能增加土豆糖生产的流程。他们使用DocuPanda来回答以下问题:

糖产量降低为true,相关基因包括:“AP2a”,“TAGL1”

他们的目标 不是 完全依赖 DocuPanda,并计算有多少篇论文提到了某个基因,或者类似的任务。使这一结果有用的是,研究人员可以通过点击来直接获取论文的主要内容。通过点击基因名称,研究人员可以直接跳到提到该基因的部分,并判断论文中提到的涉及该基因和糖的过程是否与他们的研究有关。这种情况中,解释比单纯的答案更重要,可以提高高知识工作者的工作效率。

还有一个让解释发挥作用,并确保人类参与其中的理由。除了降低错误率(通常),它们还证明你有一个合理且符合法律规定的程序。

监管机构关心流程。一个产生错误的黑盒子并不是一个可靠的流程。能够追溯每个提取的数据点到原始来源,让你能够为审核和批准结果提供一个检查点。即使这个人并没有减少错误,有人参与的过程在法律上更有用。这将流程从盲目的自动化,公司需要对此负责,转变为由人类驱动的流程,人类可以接受一定的文书错误率。一个相关的例子是,监管机构和公众对完全自主驾驶系统每英里致命事故的容忍度远低于对辅助驾驶工具的容忍度。我个人认为这在道德上难以接受,但我并不制定规则,我们只能按照这些规则行事。

通过让我们有能力让人类接手,你从完全自动化所带来的法律上复杂的领域转移到了更为熟悉的法律领域,即人类分析师使用一个速度和生产力提高10倍的工具(和我们一样偶尔会犯错)。

所有图片均属作者所有

-

实战:30 行代码做一个网页端的 AI 聊天助手11-20

-

5分钟搞懂大模型的重复惩罚后处理11-18

-

基于Ollama和pgai的个人知识助手项目:用Postgres和向量扩展打造智能数据库11-18

-

我用同一个提示测试了4款AI工具,看看谁设计的界面更棒11-15

-

深度学习面试的时候,如何回答1x1卷积的作用11-15

-

检索增强生成即服务:开发者的得力新帮手11-15

-

技术与传统:人工智能时代的最后一袭纱丽11-15

-

未结构化数据不仅仅是给嵌入用的:利用隐藏结构提升检索性能11-15

-

Emotion项目实战:新手入门教程11-15

-

7 个开源库助你构建增强检索生成(RAG)、代理和 AI 搜索11-15

-

Vertex AI上下文缓存与Gemini模型详解11-15

-

用可视化评估你的检索增强生成系统:RAG系统的评估与分析11-15

-

强化学习:教智能代理操作发电厂的方法11-15

-

质量工程师眼中的检索增强生成(RAG)解析11-15

-

让我们聊一聊算法和社会媒体那些事儿11-15