云计算

数据工程技术路线图

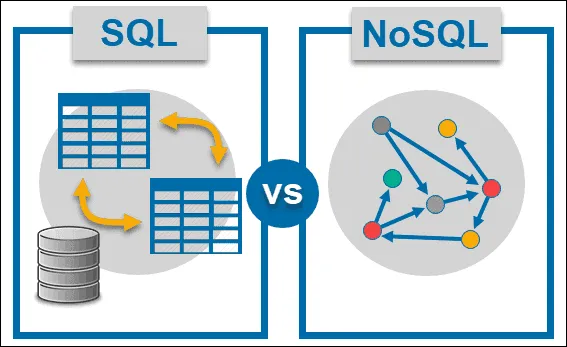

- 熟悉数据库概念(SQL 和 NoSQL)

- SQL— SQL 数据库在数据工程中广泛用于结构化数据的存储和查询,提供 ACID 一致性,确保强一致性。 —(1 周)。

- NoSQL— NoSQL 数据库因其可扩展性和处理非结构化或半结构化数据的灵活性而被广泛采用,常用于分布式系统中进行高吞吐量和高速度的数据处理。 —(1 周)。

-[掌握分布式计算原理](https://medium.com/p/4d544d120fec )

- 理解分布式计算原理对于数据工程师来说,设计可扩展和容错系统是至关重要的,利用并行处理和分布式存储高效管理大规模数据集,确保数据处理操作具有高可用性和可靠性。 — (1至2周)

-了解不同的数据建模技术(例如,关系型、网状型…)

- 数据建模技术,例如关系模型和维度模型,在数据工程中对于高效地组织数据以满足特定的分析和报告需求至关重要,确保最佳性能和易于数据检索。— (1–2 周).

理解数据的规范化和非规范化

- 理解规范化和反规范化的原则有助于数据工程师设计数据库,以在减少冗余和维护数据完整性之间取得平衡,从而在数据工程管道中优化存储空间和查询性能。 — (1周)

探索各种用例下的架构设计

- 架构设计的考虑因素在数据工程中扮演着至关重要的角色,影响数据存储、检索和分析的效率,适用于各种应用场景,确保数据系统的可扩展性、灵活性和可维护性,适应各种应用场景。 — (一至两周)

- 精通数据库管理和调优。

- 精通数据库管理与优化,使数据工程师具备优化数据库性能的技能,通过索引、查询优化和资源分配等策略,提高数据工程环境下的数据系统的效率和响应速度。 — 通常需要2–3周。

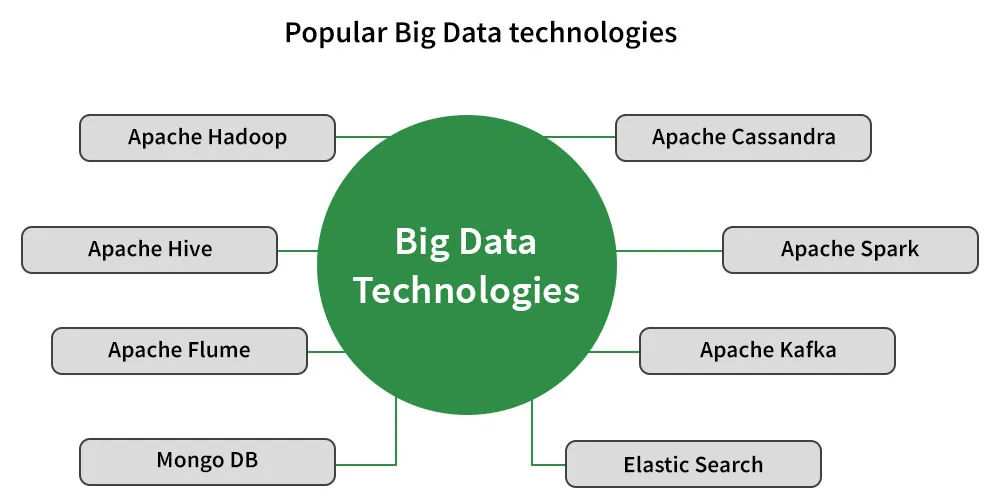

了解或研究批处理框架(例如,Apache Spark,Hadoop MapReduce等)。

- 批处理框架如 Apache Spark 和 Hadoop MapReduce 在处理大规模数据的定期批次时至关重要,它们支持并行计算并具备容错能力,从而支持数据密集型任务。— (1–2 周).

- 了解流处理框架如 Apache Kafka、Apache Flink。

- 流处理框架,如 Apache Kafka 和 Apache Flink,在数据工程中扮演着关键角色,通过实现实时数据的处理和分析、促进低延迟的数据摄入以及支持持续的数据流应用程序。 — (1–2 周).

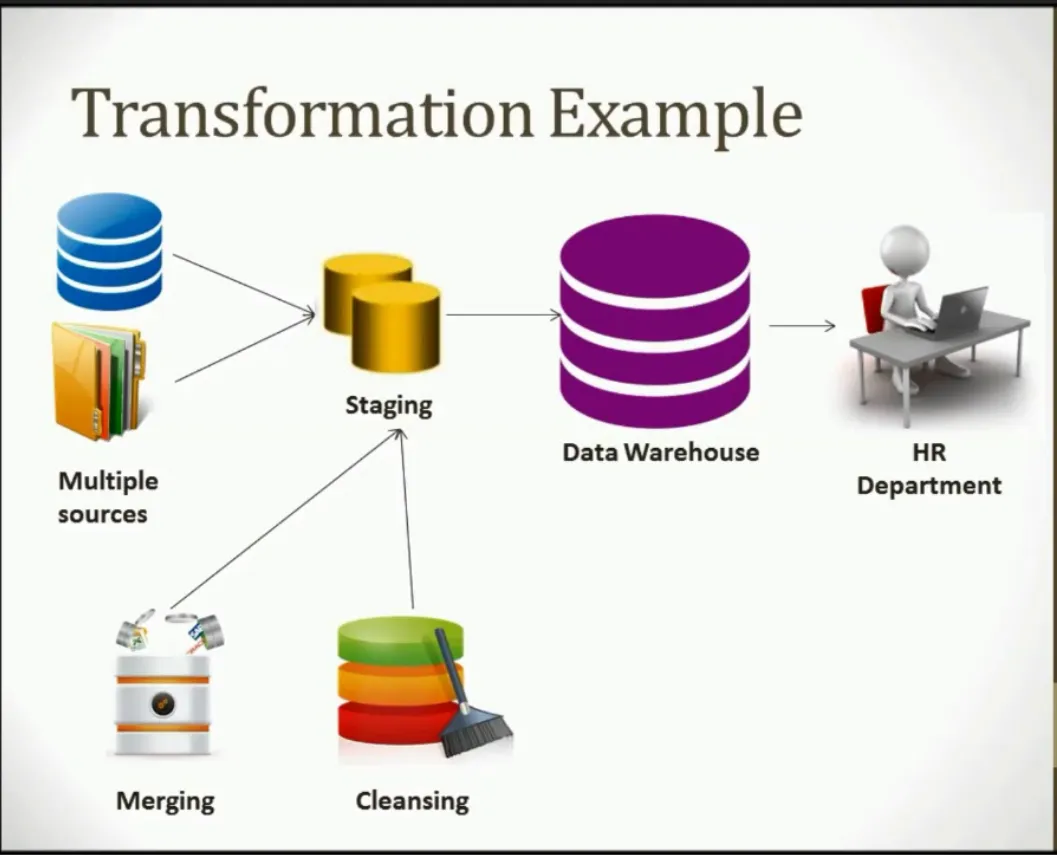

理解ETL(提取、转换、加载)流程和工具。

- 理解 ETL 过程和工具在数据工程中是基础性的,它涉及到从各种来源提取数据,将其转换成可用格式,并将其加载到目标数据库或数据仓库中,以确保数据的质量、一致性和用于分析和报告的可访问性。—— (2–3 周)

- 精通从各种来源(数据库、API、文件)摄取数据。

- 数据工程技术依赖于从各种来源(如数据库、API和文件)获取和处理数据的专业知识,以收集和集中数据进行分析,确保全面的数据覆盖和可访问性,。 — (1至2周).

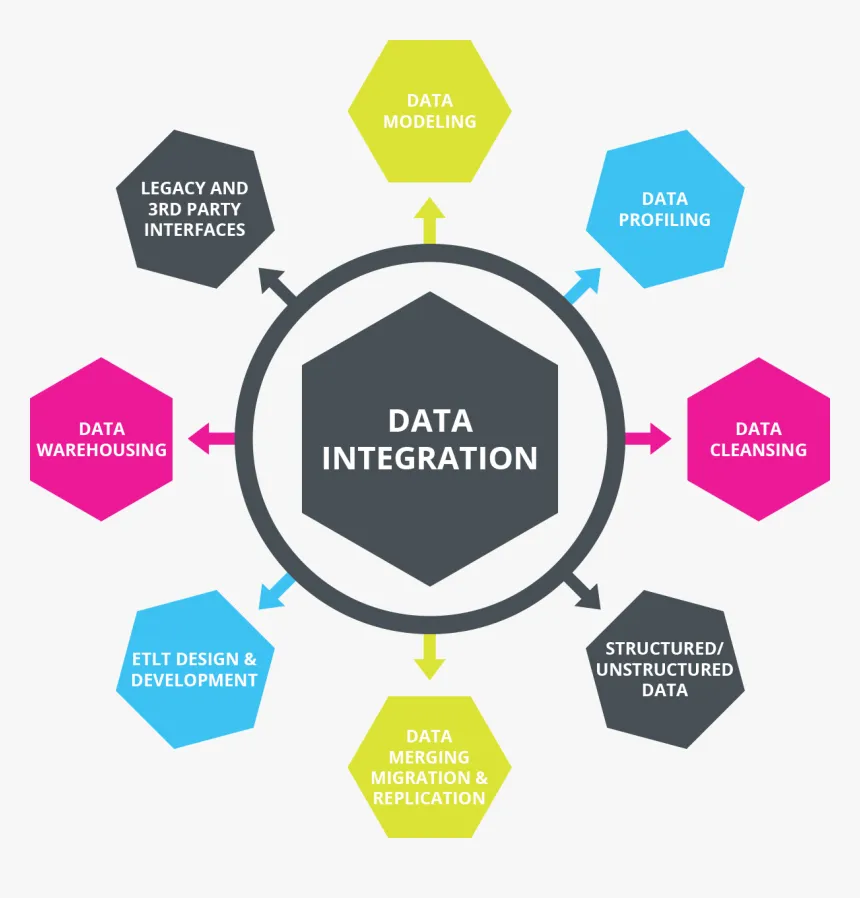

- 了解数据集成模式和其最佳实践。

- 理解数据集成模式和最佳实践对于数据工程至关重要,这有助于协调不同数据源之间的关系,促进数据在系统间的流动和互操作性,从而获得准确的洞察并支持决策。 — (2–3周。)

- 了解和研究数据集成和同步的工具。

- 探索数据集成和同步工具的过程使数据工程师具备自动化数据工作流程、跨平台同步数据、保持数据一致性和完整性的能力,从而增强数据工程管道的效率和可靠性。— (2至4周)

掌握使用SQL、Python或专用工具(如Apache Beam)进行数据转换的技术的使用。

- 精通使用SQL、Python或Apache Beam等工具进行数据转换技术,对于数据工程至关重要,以便在分析过程中操纵和重塑数据,确保数据集之间的兼容性和一致性。 — (2–4周).

理解数据预处理、规范化和增强的过程。

- 理解数据清洗、规范化和数据增强过程在数据工程中至关重要,有助于提高数据的质量、完整性和可用性,为分析和决策提供信心和准确的数据支持。— (1至2周)

- 学习了解数据管道编排和调度安排。

- 了解数据管道编排和调度使数据工程师能够自动化并管理复杂的数据处理流程,确保数据处理和交付的及时性和可靠性。 — (1至2周)

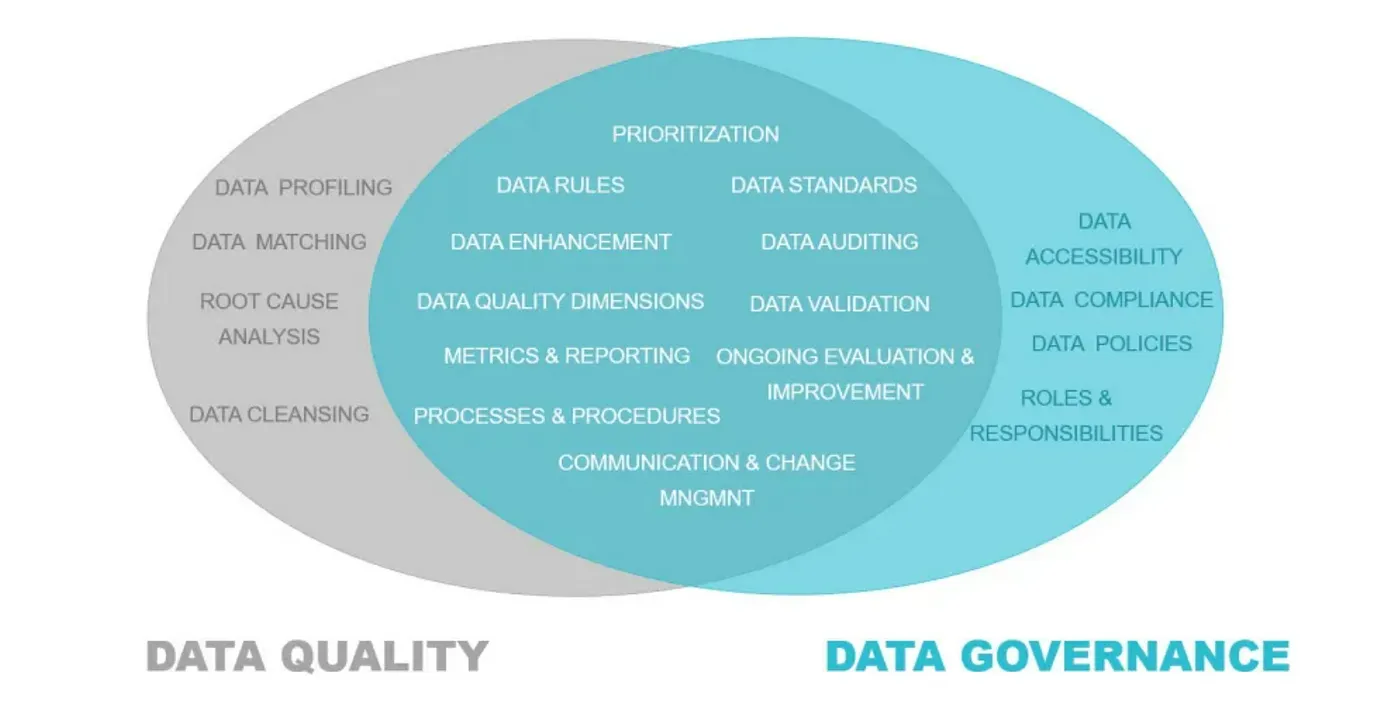

理解数据质量指标以及监测技术。

- 理解数据质量度量和监控技术在数据工程中至关重要,以评估和维护数据的准确性、完整性和一致性,确保在决策制定中获得可靠和可信的见解。 — (1–2 周).

- 学习数据治理原则和框架。

- 学习数据治理原则和框架体系对于数据工程至关重要,以建立政策、流程和控制措施,有效管理和利用数据资产,促进合规性、安全性和问责制贯穿整个数据生命周期。 — (1—2周)。

执行数据质量核查和验证过程。

- 实施数据质量检查和验证流程使数据工程师能够自动化检测并解决数据异常和不一致问题,确保分析和报告的高质量数据来源输入,并增强基于数据的洞察的整体可靠性和准确性。 —(3–4周)

- 熟练掌握主要的云端平台(AWS、Azure、GCP)。

- 熟练掌握像AWS、Azure和GCP这样的云平台在数据工程中是必不可少的,这可以利用可扩展的基础设施和相关服务,实现大规模数据集存储、处理和分析的成本效益。 — (3至4周)

- 了解有关基于云的数据存储和处理服务的知识。

- 学习有关基于云的数据存储和处理服务的知识使数据工程师掌握利用可扩展存储解决方案和分布式处理框架的知识和工具,从而促进高效的数据管理和分析工作流程。 —(2-3周)。

- 理解云安全防护和合规需求。

- 理解云安全和合规要求在数据工程中至关重要,以实施强大的安全措施,确保数据的保密性、完整性和可用性,同时遵守监管标准并遵循行业最佳实践。 — — (4–5周)

探索分布式存储(例如,Hadoop的HDFS、Amazon S3)。

- 探索如Hadoop HDFS和Amazon S3这样的分布式存储系统在数据工程中存储和管理大量数据至关重要,确保其容错性和可扩展性。——(1–2周).

- 精通分布式计算框架(如 Apache Spark,Apache Flink)。

- 掌握分布式计算平台(如 Apache Spark 和 Apache Flink)的技能和知识,使数据工程师能够并行处理和分析大规模数据集的能力,利用分布式计算资源高效处理和分析数据。 — (约 4 至 5 周)

- 理解容器化和编排技术(例如 Docker,Kubernetes)。

- 理解容器化和编排技术,如 Docker 和 Kubernetes,是至关重要的,在数据工程中对于打包和部署数据驱动的应用程序和工作流以实现跨不同计算环境的一致性部署,尤其是在,这有助于提高可扩展性、可移植性和资源利用率。—(3-4周)

探索数据可视化工具和技术(例如,Tableau、Power BI。)

- 探索数据可视化工具,如 Tableau 和 Power BI,是数据工程中的关键步骤,这些工具可以将复杂的数据集转化为有洞察力的视觉表示,从而促进基于数据的决策制定和信息交流。—(1 至 2 周).

- 学习仪表板设计以及如何用数据讲述故事

- 学习用数据讲故事和仪表板设计使数据工程师能够创建既引人注目又富含信息的仪表板,有效地向利益相关方和决策者传达关键洞察和趋势。 — (1–2周)

- 精通交互式可视化和报告的创建。

- 掌握创建交互式可视化和报告的技能,使数据工程师能够开发动态且用户友好的数据产品,增强不同受众对数据驱动洞察的理解和参与度。—— (2至3周)

探索高级主题,例如实时数据分析、数据湖和图数据库。

- 探索高级主题,如实时分析、数据湖和图数据库,在数据工程中的重要性在于解决复杂的数据处理难题和从各种数据源中挖掘新的见解。(2–4 周)。改为中文全角的破折号“——”,最终翻译为:探索高级主题,如实时分析、数据湖和图数据库,在数据工程中的重要性在于解决复杂的数据处理难题和从各种数据源中挖掘新的见解。(2–4 周)。

- 跟紧该领域的新兴技术及发展趋势。

- 关注领域内的新兴技术和趋势,,确保数据工程师能够利用最新的工具和方法来创新和优化数据工程流程,推动持续改进,并在快速变化的环境中保持领先。 — (3至5周).

- 在实际的数据工程项目中工作,从而应用你的技能。

- 在真实的数据工程项目上工作,使从业者能够应用他们的技能于实践中,获得数据处理、整合和分析方面的实践经验,并提升能力并积累经验,从而在行业背景下进一步发展。 — (5至6周).

与同行合作参与开源项目,或参加黑客松活动。

- 与同行在开源项目上合作或参加黑客松能够促进数据工程师之间交流想法和解决复杂问题的能力,并为开发创新的数据工程解决方案做出贡献的协作性环境。

寻求实习和工作机会,以在数据工程领域中获得实践经验。

- 寻找实习或工作机会为有志从事数据工程的人提供了在实际环境中获得实践经验,使他们能够应用理论知识,提升专业技能,并获得关于数据工程师角色和职责的宝贵见解。

如上所述,整个旅程将被分解为易于消化的短小内容。请跟随我,及时了解系列更新。我们将踏上这段旅程。祝您学习愉快!!!

-

Fluss 写入数据湖实战12-23

-

揭秘 Fluss:下一代流存储,带你走在实时分析的前沿(一)12-22

-

DevOps与平台工程的区别和联系12-20

-

从信息孤岛到数字孪生:一本面向企业的数字化转型实用指南12-20

-

手把手教你轻松部署网站12-20

-

服务器购买课程:新手入门全攻略12-20

-

动态路由表学习:新手必读指南12-20

-

服务器购买学习:新手指南与实操教程12-20

-

动态路由表教程:新手入门指南12-20

-

服务器购买教程:新手必读指南12-20

-

动态路由表实战入门教程12-20

-

服务器购买实战:新手必读指南12-20

-

新手指南:轻松掌握服务器部署12-20

-

内网穿透入门指南:轻松实现远程访问12-20

-

网站部署入门教程12-20