人工智能学习

如何为您的用例选择合适的LLM模型

本文主要是介绍如何为您的用例选择合适的LLM模型,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

当你开始任何客户项目时,最常被问到的问题之一是:“我应该使用哪个模型?”这个问题并没有一个简单的答案;这是一个过程。在这篇博客中,我们将解释这个过程,这样下次客户问你这个问题时,你可以把这份文档分享给他们。 😁

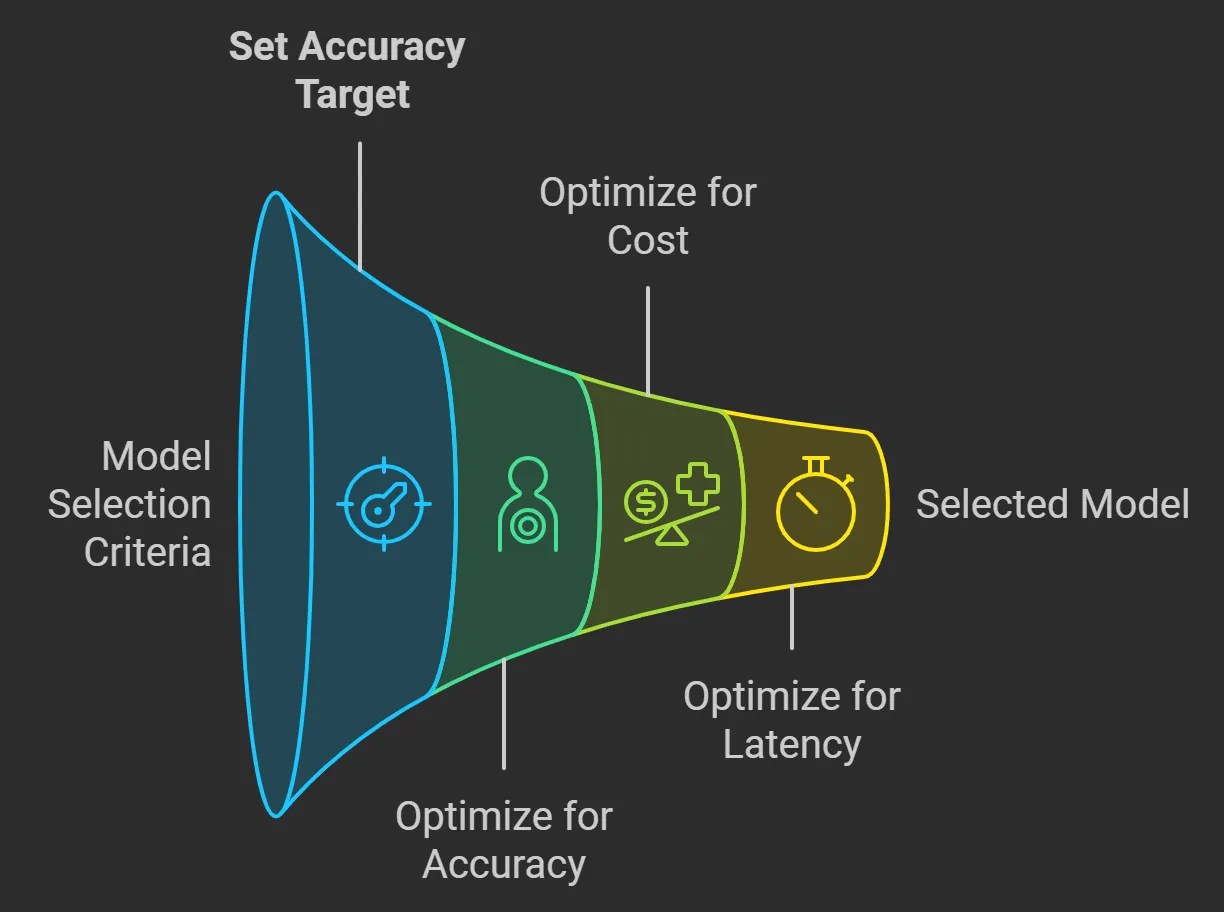

选择合适的模型,无论是 GPT4 Turbo、Gemini Pro、Gemini Flash GPT-4o 还是较小的选择如 GPT-4o-mini,都需要在准确性、延迟和成本之间进行平衡。

模型选择的原则很简单:

- 首先优化准确率:在达到准确率目标之前,优先优化准确率。

- 其次优化成本和延迟:然后力求在成本最低、延迟最小的模型上保持准确率。

掌握大语言模型

你正在准备Gen AI的面试吗?请查看我们的LLM面试准备课程。

- 100+ 个涵盖 14 个类别的问题及真实的 案例研究

- 每个类别精心挑选的 100+ 项评估

- 基于 FAANG 和 Fortune 500 公司的 真实世界面试问题,经过深入研究

- 侧重于 视觉学习

- 完成证书

50% 折扣码 — LLM50

课程链接:

-

设定明确的准确率目标 : 定义对你用例来说“足够好”的准确率。例如:90%的客户服务中心电话在第一次互动中正确分类。

-

开发评估数据集 : 创建一个数据集来衡量模型的性能。例如:收集100个互动示例,包括用户请求、模型分类、正确分类和准确率。

-

使用最强大的模型 : 从最强大的模型开始,以实现你的准确率目标。记录响应以供将来使用。

-

优化准确率 : 使用检索增强生成,然后进行微调以保持一致性和行为。

- 收集未来使用的数据 : 收集提示和完成对的配对,用于评估、少量样本学习或微调。这种做法被称为提示烘焙,有助于生成高质量的示例供将来使用。

掌握大语言模型

成本和延迟被视为次要因素,因为如果模型无法达到你的准确率目标,那么这些因素就无关紧要了。然而,一旦你有了一个适用于你的用例的模型,你可以采取两种方法之一:

- 与较小的模型进行零样本或少样本对比:将模型替换为较小、更便宜的模型,并测试其是否在较低的成本和延迟下保持准确性。

- 模型蒸馏:使用在准确性优化过程中收集的数据对较小的模型进行微调。

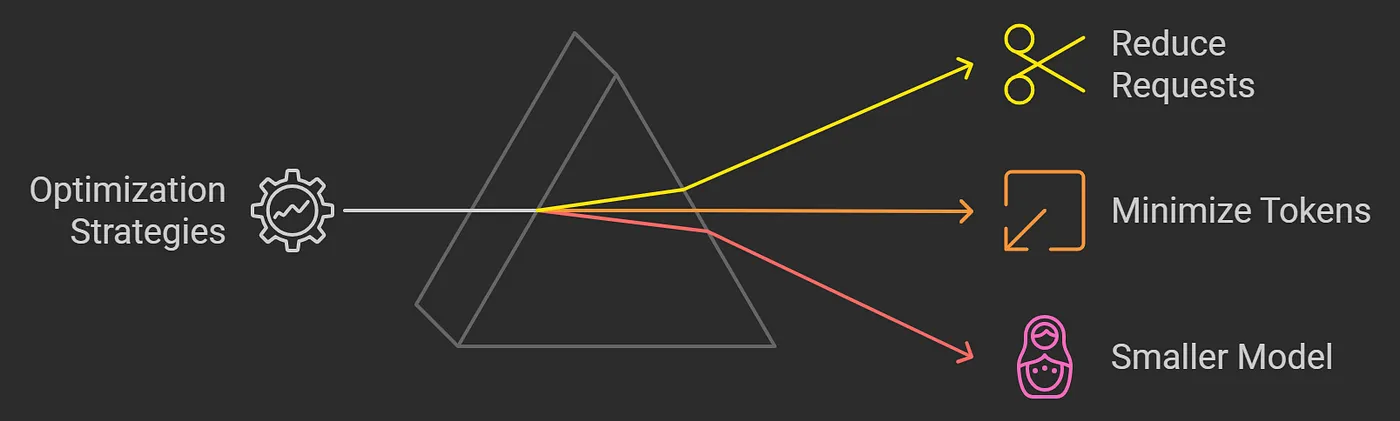

- 成本和延迟通常相互关联;减少令牌和请求通常会导致更快的处理速度。

掌握大语言模型

- 减少请求 : 限制完成任务所需的请求数量。

- 最小化令牌 : 减少输入令牌的数量,并优化模型输出的长度。

- 选择较小的模型 : 使用在降低成本和延迟的同时保持准确性的模型。

掌握大语言模型

为了演示这些原则,他们开发了一个假新闻分类器,目标指标如下:

- 准确性 : 达到90%的正确分类

- 成本 : 每1,000篇文章花费少于5美元

- 延迟 : 每篇文章的处理时间保持在2秒以内

他们进行了三个实验来达到目标:

- 零样本学习:使用基本提示的 GPT-4o 对 1,000 条记录进行了处理,但未达到准确率目标。

- 少量样本学习:包含了 5 个少量样本示例,达到了准确率目标,但因更多的提示令牌超出了成本。

- 微调模型:使用 1,000 个标注示例对 GPT-4o-mini 进行了微调,达到了所有目标,具有相似的延迟和准确率,但成本显著降低。

- 首先优化准确率,然后依次优化成本和延迟。

- 这个过程很重要——你通常不能直接跳到微调阶段,因为你不知道微调是否是你需要的优化工具,或者你没有足够的标注样本。

- 使用一个大的准确模型来达到你的准确率目标,并整理一个良好的训练集——然后使用微调来寻找更小、更高效的模型。

感谢Open AI团队。原始内容。

这篇关于如何为您的用例选择合适的LLM模型的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

您可能喜欢

-

实战:30 行代码做一个网页端的 AI 聊天助手11-20

-

5分钟搞懂大模型的重复惩罚后处理11-18

-

基于Ollama和pgai的个人知识助手项目:用Postgres和向量扩展打造智能数据库11-18

-

我用同一个提示测试了4款AI工具,看看谁设计的界面更棒11-15

-

深度学习面试的时候,如何回答1x1卷积的作用11-15

-

检索增强生成即服务:开发者的得力新帮手11-15

-

技术与传统:人工智能时代的最后一袭纱丽11-15

-

未结构化数据不仅仅是给嵌入用的:利用隐藏结构提升检索性能11-15

-

Emotion项目实战:新手入门教程11-15

-

7 个开源库助你构建增强检索生成(RAG)、代理和 AI 搜索11-15

-

Vertex AI上下文缓存与Gemini模型详解11-15

-

用可视化评估你的检索增强生成系统:RAG系统的评估与分析11-15

-

强化学习:教智能代理操作发电厂的方法11-15

-

质量工程师眼中的检索增强生成(RAG)解析11-15

-

让我们聊一聊算法和社会媒体那些事儿11-15

栏目导航