人工智能学习

人工智能法系列:上市后监控系统

声明:我真的很不喜欢把东西称为速查表。这给人一种感觉,好像任何人都可以使用它们,但实际上通常只有制作它们的人才能真正使用它们。这确实是一份这样的“速查表”。我还是希望它能帮助你更好地理解这些内容。

根据《人工智能法》第3条第25款,‘ 后市场监控系统 ’(PMMS)涉及所有为收集和审查人工智能系统使用经验而进行的活动,以识别并采取必要的即时纠正或预防措施。(因为没有什么比在使用过程中即时修正人工智能的失误更能体现进步了。)

此外,第72条要求该系统应与其性质和风险相适应。它规定了要积极和系统地收集、记录和分析与系统性能相关的数据。(翻译:这可不是GDPR的规定,要像松鼠为冬天储备坚果一样收集数据(除非是个人数据,那样可能就不要这么做了)。)

最后,PMM系统必须遵循一个PMM计划,该计划将在大约1.5年后由委员会提供更详细的说明。由于在科技界这基本上相当于一个永恒的时间,我决定推测一下PMM对于AI系统可能是什么样子。我喜欢将这个方案视为一种有根据的猜测,这可能特别适用于那些已经拥有PMM系统的提供商。他们现在只需要添加特定于AI系统的组件。简单易行,对吧?所以让我们直接进入正题。

Amritha R Warrier & AI4Media / Better Images of AI / 无法生成错误 / CC-BY 4.0

目标和目的第155条将PMMS(后市监控系统)视为AI行业的安全网,旨在让提供商能够在运行中修复其系统——这基本上要求提供24/7的服务支持。该系统对于“自适应”的AI尤为重要,这类AI在部署过程中会持续学习(是的,即使那些非自适应的系统也被视为AI法案下的AI系统)。当这些AI系统开始以意想不到的方式演变时,拥有一个强大的监控系统对于在风险升级之前发现风险至关重要。

但这还不仅如此。PMMS(上市后监控系统)还充当AI风险调查员,负责识别并及时报告任何严重事件或新风险。因此,如果你的AI系统导致死亡或严重健康损害,破坏关键基础设施,侵犯基本权利,或损坏财产或环境,你需要通知相关当局以及AI供应链中下游的所有相关方(进口商、分销商、部署者)。根据第20条,提供者在对其AI系统的合规性有任何疑问时,也必须采取行动,包括将其从市场中撤回。我们也不能忘记,PMMS不仅仅是监控和记录这些风险,它还在于明确责任并建立清晰的流程,以将这些风险告知所有需要知道的人。

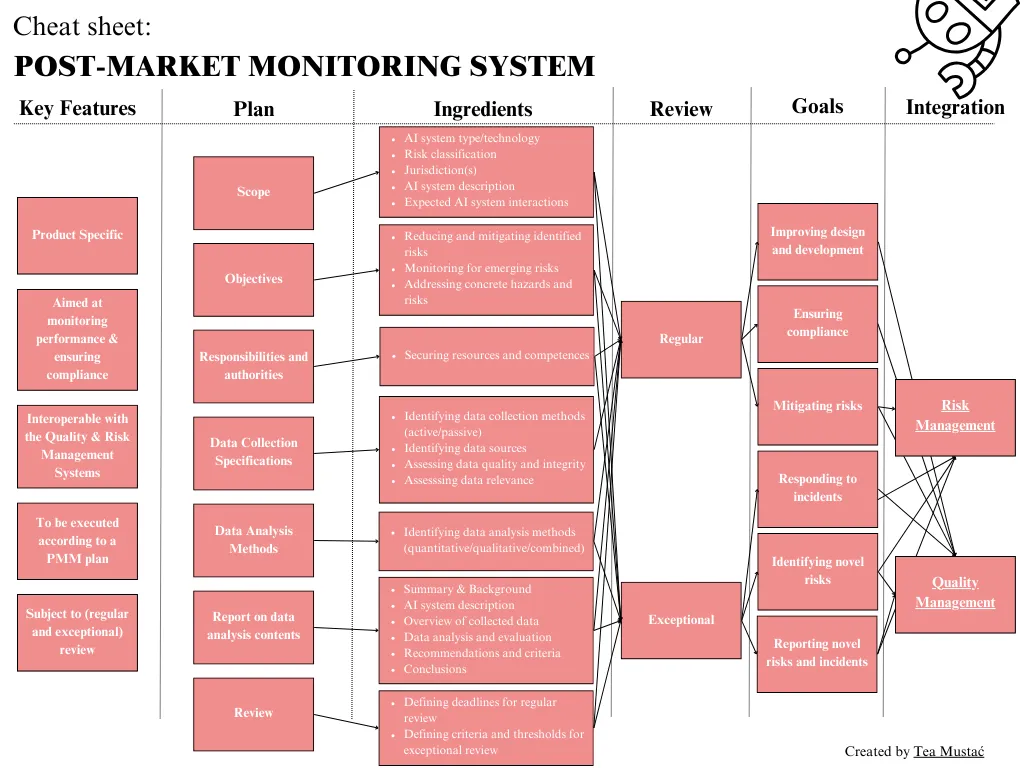

关键特性简而言之,合规且高效的上市后监测系统的关键特征包括:

- .产品特定: 针对每个AI系统。

- .实现持续性能监控: 就像有一个永远不会离开你的私人教练。

- .处理角色和职责: 这样在事情出错时你才知道该找谁负责。

- .建立程序并促进沟通: 遵守报告义务的关键。

- .包括定期和特殊审查: 保持系统更新和有效。

- .涉及(相当多的)文档: 在PMMS计划和退出报告中记录详细信息。 文书工作是任何伟大系统的基础。

- .允许集成: 补充其他系统(风险管理/质量管理系统)。

《AI法案》下的市场后监管系统速查表(作者撰写)

市场后监测计划虽然我们正在热切期待委员会发布的关于《人工智能法》中后市场监控(PMM)的模板,但我们可以通过观察医疗和制药行业获得一些启示。多年来,这些行业一直要求制造商达到高标准,而ISO 20416——一个针对医疗器械的后市场监控标准——或许可以让我们一窥委员会对AI系统提供商的期望。

ISO 20416 描述了PMM计划作为一种全面策略,用于在整个产品生命周期中收集和分析数据。这远远超出了AI法案中对PMM计划的定义,后者将其简化为一种用于检测和响应事件的机制——如果你问我,这确实是一个相当狭窄的焦点。不过,我们现在暂且不考虑这一点,而是专注于后市场监控计划及其最有可能包含的要素。同时,我们还要牢记AI法案中以事件驱动的方法。

为了设计您的PMM计划,您应该考虑并记录以下几点:

1. 范围:首先,定义AI系统,包括其类型、底层技术、风险类别以及部署位置。然后评估系统的成熟度和当前技术水平。最后,详细说明其预期用途和目的。

2. 目标:概述你的总体目标,例如通过收集和分析新的相关信息来减少已识别的不确定性,并监控新出现的风险和事件。同时,还包括基于提供商现有期望和风险评估以及收集的数据来解决具体问题/风险/关注点的特定目标。

3. 职责与权限:分配各种任务(包括任务描述)的责任和权限,这些任务将在AI系统的整个生命周期中执行。此外,确保拥有适当技能、资源和权限的合适人员负责这些任务。

PS 此处ISO 20416标准可以提供很多帮助,其中包含了角色及其胜任力的例子。这些可以包括:

- 药后市场监控计划的制定和执行,由组织管理层负责,并总体负责组织的药后市场监控流程。

- 生产后事件处理,由投诉处理部门负责,并负责处理投诉以及报告不良事件。

- 持续数据收集,由信息事务部门负责,并基于已知和最新的评估方法,以及具体情况进行数据收集。

这些会根据具体的AI系统、组织资源甚至组织内现有角色及其能力而有很大差异。

4. 数据收集: 首先,确定您的数据来源,包括用户反馈、日志文件、科学出版物和社会媒体等。定义来自特定来源的数据的可信度和重要性。明确从这些来源收集的数据的属性,以及它们的预期用途和价值。

选择合适的数据收集方法,无论是主动的方式,如调查,还是被动的方式,如审查投诉。选择方法取决于你要分析的内容和目的。例如,你是在分析数据以确定原因并报告事件,还是识别潜在的新风险并探索想法,这一点并不无关紧要。同样,你是在分析全球、区域还是国家范围内的部署数据,这一点也不无关紧要。

最后,建立数据收集协议,确保每一步都得到记录、监控和质量检查。可以将这视为您的PMMS的日志簿,记录在后市场旅程中的每一个曲折和变化。

5. 数据分析:根据你的数据,你可能会选择像计算平均值和百分比这样的定量方法,以了解整体表现。如果你处理的是更复杂的关系,你可能会使用相关性或回归分析来观察不同因素之间的相互作用。对于定性数据,内容分析或话语分析等技术可以帮助你理解信息,识别反复出现的主题或潜在问题。有时,结合这两种方法是必要的,以获得全面的视角。关键是要将你的分析方法与PMM计划的目标对齐——无论是识别事件的根本原因、标记新风险,还是探索提高系统性能的方法——以及可用的数据。

退出报告到了最后,你制定的上市后监测计划中所列出的所有问题和目标都需要在进行的数据分析的退出报告中完整地总结。再次按照ISO 20416标准,该报告可以包括:

- 摘要: 快速概览 — 涉及的人员、报告内容以及查找要点的位置。

- 关于AI系统的背景: 详细说明系统的版本,是否仅是软件或包含物理组件,以及其他相关背景信息。

- 系统描述: 清晰说明AI系统的预期用途和排除用途。

- 数据概览: 提供在上市后监督期间收集的数据概览。

- 数据分析: 深入分析,解释数据传达的信息及其原因。

- 建议: 根据您的发现提出需要采取的任何行动。

- 结论: 权衡风险和收益,并列出用于决策的标准。

- 审查时间表: 根据系统的风险和发现情况设定下一次审查的时间表。

一旦您的上市后监控系统开始运行,仅仅让它自动运行是不够的。您必须密切关注它是否真正达到了目标。这意味着要定期安排审查——在更新、新版本或每年进行一次。此外,如果事件开始增多,或者您从监管机构收到了报告或警告,也需要进行例外审查。

为了确定何时需要这些_特殊_审查,建立触发更仔细审查的阈值。如果你达到了其中一个阈值,或者某些风险无法降低到可接受的水平,你可能需要进行更多的工作——比如修订PMMS、采取纠正措施或向有关部门报告。确保在这些审查过程中记录所做的任何更改,包括更改的原因,以便最终报告能够全面反映情况。

与其他系统和流程的交互最后,请记住,你的上市后监测数据不是孤立存在的。它不仅是《AI法案》第72条下的独立义务,还作为质量管理系统(QMS)的一部分,如第17条所述,以及风险管理系统的组成部分,如第9条所述。因此,利用这些数据来优化你的流程,指导AI系统的开发,并推动改进。

此外,它还可以作为您遵守所有监管要求的通行证,包括首先维护一个PMMS系统,发起纠正措施,并根据第20条和第26条的要求,及时向所有人通报新的风险或事件。当监管机构正式要求时,您将拥有所有相关信息,随时可以展示您已经将一切都掌控在手中。这听起来确实是个好主意。

-

实战:30 行代码做一个网页端的 AI 聊天助手11-20

-

5分钟搞懂大模型的重复惩罚后处理11-18

-

基于Ollama和pgai的个人知识助手项目:用Postgres和向量扩展打造智能数据库11-18

-

我用同一个提示测试了4款AI工具,看看谁设计的界面更棒11-15

-

深度学习面试的时候,如何回答1x1卷积的作用11-15

-

检索增强生成即服务:开发者的得力新帮手11-15

-

技术与传统:人工智能时代的最后一袭纱丽11-15

-

未结构化数据不仅仅是给嵌入用的:利用隐藏结构提升检索性能11-15

-

Emotion项目实战:新手入门教程11-15

-

7 个开源库助你构建增强检索生成(RAG)、代理和 AI 搜索11-15

-

Vertex AI上下文缓存与Gemini模型详解11-15

-

用可视化评估你的检索增强生成系统:RAG系统的评估与分析11-15

-

强化学习:教智能代理操作发电厂的方法11-15

-

质量工程师眼中的检索增强生成(RAG)解析11-15

-

让我们聊一聊算法和社会媒体那些事儿11-15