人工智能学习

扩散模型真的在图像超分辨率上优于GANs吗?

照片由 Kasia Derenda 在 Unsplash 提供

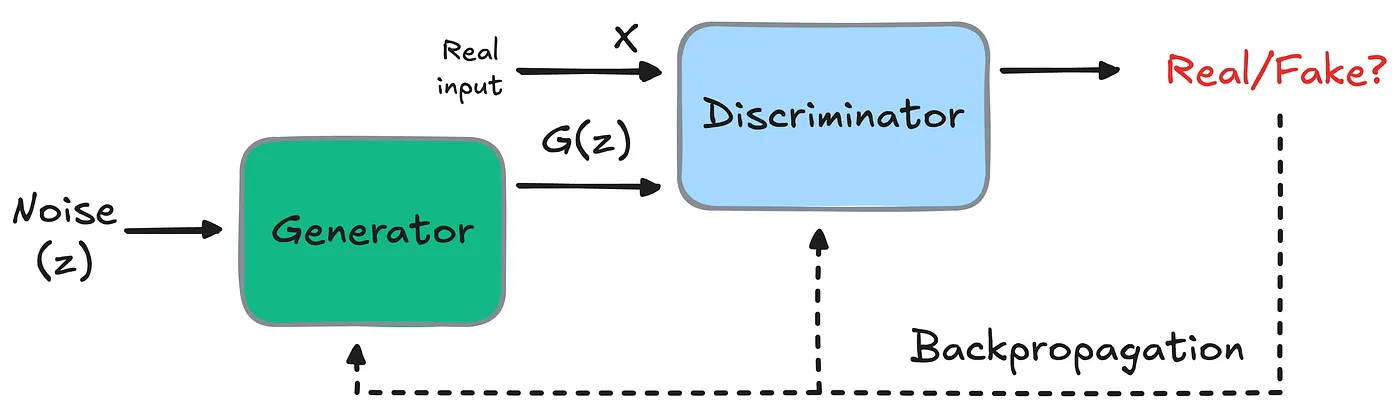

介绍在过去半个多世纪(2014–2020),生成对抗网络(GANs)在生成模型领域占据主导地位,包括图像超分辨率(ISR)。

引入的对抗训练框架(涉及竞争的生成器和判别器网络)在从低分辨率图像生成高分辨率图像时,通过优化感知质量表现出色。

一个简单的GAN架构(Valerii Startsev 图片)

然而,他们的主导地位开始在2020年中期逐渐减弱,当时去噪扩散模型(DDMs)开始受到关注,因为它们能够提供一个稳健的图像生成框架,同时还能处理多模态数据分布——这是GANs所难以应对的。

此外,到2021年初,扩散模型已经成为生成建模领域中最新方法的主要来源,包括图像超分辨率(ISR)([a] [b] [c])。

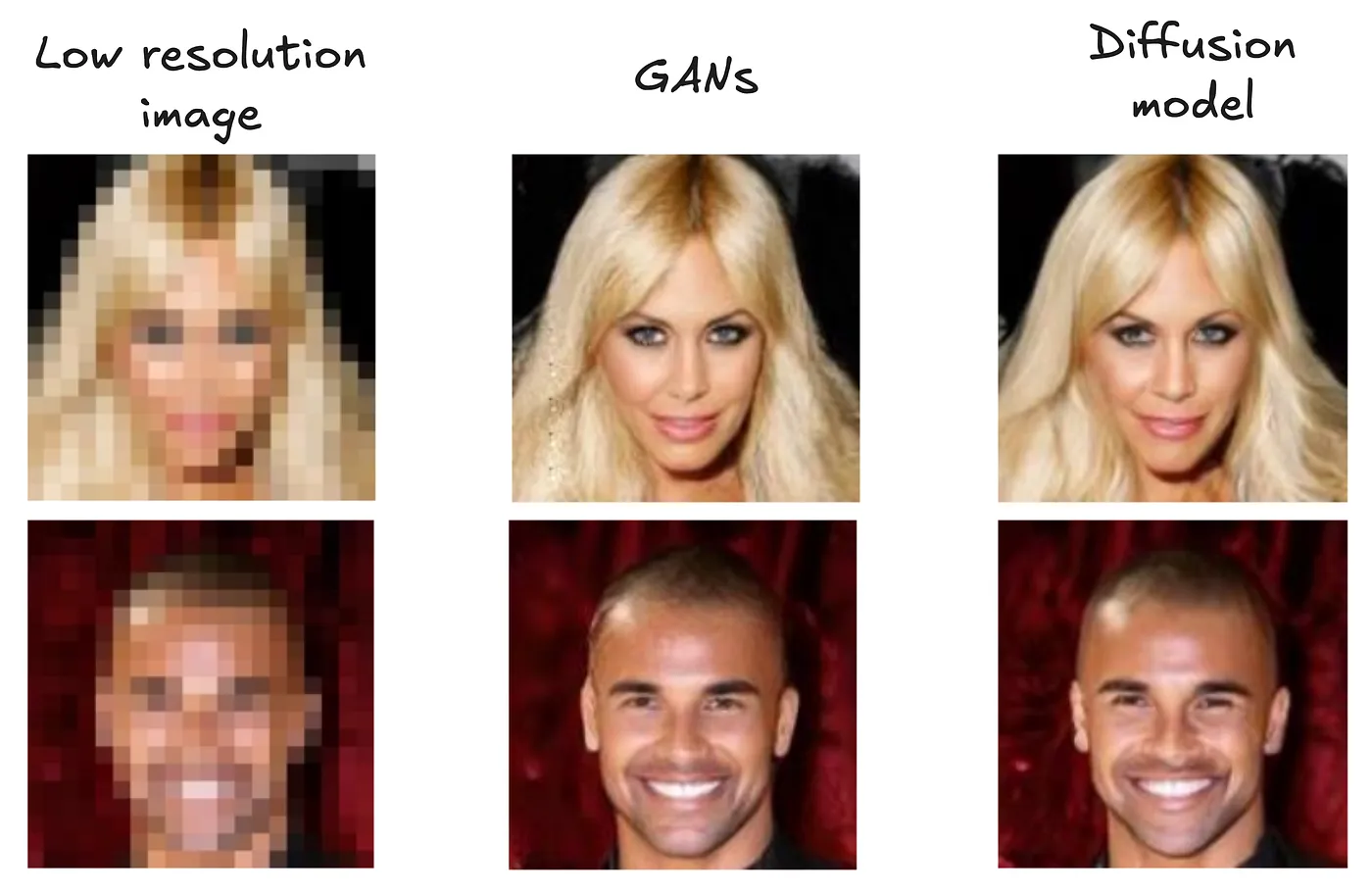

例如,下图展示了 GANs 和扩散模型在两张低分辨率图像上的比较,更多此类结果可以在文献中找到。

GANs 和扩散模型在两张低分辨率图像上的比较(来源:SRDiff论文)

虽然大多数研究确实将扩散模型视为生成模型中的新黄金标准(特别是对于图像超分辨率),但我们必须仔细审视这些说法。

扩散模型在超越GANs方面的明显成功可能不仅仅是因为它们本身的优势。

相反,这可能是由于最近研究中模型架构的扩大规模、延长的训练时长和更大的数据集所导致的。

这提出了一个关键问题:

扩散模型是否真的更适合图像超分辨率(ISR),还是它们只是得益于更丰富的资源?

这正是Yandex研究团队在最近的一篇论文中探讨的内容,我想在这篇博客中分享我们的研究发现。

本文的结构如下:

- 首先,我们将介绍ISR以及我们想要回答的问题。

- 接下来,我们将深入探讨我们在论文中使用的实验设置和训练方法。

- 最后,我们将查看结果,并分享我们从每组结果中得到的收获。

要点:我们展示了扩散模型流行的说法是由一些研究形成的,在这些研究中,基于扩散的ISR模型比其基于GAN的模型接受了更广泛的训练和更大的网络架构([a] [b] [c]),这引发了对其所认为的优越性的来源的疑问。我们证明,在架构、模型和数据集大小以及计算预算都相匹配的控制条件下,基于GAN的模型可以达到与基于扩散的模型相当的结果。

让我们开始吧!

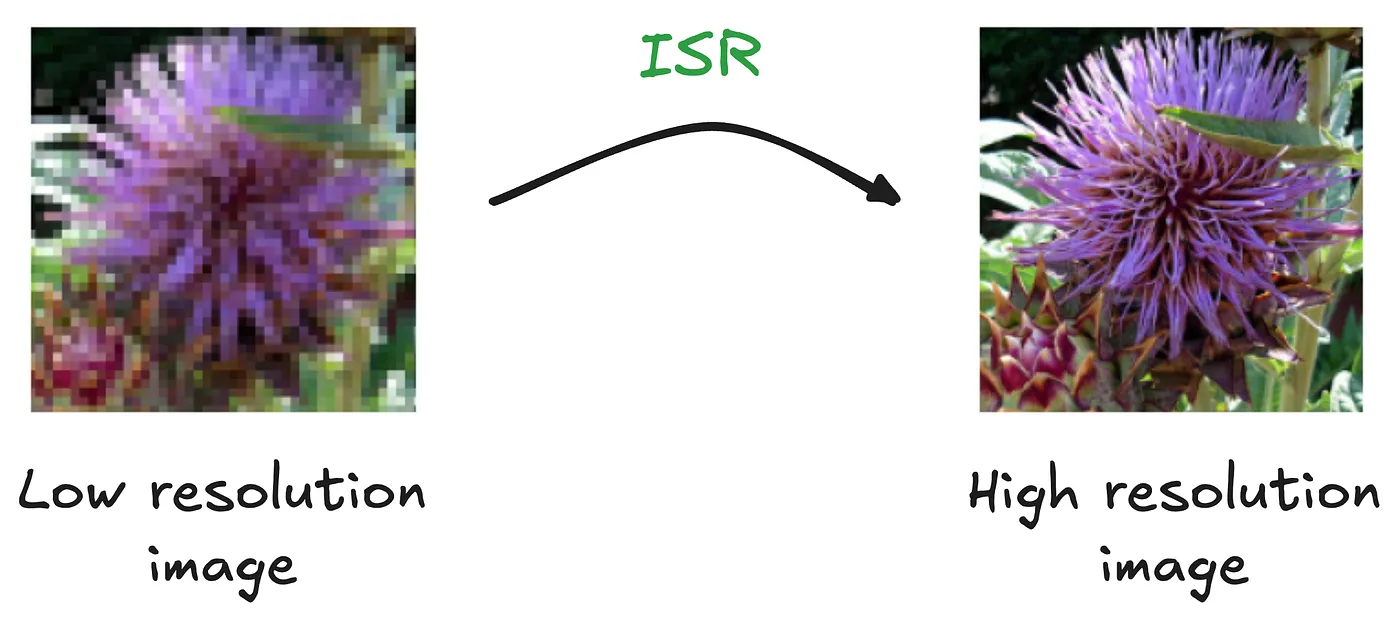

理解ISR正如其名,ISR旨在将低分辨率图像放大到更高分辨率,恢复细微的细节和纹理。

ISR 目标(图像来源)

如前所述,GANs 已经成为这项任务的首选方法近半个世纪了,通过对抗训练生成清晰且视觉效果吸引人的结果。

然而,GANs 在处理复杂的多模态数据时常常遇到困难,并且难以训练。

为了提供更多背景信息,多模态指的是具有多种不同模式或分布类型的数据。在图像生成的背景下,这可能意味着从单个低分辨率输入生成多个但同样合理的图像。

例如,一张模糊的风景低分辨率图像可以被现实地解释为多种情况——不同的季节、一天中的不同时间或天气条件,每一种都代表了不同的模式。

GANs 虽然在生成高质量图像方面表现出色,但常常难以应对这种多模态的特性。

扩散模型特别适合解决图像超分辨率(ISR)中多模态数据带来的挑战。

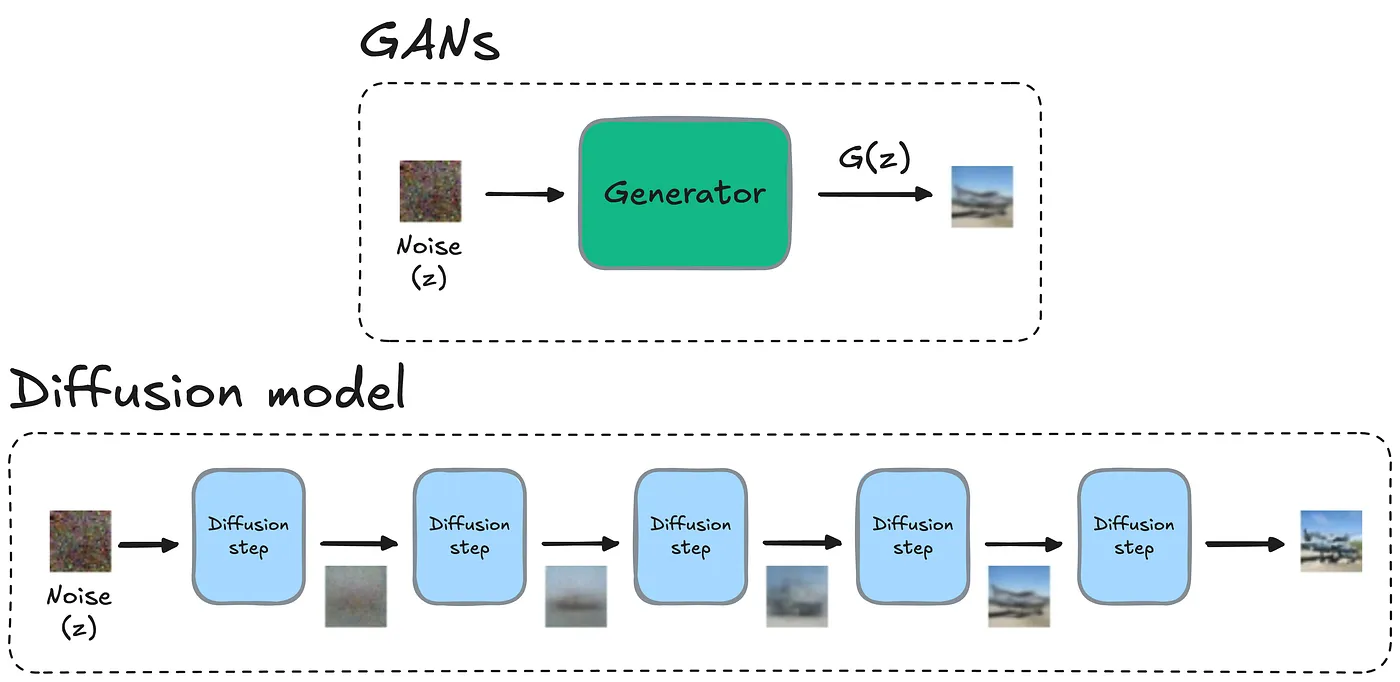

如何做到?与依赖单一生成过程的GANs不同,扩散模型通过一个逐步去噪的过程生成图像,如下所示:

生成过程在GANs和扩散模型中的表现(图形由Valerii Startsev制作;中间图像来自扩散模型论文)

如上所示,在两个模型中,生成过程都从一个随机噪声图像开始。

- GANs 尝试一次性生成图像。

- 然而,扩散模型通过多次迭代逐步改进,直到生成高分辨率图像。每一步通过移除少量噪声逐步提高图像质量,由训练期间学习到的底层数据分布引导。

迭代方法提供了一个稳健的图像生成框架,我们还发现它能够可靠地处理多模态数据分布。此外,其去噪目标导致了稳定的端到端训练过程。

问题虽然使用扩散模型生成图像在计算上更为耗资源,但实验表明,它能产生更多样化和高质量的输出。

GANs 和扩散模型在两张低分辨率图像上的比较(来源:SRDiff论文)

然而,当我们深入研究文献时,我们开始怀疑是否可以根据此得出扩散模型优于GANs的结论是公平的比较。

虽然扩散模型在包括ISR在内的生成模型领域占据领先地位,但在受控条件下,还没有一个全面的研究来比较GAN和扩散模型在ISR方面的表现。

扩散模型的优越性可能源于训练该模型所使用的更大规模和计算资源,与扩散模型中的迭代去噪步骤无关。

实验设置和方法论我们的论文“扩散模型在图像超分辨率中是否优于GAN?”旨在确定扩散模型在ISR中的优越性是否源于其内在的能力,还是仅仅是因为更广泛的训练和更大的模型规模。

为了理解这一点,我们对 GAN 和扩散模型进行了架构大小、数据集大小和计算预算相匹配的受控对比。

架构细节在这项研究中,我们使用了Efficient U-Net架构,该架构最初在Imagen模型中引入,用于GAN和基于扩散的超分辨率(SR)模型。

该架构通过使用相同数量的通道和残差块,在不同分辨率之间保持一致性,如在从256x256到1024x1024的超分辨率任务中所见。

GAN和扩散SR模型之间的主要区别在于时间步嵌入和噪声拼接的使用,这些功能在扩散模型中存在,但在GAN中则不存在(由于扩散模型的设计特性)。

对于涉及文本辅助生成的实验,我们通过文本编码器处理图像的描述。然后,我们将文本信息通过尺度偏移调制和跨注意力机制集成到超分辨率模型中。这一过程使得模型能够生成与提供的文本相符的图像,从而使输出更具上下文相关性。

值得注意的是,无条件文本的GAN模型有6.14亿个可训练参数,而当扩散模型基于UMT5嵌入进行条件设置时,参数数量达到了6.96亿,这表明这两种模型在规模上是相似的。

在预测过程方面:

- 基于GAN的模型直接从低分辨率图像预测出高分辨率图像。

- 扩散模型迭代预测要应用于受损高分辨率图像的噪声,基于相应的低分辨率输入。这意味着从低分辨率图像和形状为高分辨率图像的高斯噪声开始,我们可以迭代生成高分辨率图像。

我们从一个庞大的专有数据集开始,该数据集包含数十亿张图像-文本对,最初是为训练图像-文本模型而收集的。接下来,我们将这个庞大的数据池分多个步骤过滤,以生成适合训练竞争性超分辨率模型的数据集:

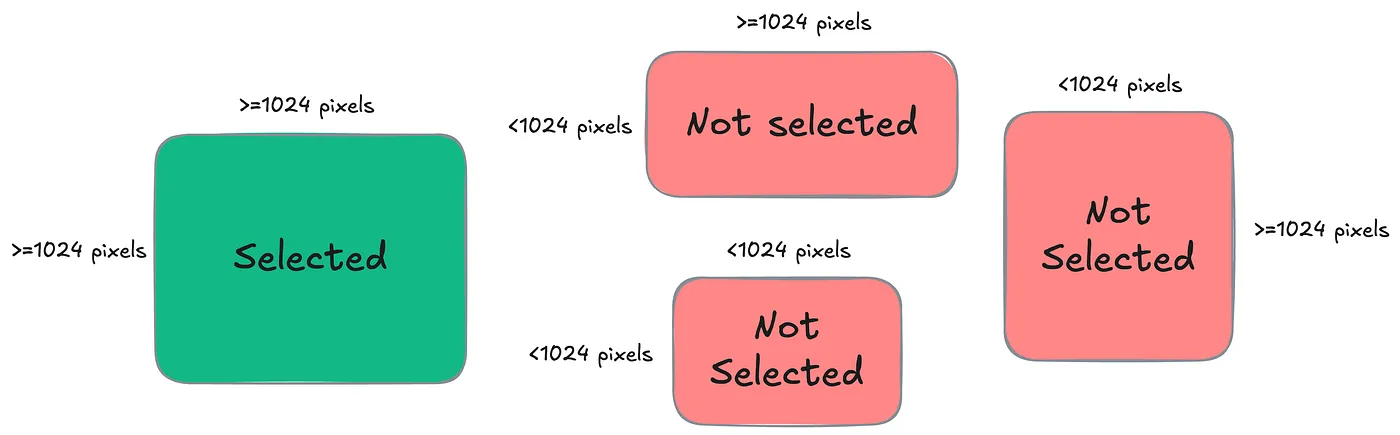

- 首先,仅考虑高度或宽度恰好为1024像素,且另一维度不少于1024像素的图像。

只有高度和宽度都超过1024像素的图片会被选择(图片由Valerii Startsev提供)

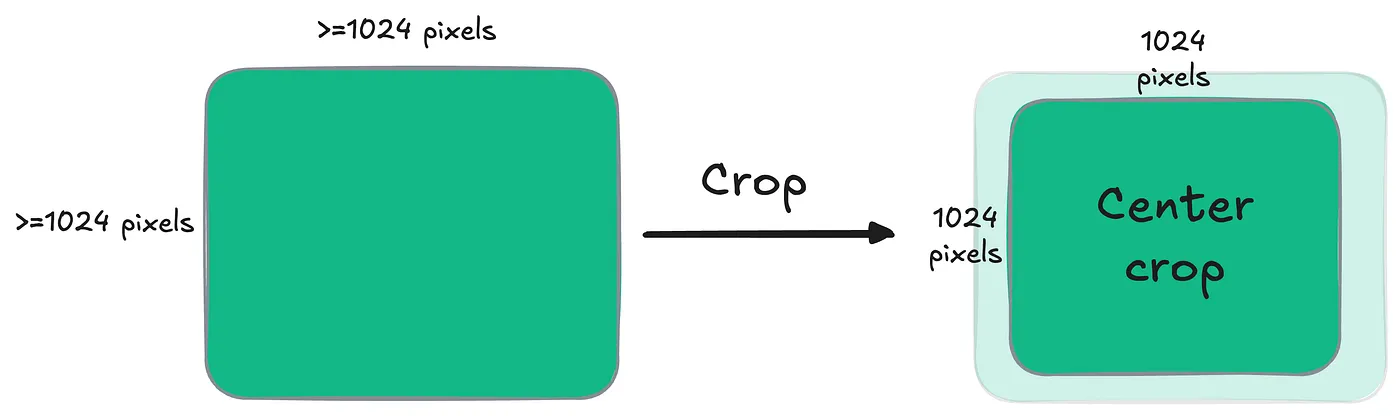

- 对非正方形图像应用了中心裁剪,以实现统一的1024x1024像素分辨率,平衡了数据质量和数量。

对非正方形图像应用中心裁剪(Valerii Startsev 提供的图像)

通过使用一些更严格的基于机器学习的过滤过程,数据集被缩减为一个高质量的子集,包含1700万张图像,每张图像都配有相应的英文说明。

训练详情我想突出我们在实验中使用的训练过程中的几个令人兴奋的细节。

在基于GAN的超分辨率模型中,生成器模型最初仅使用L1损失进行了预训练。我们发现这是必要的,因为在仅使用对抗损失从头开始训练时,通常会产生伪影。

预训练完成后,使用非饱和对抗损失进行了对抗训练,这有助于生成边缘锐利、高频细节丰富的图像。

扩散模型是在 ϵ-预测目标上训练的,时间步长从 [0, 1] 均匀采样。

训练涉及预测添加到高分辨率图像上的噪声,使用低分辨率图像作为条件。

这种方法依赖于一种方差保持的噪声调度,以确保图像的逐步细化。

发现与分析发表在我们的论文中,这些发现揭示了几个重要的见解,挑战了该领域当前的主流叙事。

如前所述,虽然扩散模型在处理复杂多模态数据和生成高质量输出方面表现出色,但本研究中进行的控制实验揭示了在类似条件下进行扩展和训练的GANs的能力的新见解。

正如文章即将揭示的实验结果所示,当适当扩展时,GANs 在各种图像超分辨率(ISR)任务中可以达到与扩散模型相当的结果。

尽管人们认为扩散模型更优越,但在峰值信噪比(PSNR)、结构相似性指数(SSIM)、感知图像补丁相似性(LPIPS)以及最近的无参考CLIP-IQA指标等关键指标上,GANs的表现与其相当。

让我们开始吧!

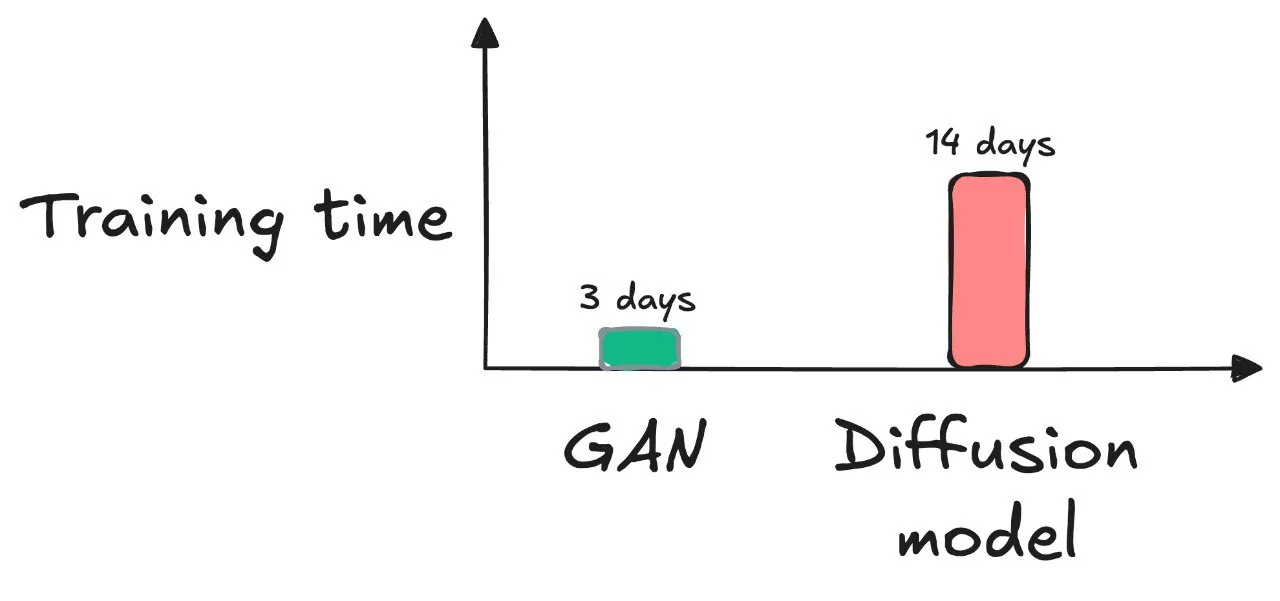

1) 训练时间和收敛性值得注意的是(这也是基于GAN的ISR模型与扩散模型之间的第一个关键区别),使用GAN的预训练和对抗训练大约需要三天完成140,000次迭代,而使用相同资源训练扩散模型则大约需要两周。

训练时间比较(图片由 Valerii Startsev 提供)

当然,我们通过使用诸如全数据并行分片(FSDP)等技术优化了内存消耗,并方便了处理更大的批次大小。

然而,尽管有此优化,我们发现GANs在所有阶段(L1预训练和对抗训练阶段)的收敛速度都比扩散模型快。

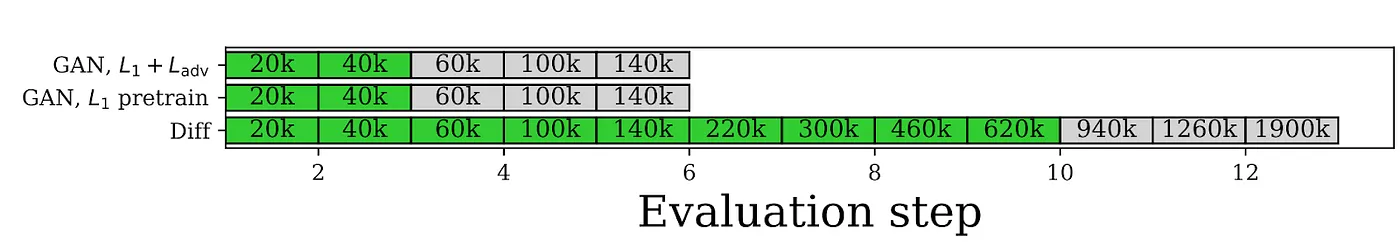

下表展示了这一点:

绿色区域对应于比前一步显著的改进。连续三个没有改进的评估(灰色)表示已经收敛(图片来源:Paper)

- GAN 模型在 40 倍迭代后稳定。

- 为了使模型完全收敛,扩散模型需要在裁剪后的图像上进行大约 620k 次 L2 预训练迭代。

takeaway

这是一个令人瞩目的观察,表明与扩散模型规模相似的生成对抗网络(GANs)训练所需时间更短,收敛速度更快。

虽然这很好,但我们仍然想验证更快的收敛是否能带来类似的表现。

后续部分将讨论此内容。

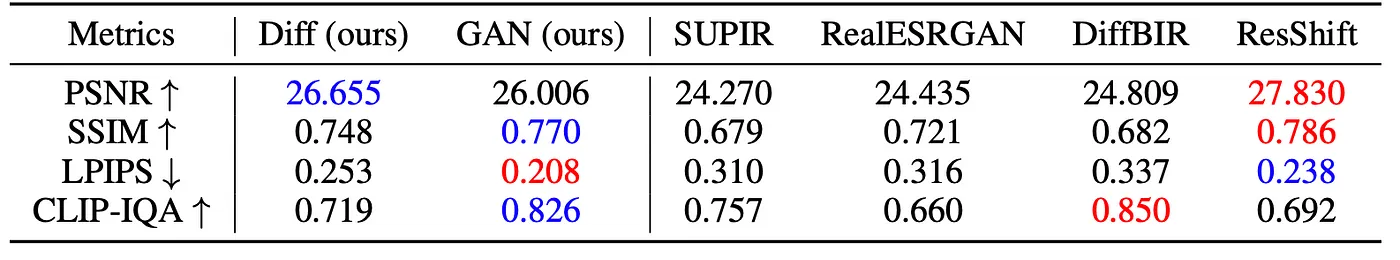

2) 定量比较以下表格来自论文展示了 GAN、Diffusion SR 与当前最佳方法在 4x 图像超分辨率任务上的定量比较:

定量比较 GAN、Diffusion SR 和当前最先进方法(图像来源:Paper)。红色表示最佳结果;蓝色表示第二佳结果。

从上表可以看出,在4个案例中有3个案例中,GANs的表现优于在类似规模和计算预算下训练的扩散模型。

takeaway

再一次,这些见解非常令人震惊。

- GANs 在适当扩展并在与扩散模型相似的条件下训练时,不仅能够与扩散模型匹敌,而且在许多情况下还能在图像超分辨率任务中超越扩散模型的表现。

- 这一发现结合训练时间和收敛性方面的观察表明,GANs 更快的收敛速度并不会以牺牲性能为代价。通常情况下,GANs 会带来与扩散模型相当甚至更好的图像质量。

此外,这些发现挑战了扩散模型在所有生成任务中(在某种程度上)普遍更优的日益增长的看法。

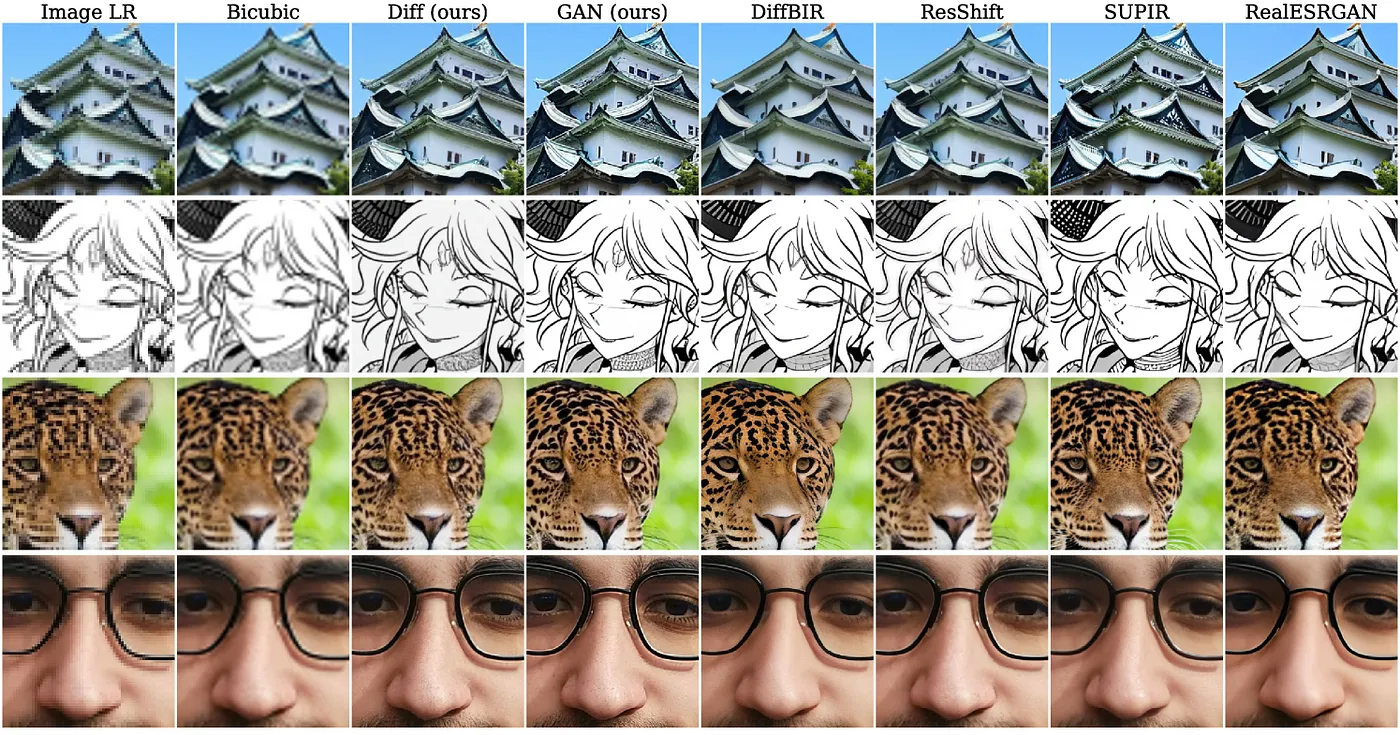

3) 视觉对比下图展示了我们工作中提出的GAN和扩散SR模型与基准模型在超分辨率(SR)上的视觉比较(第三列是扩散模型,第四列是GAN):

来自几个模型的视觉样本(图像来源:论文)

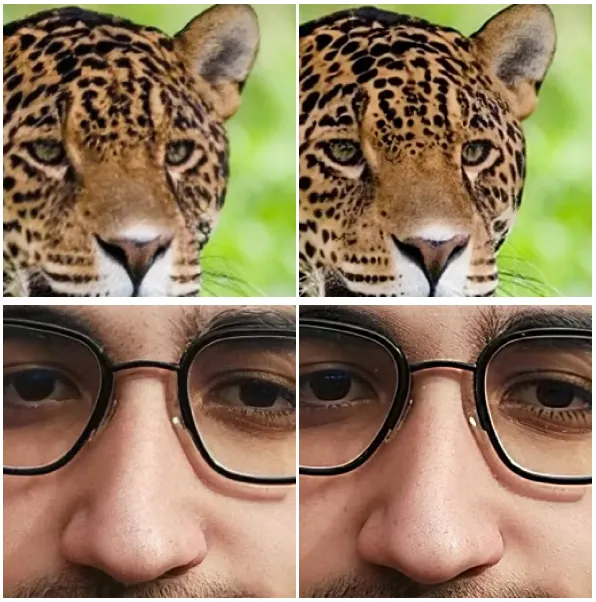

放大来看一些具体的实例,可以注意到GANs(下方第2列)生成的细节(或类似)层次比扩散模型(下方第1列)的超分辨率稍微更精细一些:

视觉样本对比:扩散模型(左列)与GAN(右列)(图片来源:论文)

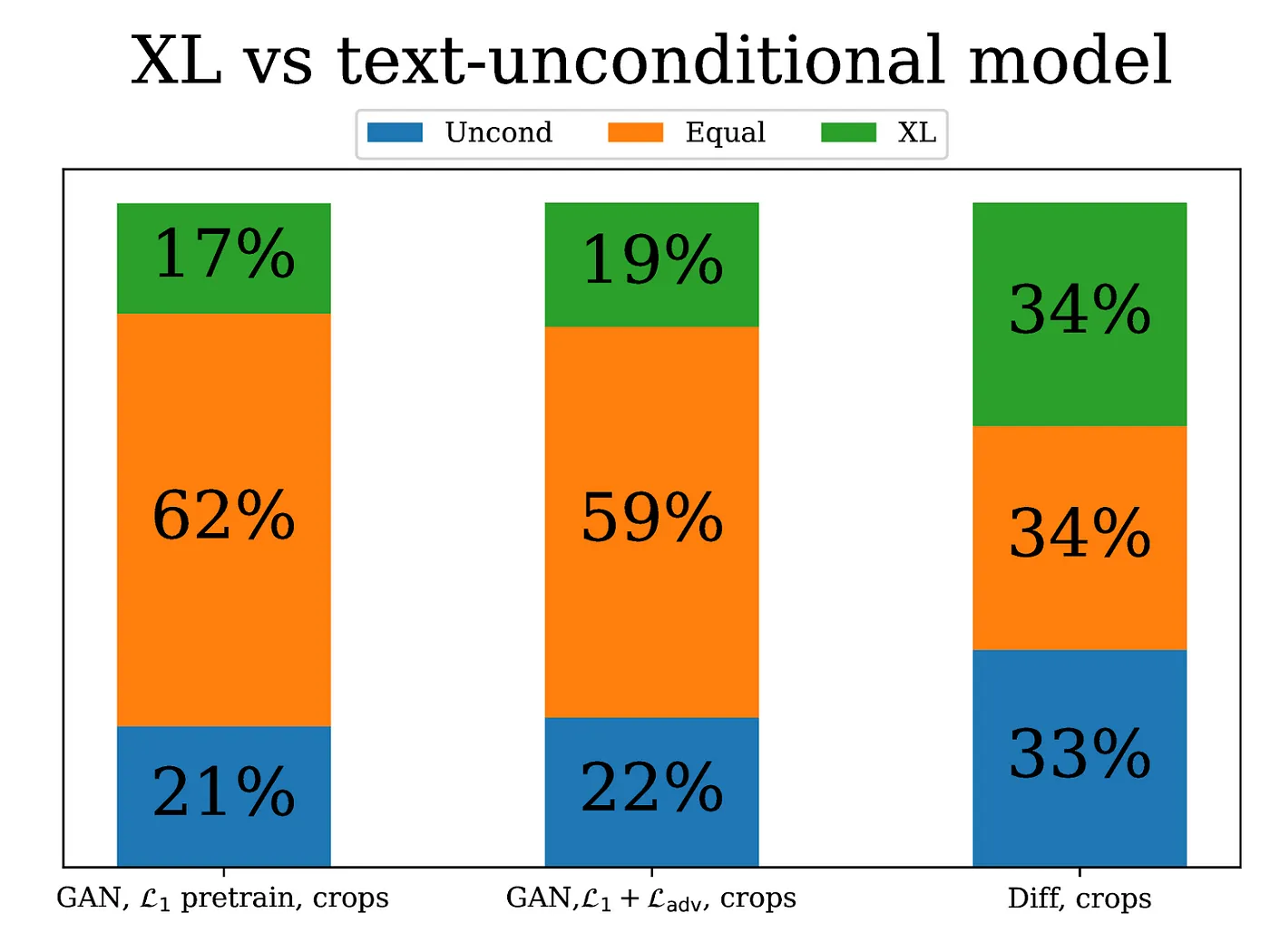

4) 文本条件处理最后,我们也通过使用两种类型的文本编码器将文本说明集成到模型中,来探索文本条件化的影响:

- 我们的内部类似CLIP的模型 — XL

- 一个UMT5编码器

下图展示了这些结果,其中每根柱状图代表一位人类标注者。每根柱状图表示人类标注者偏好文本条件模型(XL,绿色)、无条件模型(蓝色)或认为两者相等(橙色)的次数。

比较在标注者的评估下带有测试辅助生成(绿色)和无文本生成的偏好。(图片来源:论文)

虽然上面的图表是为我们内部的类似CLIP的模型——XL,下面的图则是UMT5编码器的类似图形:

比较在标注者的评估下带有测试辅助生成(绿色)和无文本生成的偏好。(图片来源:论文)

takeaway

这表明来自描述的全局语义信息可能对图像超分辨率任务帮助较小。

换句话说,额外的文本条件化并不会显著提升图像质量(根据我们的标注员的感知)。

结论至此,本文结束,本文对GANs和扩散模型进行了详尽的研究。

我们的研究表明,由于更快的训练时间和单步推理能力,GANs 在图像超分辨率任务中仍然具有很高的竞争力。

扩散模型虽然强大,但需要更多的计算资源和更长的训练时间才能达到类似的性能水平。

这些见解对于从业者和研究人员来说仍然至关重要。

他们强调在评估新方法时进行公平和受控的比较的重要性。

随着计算资源和数据可用性的持续增长,理解不同方法的真实优势和局限性变得越来越重要。

一如既往,感谢您的阅读!

参考资料[a] Chitwan Saharia, Jonathan Ho, William Chan, Tim Salimans, David J. Fleet, 和 Mohammad Norouzi. 通过迭代 refinement 实现图像超分辨率,2021。

[b] 李浩英, 杨逸凡, 张萌, 冯华军, 许志海, 李琪, 陈越婷. Srdiff: 使用扩散概率模型进行单图像超分辨率, 2021.

[c] Yue Zongsheng, Wang Jianyi, 和 Loy Chen Change. Resshift: 通过残差偏移实现图像超分辨率的高效扩散模型, 2023

-

实战:30 行代码做一个网页端的 AI 聊天助手11-20

-

5分钟搞懂大模型的重复惩罚后处理11-18

-

基于Ollama和pgai的个人知识助手项目:用Postgres和向量扩展打造智能数据库11-18

-

我用同一个提示测试了4款AI工具,看看谁设计的界面更棒11-15

-

深度学习面试的时候,如何回答1x1卷积的作用11-15

-

检索增强生成即服务:开发者的得力新帮手11-15

-

技术与传统:人工智能时代的最后一袭纱丽11-15

-

未结构化数据不仅仅是给嵌入用的:利用隐藏结构提升检索性能11-15

-

Emotion项目实战:新手入门教程11-15

-

7 个开源库助你构建增强检索生成(RAG)、代理和 AI 搜索11-15

-

Vertex AI上下文缓存与Gemini模型详解11-15

-

用可视化评估你的检索增强生成系统:RAG系统的评估与分析11-15

-

强化学习:教智能代理操作发电厂的方法11-15

-

质量工程师眼中的检索增强生成(RAG)解析11-15

-

让我们聊一聊算法和社会媒体那些事儿11-15