人工智能学习

多模态大型语言模型(MLLMs)正在改变计算机视觉领域

了解正在重新定义和变革计算机视觉的多模态大型语言模型(MLLMs)。

人工智能中多模态的迅速发展

本文介绍了什么是多模态大型语言模型(MLLM)[1],它们的应用以及使用具有挑战性的提示进行演示的顶级模型,这些模型正在重塑我们当前的计算机视觉。

🔥 了解 Segment Anything Model 2 (SAM 2):

- 🆕 SAM 2 + GPT-4o — 通过视觉提示级联基础模型 — 第1部分

- 什么是多模态大型语言模型(MLLM)?

- 多模态大型语言模型在计算机视觉中的应用和用例

- 顶级多模态大型语言模型

- 未来展望

用通俗的话说,多模态大型语言模型(MLLM)是一种将大型语言模型(LLM)的推理能力,例如GPT-3 [2]或LLaMA-3 [3],与处理、理解和输出多模态信息的能力结合起来的模型。

图1展示了医疗领域中的一个多模态AI系统[4]。该系统接收两个输入:1)一张医学图像和2)一个文本查询:“这张图像中是否存在胸腔积液?”。系统输出包括对给定查询的回答(即,一个预测)。

图1. 通过将放射学视觉编码器与LLM [4]对齐而创建的多模态医疗系统

👉 在本文中,我们可能会将 多模态模型 用作 MLLM 的快捷术语。

在过去几年中,人工智能领域发生了显著的变化,很大程度上是由Transformer在语言模型中的崛起所驱动的[5][6]。毫不意外的是,这种由Google在2017年发明的架构也影响了计算机视觉领域。

最早的例子之一是视觉变压器(ViT)[7],它使用变压器将图像分割成多个补丁,将它们视为单独的视觉标记进行输入表示。

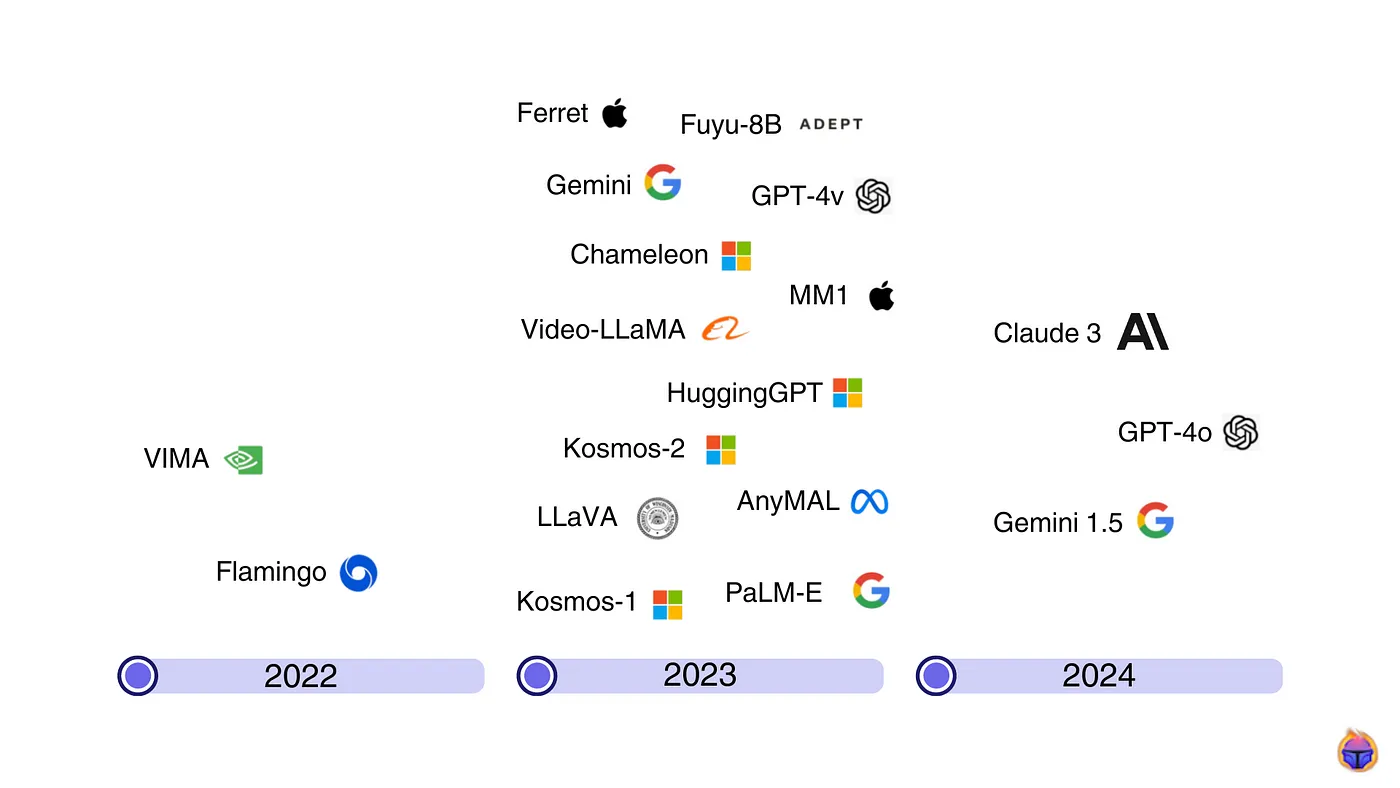

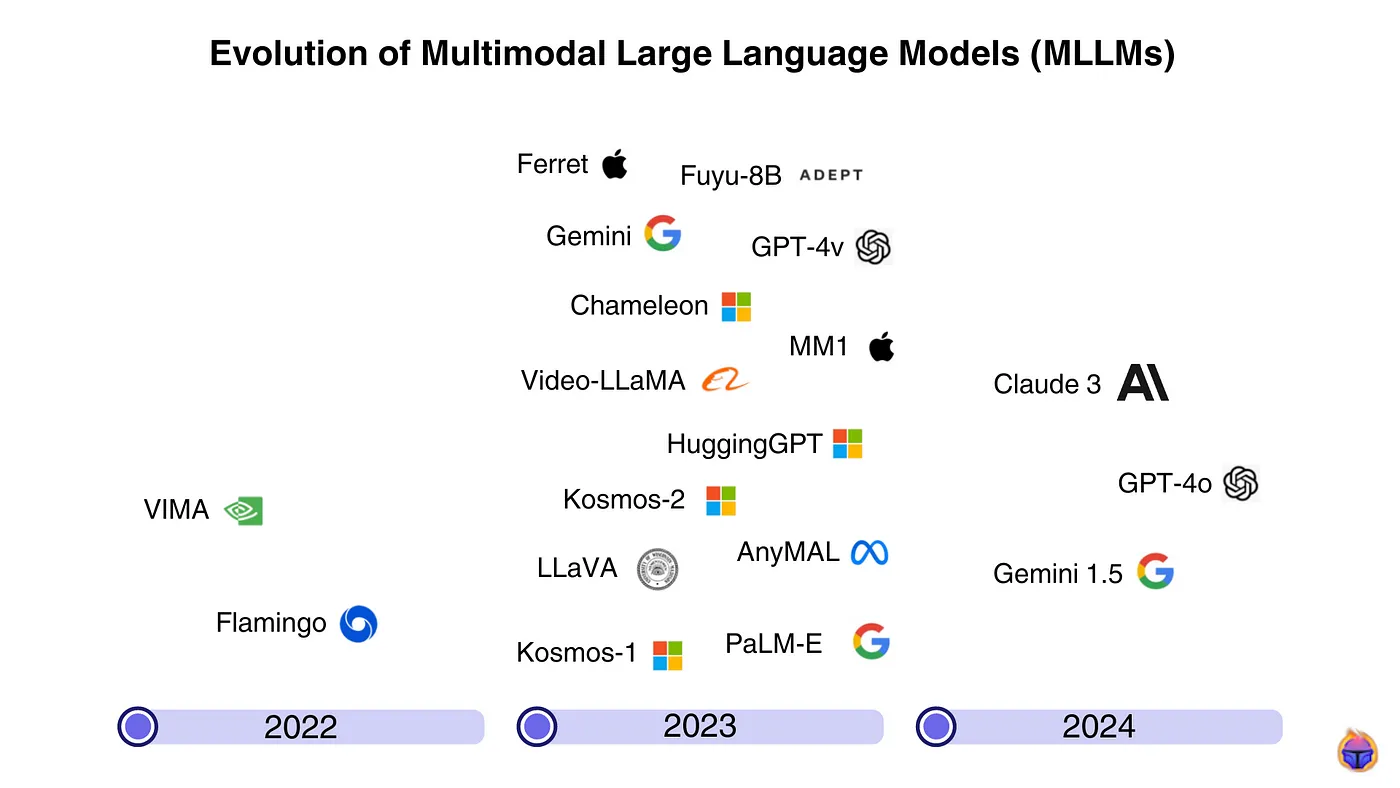

图2. 2022年至2024年间开发的一些多模态大型语言模型(MLLMs)

随着大型语言模型(LLMs)的兴起,一种新的生成模型——多模态大型语言模型(MLLMs)自然地出现了。

如图2所示,2023年大多数大型科技公司至少开发了一种多模态大型语言模型。2024年5月,OpenAI的GPT-4o发布时引起了广泛关注。

有些人认为大语言模型实际上是基础模型。例如,Google 的 Vertex AI 将多模态大语言模型,如 Claude 3、PaliGemma 或 Gemini 1.5 视为基础模型 🤔。

👉 了解更多关于计算机视觉中的基础模型的内容,请参阅此帖子。

另一方面,视觉语言模型(VLMs)[8] 是一类多模态模型,它们结合了文本和图像输入并生成文本输出。

多模态模型与视觉语言模型(VLMs)的主要区别在于:(1) 多模态模型能够处理更多的模态,而不仅仅是文本和图像,这是VLMs的局限;(2) VLMs在推理能力方面表现较差。

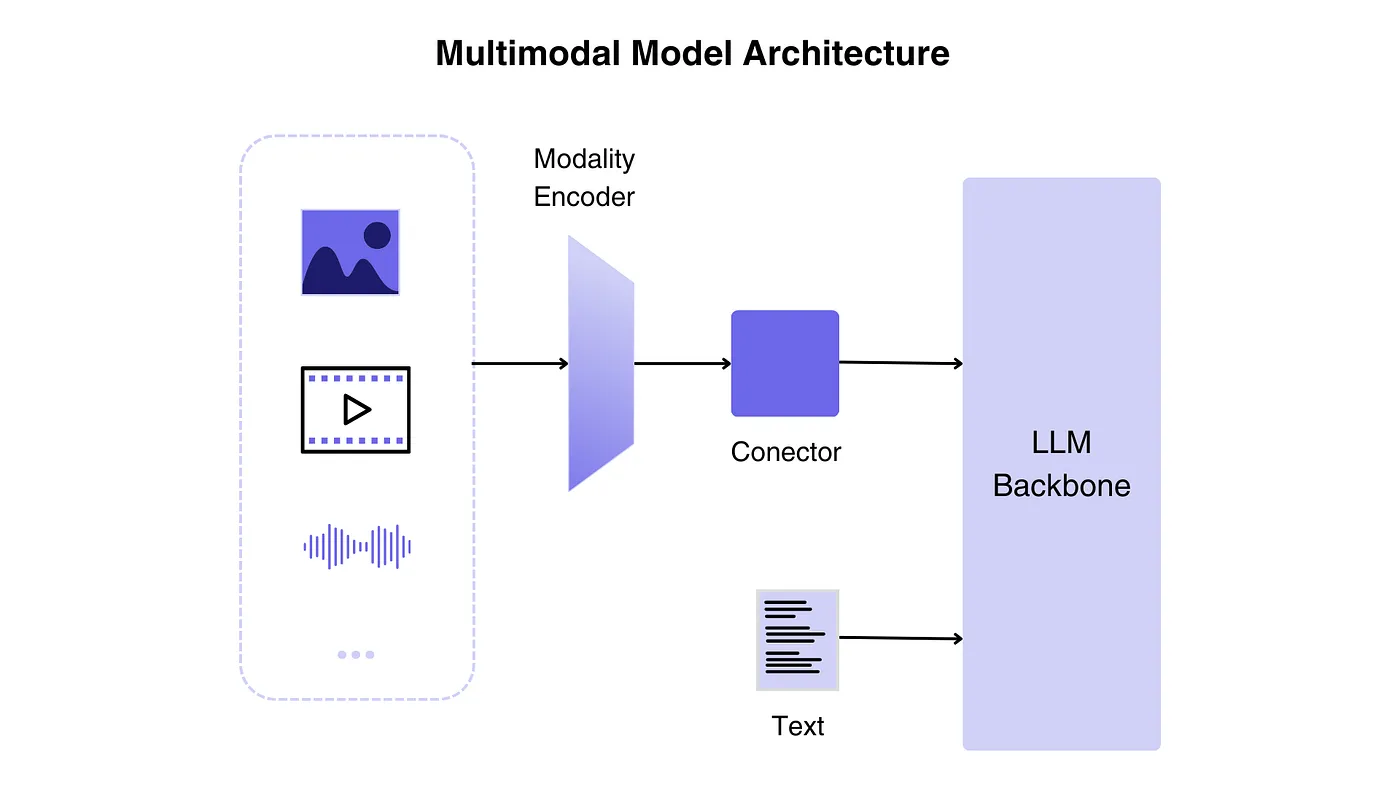

如图3所示,多语言大型语言模型的架构分为三个部分:

- 模态编码器:编码组件将原始数据格式(如视觉或声音)压缩成更简洁的表示形式。而不是从头开始训练过程,一种常见的策略是利用经过其他模态校准的预训练编码器(例如,CLIP)。

- 语言模型骨干:需要一个语言模型来输出文本响应。它充当 MLLM 的“大脑”。编码器接收图像、音频或视频并生成特征,这些特征由连接器(或模态接口)处理。

- 模态接口(即,连接器):这作为编码器和语言模型之间的中间媒介或链接。由于语言模型只能解释文本,因此有效地将文本与其他模态连接起来至关重要。

图3. 多模态理解:多模态第一阶段的组件

相反,我们没有列出这些模型在不同用例中的优秀表现,而是分配了一些 GPU 来测试三个顶级的 MLLM,使用了一些具有挑战性的查询(不再有猫 😺 和狗 🐶 的例子)。

- GPT-4o [9]: 由OpenAI于2024年5月发布的最强大的多模态模型。我们通过OpenAI的API 视觉能力访问了该模型。

- LLaVA 7b [10]: 一个源自开源LlaMa模型的多模态模型,集成了视觉编码器和Vicuna,用于通用的视觉和语言理解,有时性能可与GPT-4媲美。我们通过在Jarvislab上启动一个Ollama实例来访问该模型。

- Apple Ferret 7b [11]: 由Apple开发的开源多模态大型语言模型(MLLM)。该模型通过引用和定位来实现空间理解,能够识别和描述图像中的任何形状,提供精确的理解,特别是在较小的图像区域上。我们通过在JavisLab.上启动一个Ferret实例来访问该模型。

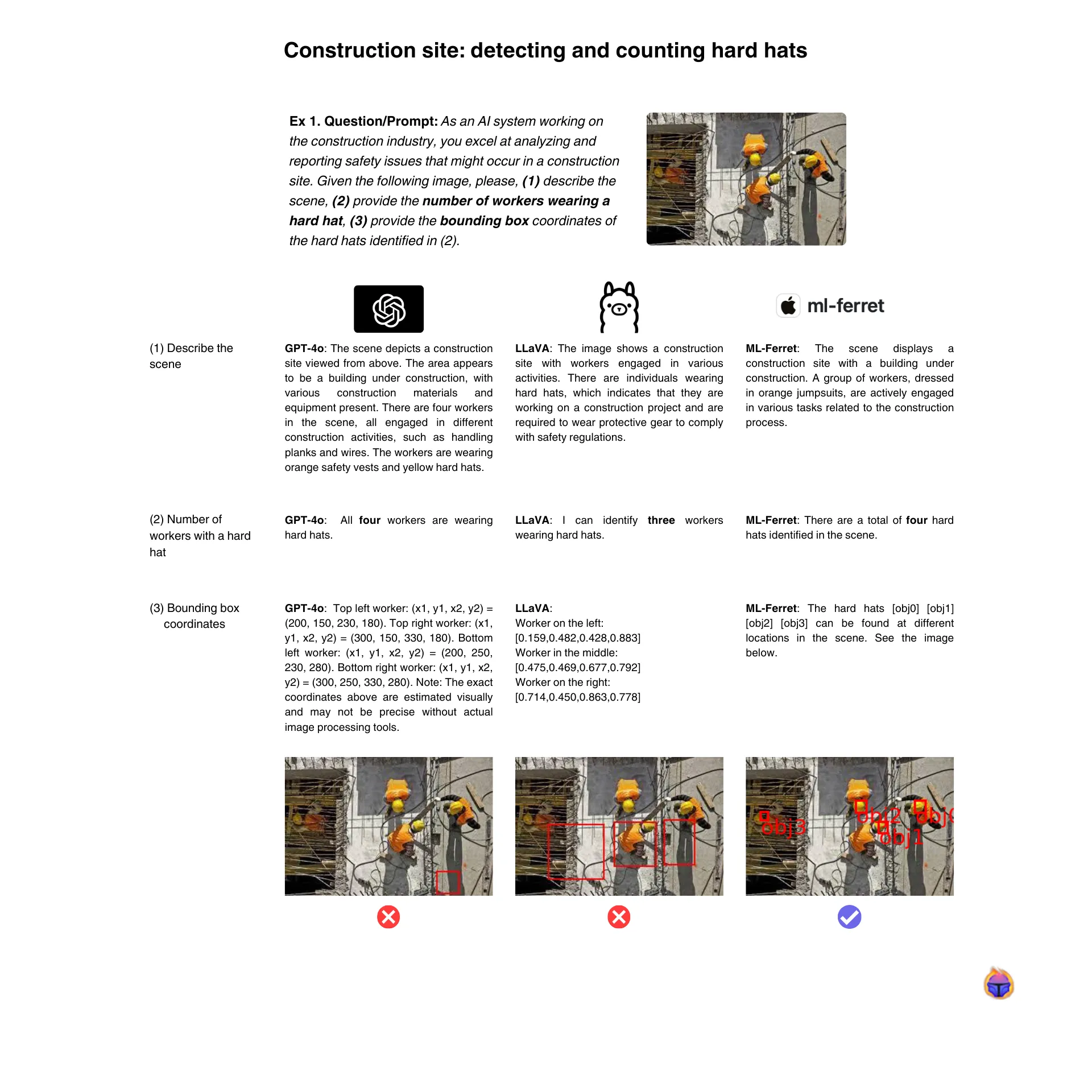

图4展示了当给定一张图片和一个要求他们数安全帽的难题提示时,这三个顶级模型的表现。

图4. Apple的Ferret模型是唯一一个正确识别出边界框位置(包括被遮挡的那个)的模型。

尽管提供了非常丰富的场景描述(见图4),GPT-4o 仍然给出了错误的坐标来定位所需的硬帽:其中一些坐标超出了当前图像的尺寸范围,因此我们只看到了右下角的一个边界框。

开源模型 LLaVA 无法检测到所有的四个安全帽(它漏掉了左侧被遮挡的那个),并且提供的边界框位置也错误。

令人惊讶的是,Apple的Ferret竟然能够检测出图片中的四个对象:甚至左边被遮挡的那个也能检测出来!⭐️

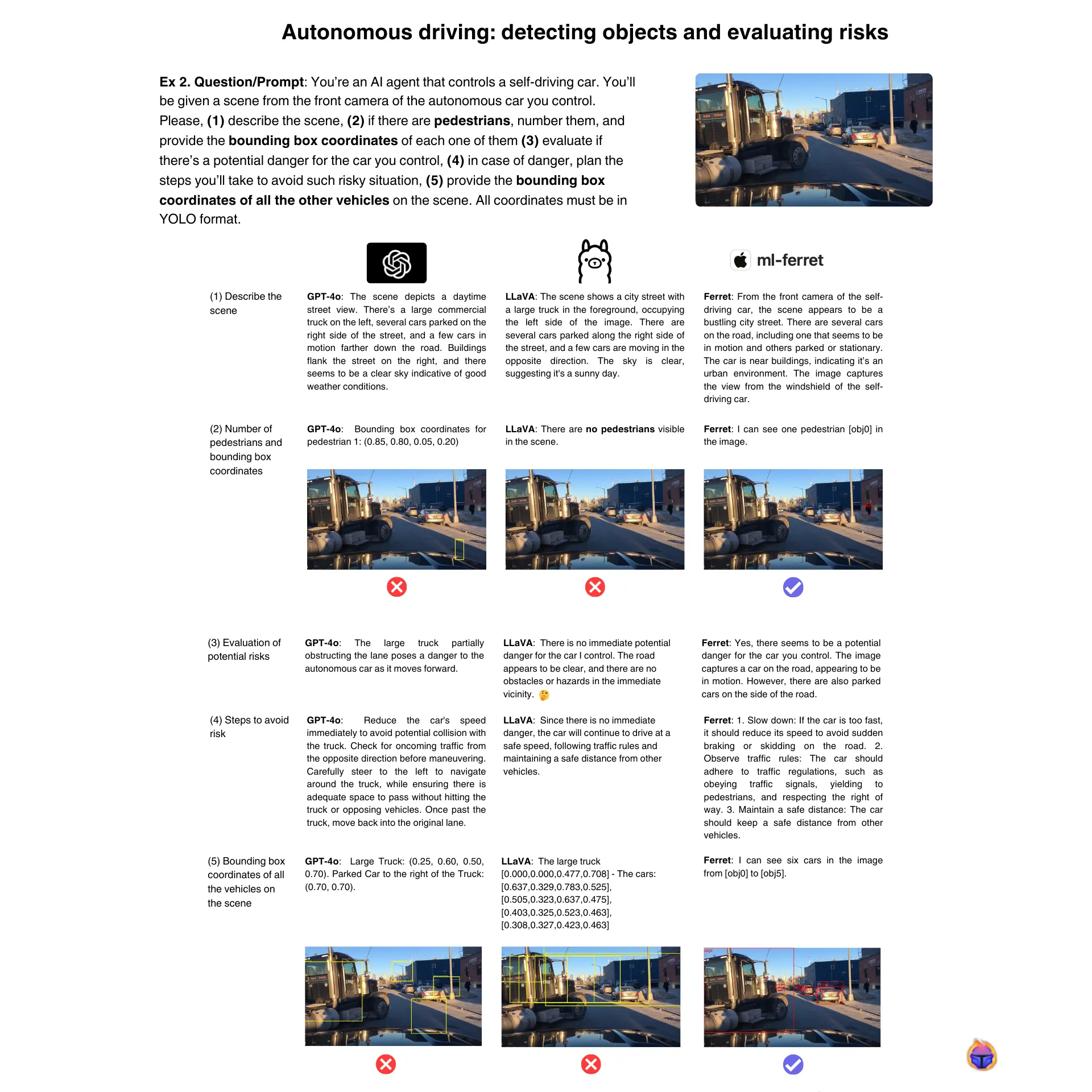

首先,我们从自主驾驶数据集中选择了这个场景。其次,我们增加了提示的难度:要求模型从自动驾驶汽车的视角评估风险,同时检测两个不同的类别,即车辆和行人(见图5)。

图5. 一个要求模型检测物体并评估风险的具有挑战性的提示:Apple Ferret 的模型表现优于 GPT-4o。

结果表明 LLaVA 表现得很差:它未能识别出自动驾驶汽车前方的大卡车,从而产生了幻觉。开源模型在面对挑战性任务时真的这么差吗?🤔

虽然 GPT-4o 在返回有理有据的详细文本回复方面表现出色,但在清晰检测边界框方面却表现不佳。相比之下,Apple的Ferret 是 唯一一个 能够准确检测大多数对象并提供准确边界框坐标的模型 ✅。

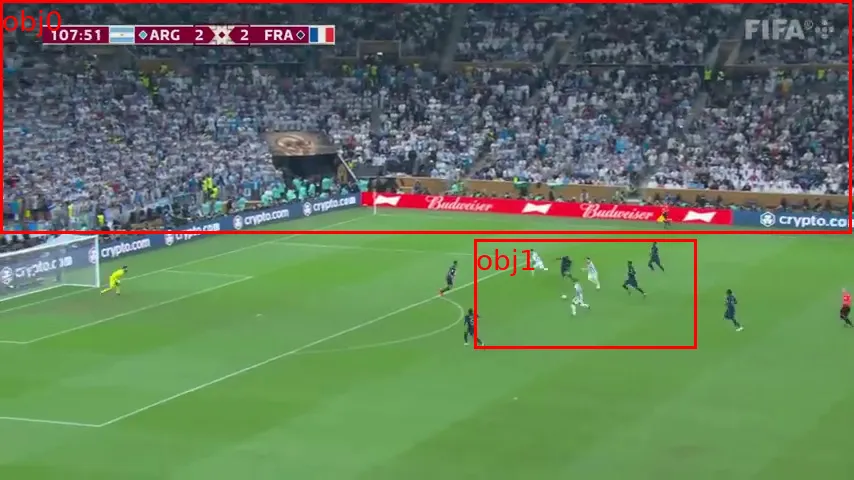

直到现在,至少有一款模型,即苹果的 Ferret,在计数和检测物体方面表现出色。现在让我们转向一个更具挑战性的场景:体育分析 ⚽️。

通常,单模态微调架构,如 YOLO,在检测足球比赛中球员时表现得很好:Ccn MLLMs 表现也很好吗?

图6. 在本文中测试的三个多模态大型语言模型的一个足球比赛场景

示例 3. 问题/提示 : 作为一位擅长体育,特别是足球的AI系统,你将被提供一场足球比赛的场景。请(1)描述该场景,(2)计算每队的球员人数,(3)提供足球和守门员的边界框坐标,(4)估计进球的可能性并说出哪一队可能进球。

如图7所示,检测玩家和球时,我们分析的三个模型都失败了!没有一个模型能够识别两个队伍及其队员。

图7. 本文中提到的任何多模态大型语言模型都无法检测到提示中请求的对象

所以,多模态大型语言模型(MLLMs)在平均水平上表现良好,但显然它们还没有准备好解决更复杂应用场景中的计算机视觉任务。即使是一个 YOLOv8 模型在这些特定(专业)任务中表现更好,🔍 详见我们关于此主题的文章《体育分析:计算机视觉的数据中心方法》。

微调大语言模型是更好的选择吗?🤔

现在,我们列出一些最重要的多模态大型语言模型,它们正在重新定义计算机视觉:

- 输入: 文本、图像、音频(测试版)、视频(测试版)。

- 输出: 文本、图像。

- 是什么: GPT-4o 代表“GPT-4 全能”,其中“全能”指的是它在文本、视觉和音频模态上的多模态能力。它是一个单一的统一模型,可以理解和生成任何组合的文本、图像、音频和视频输入/输出。

- 尝试在这里: https://chatgpt.com/

- 🥂 小知识: GPT-4o 采用了一种“多模态思维链”方法,首先它会思考如何将一个问题分解为一系列跨不同模态(文本、视觉、音频)的步骤,然后执行这些步骤以得出最终解决方案。

- 输入: 文本,图像。

- 输出: 文本,图像。

- 是什么: 具有20万令牌上下文窗口,Claude 3.5 Sonnet 是一个多模态AI系统,可以理解和生成文本、图像、音频及其他数据格式。在金融、生命科学和软件工程等各个领域擅长深入分析、研究、假设生成和任务自动化。

- 尝试这里: https://claude.ai

- 🥂 小知识: Anthropic 使用一种称为“递归奖励建模”的技术,该技术涉及使用较早版本的Claude为模型输出提供反馈和奖励。

- 输入: 文本、图像。

- 输出: 文本。

- 是什么: LLaVA(大型语言和视觉助手)是一个开源的多模态AI模型,可以处理和生成文本和视觉数据作为输入和输出。它具备与GPT-4相似的聊天能力,并在Science QA上创下了新纪录,展示了先进的视觉-语言理解能力。

- 尝试这里: https://llava-vl.github.io

- 🥂 小知识: LLaVA使用一种称为“指令调优”的技术进行训练,在这种技术中,GPT-4用于生成涉及文本和图像的合成多模态任务(2023年的新颖之处)。LLAFA从GPT-4生成的这些多样化的示例中学习,而无需直接的人类监督。

-

输入: 文本,图像,

-

输出: 文本,图像。

-

是什么: Gemini 是由 Google 开发的一系列大型语言模型,可以理解和操作多种模态,如文本、图像、音频(测试中)和视频(测试中)。它于 2023 年 12 月首次发布,有三个优化版本——Gemini Ultra(最大)、Gemini Pro(用于扩展)和 Gemini Nano(用于设备端任务)。

-

尝试一下: https://gemini.google.com/

- 🥂 (显而易见) 小知识: Gemini 的名字取自双子座,希腊神话中的“双胞胎”。这恰当地反映了 Gemini 具有处理和生成文本、图像、音频和视频等多模态数据的强大能力。

- 输入: 文本,图像,

- 输出: 文本,图像。

- 是什么: Qwen-VL 是一个开源的多模态AI模型,结合了语言和视觉能力。它是Qwen语言模型的扩展,旨在克服多模态泛化的局限性。最近升级的版本(Qwen-VL-Plus 和 Qwen-VL-Max)在图像推理、图像和文本的细节分析以及对不同宽高比的高分辨率图像支持方面有所改进。

- 试用地址: https://qwenlm.github.io/blog/qwen-vl/

- 🥂 (趣味小知识): 发布后,Qwen-VL 快速登顶OpenVLM排行榜,但随后被其他更强大的模型超越,尤其是GPT-4o。

多模态模型正在彻底改变计算机视觉。作为一名ML/MLOps工程师,在构建稳健的AI管道时,你如何最好地利用它们?

此外,这些模型,其中一些也被称为基础模型,如何影响传统的计算机视觉管道呢?🤔 在Tenyks我们相信,这些模型正在为一种新的管道铺平道路:计算机视觉管道2.0。

了解更多关于多模态和基础模型的最新进展,请关注我们全新的CVPR 2024系列:

- CVPR 2024: 图像和视频搜索与理解(RAG、多模态、嵌入等)

- CVPR 2024 最高亮点:具身AI、生成AI、基础模型和视频理解

[[1](http://A Survey on Multimodal Large Language Models)] 多模态大型语言模型综述

[2] 语言模型是少样本学习者

[3] 推出 Meta Llama-3:迄今为止最强大的公开可用的大型语言模型

[4] 多模态医学AI

[5] 注意力就是你所需要的

[6] 语言模型是无监督的多任务学习者

[7] 一张图片值16x16个词:用于大规模图像识别的变压器

[8] 视觉-语言模型入门

[9] GPT-4o

[10] LLaVA:大型语言和视觉助手

[11] FERRET:在任何粒度级别上任何地方引用和定位任何内容

作者 : Jose Gabriel Islas Montero, Dmitry Kazhdan.

如果您想了解更多关于Tenyks的信息,可以探索sandbox_。

-

实战:30 行代码做一个网页端的 AI 聊天助手11-20

-

5分钟搞懂大模型的重复惩罚后处理11-18

-

基于Ollama和pgai的个人知识助手项目:用Postgres和向量扩展打造智能数据库11-18

-

我用同一个提示测试了4款AI工具,看看谁设计的界面更棒11-15

-

深度学习面试的时候,如何回答1x1卷积的作用11-15

-

检索增强生成即服务:开发者的得力新帮手11-15

-

技术与传统:人工智能时代的最后一袭纱丽11-15

-

未结构化数据不仅仅是给嵌入用的:利用隐藏结构提升检索性能11-15

-

Emotion项目实战:新手入门教程11-15

-

7 个开源库助你构建增强检索生成(RAG)、代理和 AI 搜索11-15

-

Vertex AI上下文缓存与Gemini模型详解11-15

-

用可视化评估你的检索增强生成系统:RAG系统的评估与分析11-15

-

强化学习:教智能代理操作发电厂的方法11-15

-

质量工程师眼中的检索增强生成(RAG)解析11-15

-

让我们聊一聊算法和社会媒体那些事儿11-15