人工智能学习

使用腾讯云GPU服务器搭建深度学习环境

本文主要是介绍使用腾讯云GPU服务器搭建深度学习环境,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

个人使用记录,非最佳实践,仅供参考,不断更新中……

购买服务器

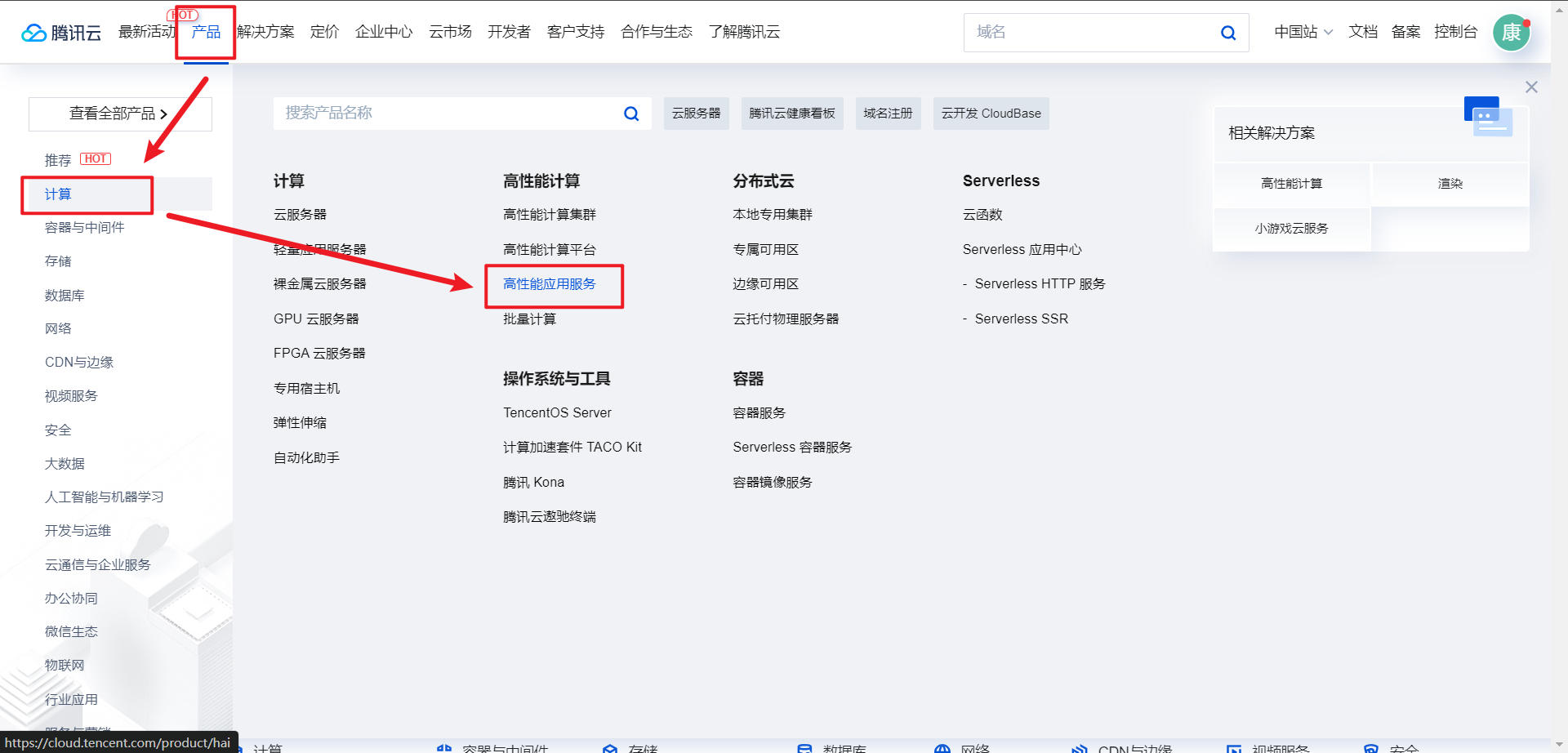

- 登录腾讯云官网 https://cloud.tencent.com/ ,“产品”-> “计算”-> “高性能应用服务”-> “立即使用”-> “新建”,进入新建页面。

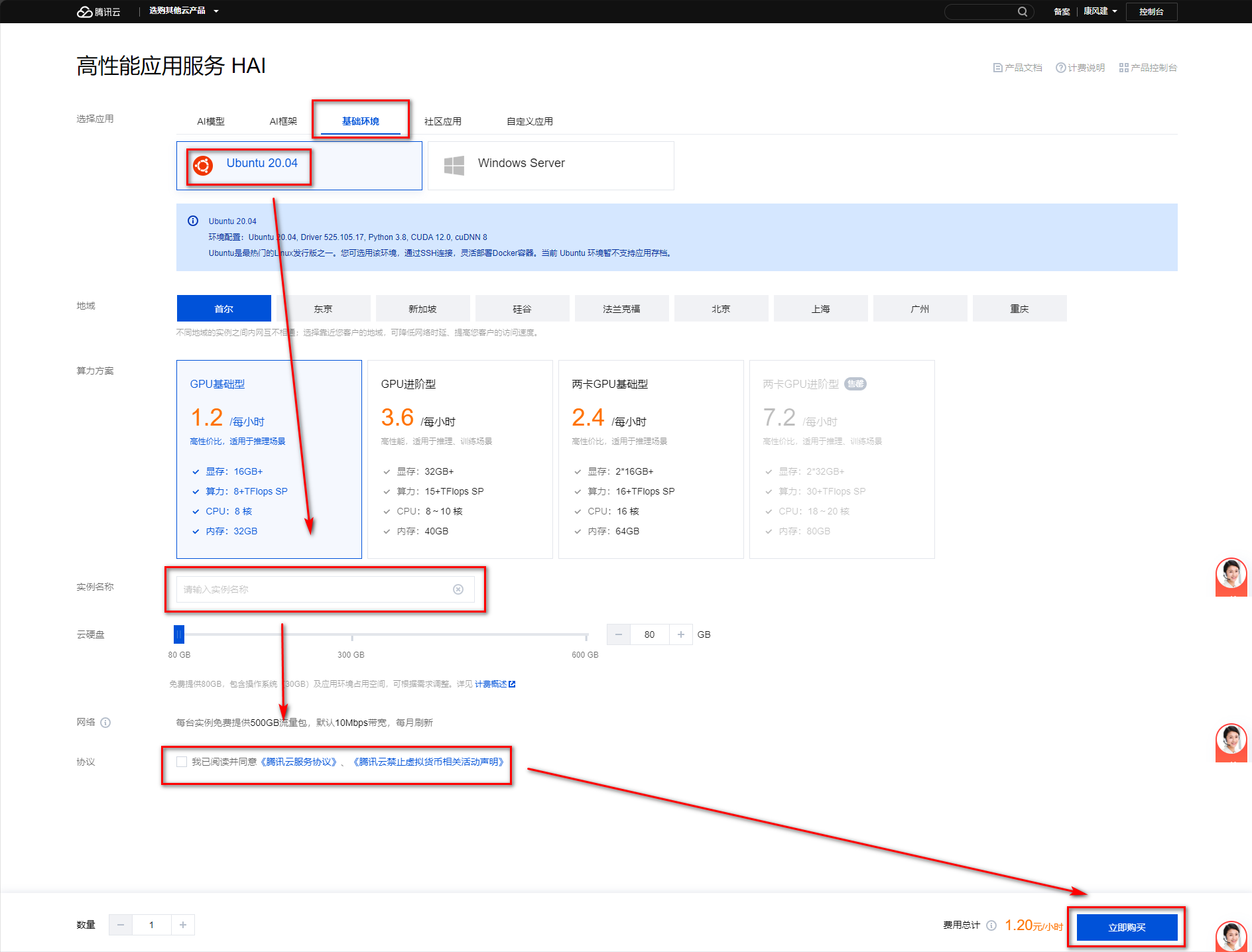

- 购买高性能应用服务器,“基础环境” -> “Ubuntu 20.04”-> “实例名称”-> “同意协议”-> “立即购买”,点击“立即购买”购买后进入服务器创建页面。(此时不用付费,服务器开始使用后从余额扣费)

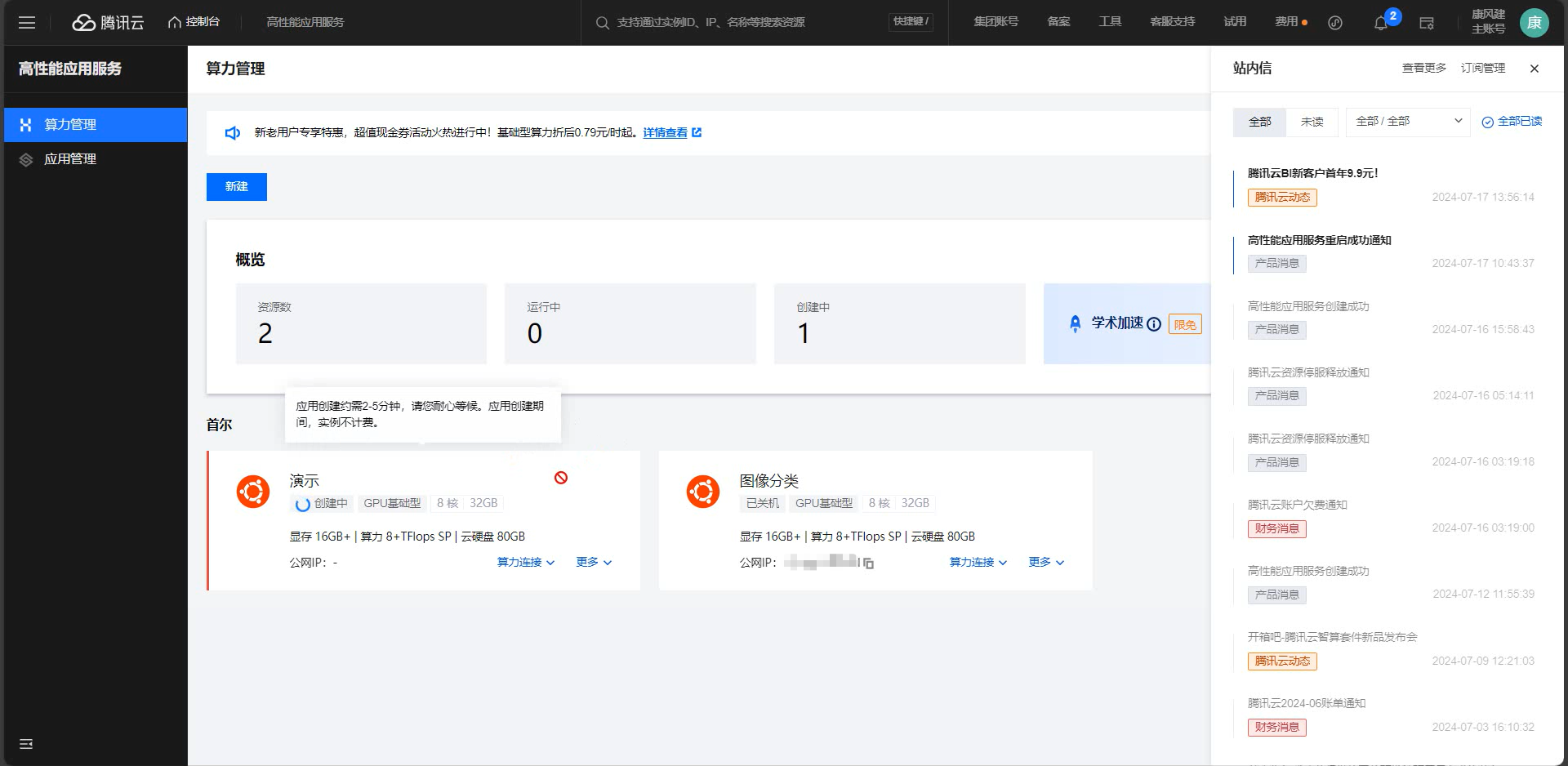

- 等待服务器创建完成

- 状态变为“运行中”表示创建成功

登录服务器

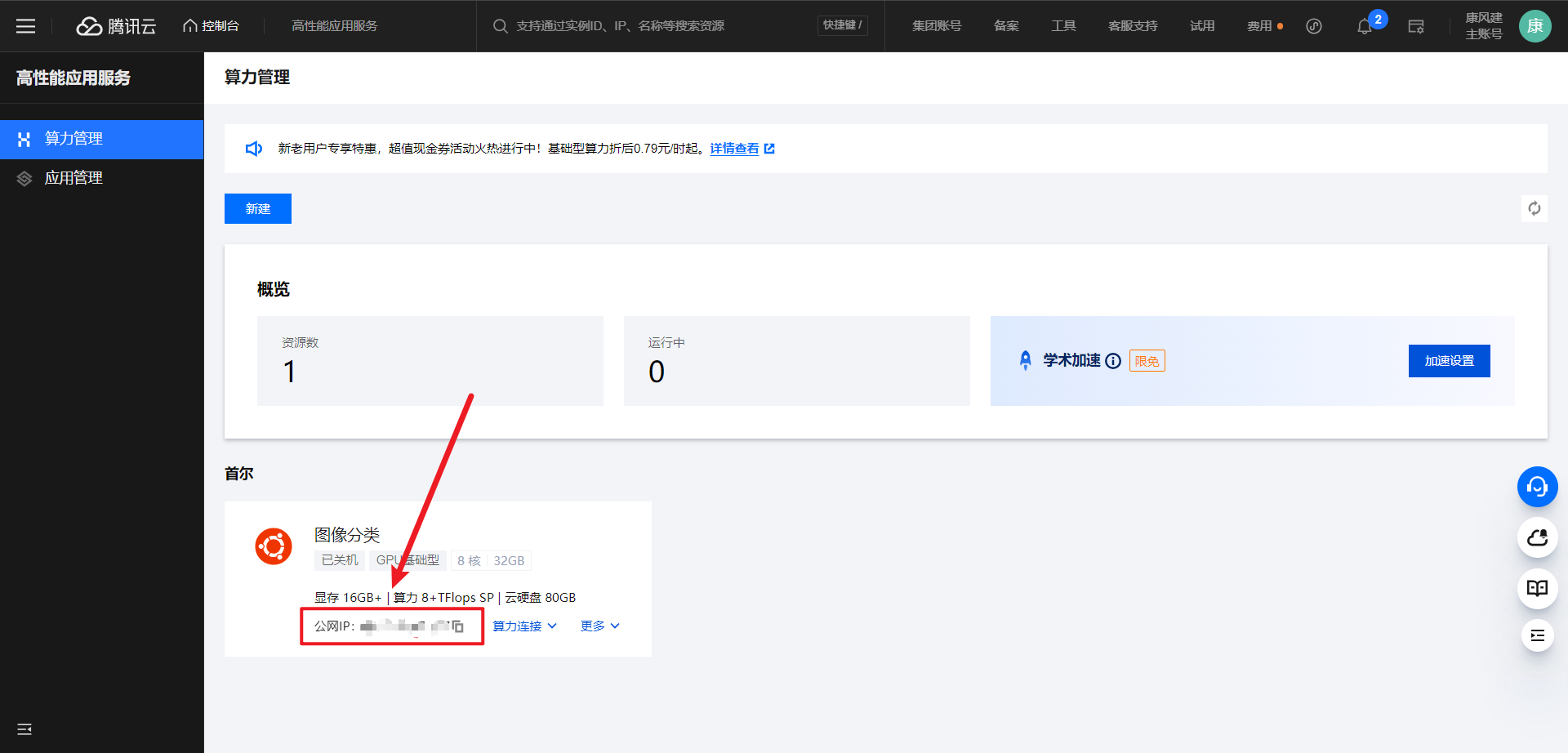

- 获取服务器公网IP

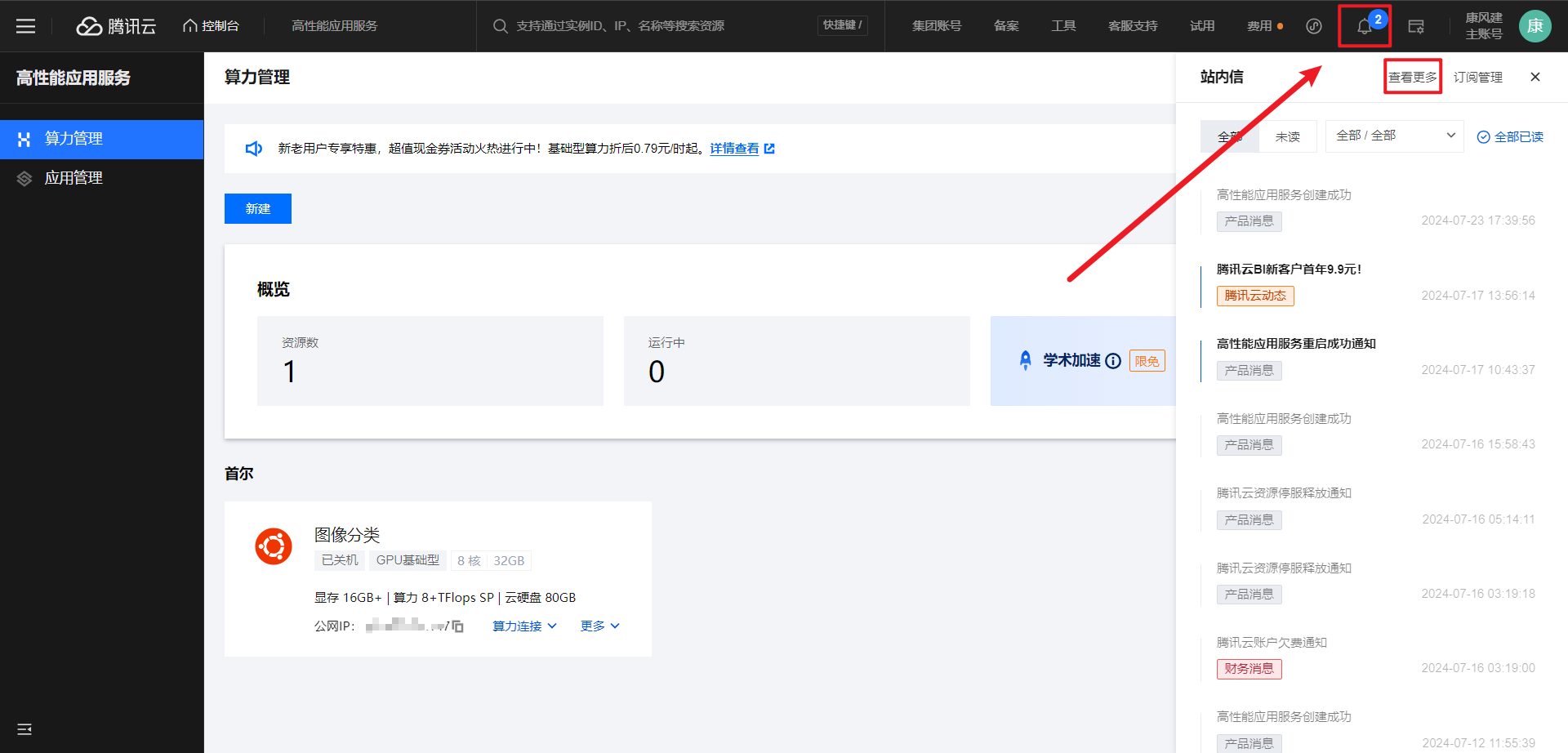

- 服务器创建完成后,右上角“通知小铃铛图标”-> “查看更多”

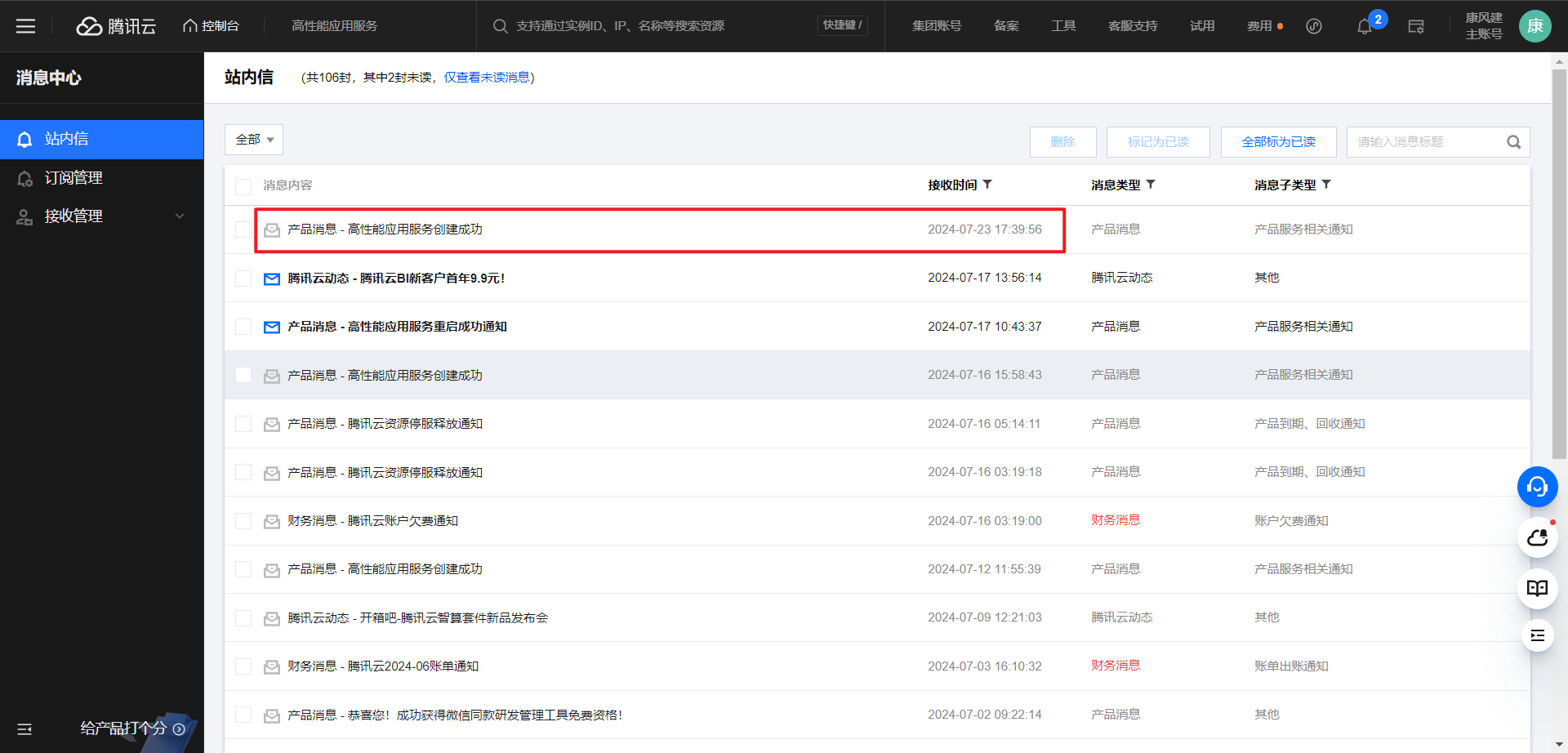

- 找到对应的消息,点击进入。(注意看时间,没有新消息的话刷新页面)

- 此处可以查看登录名和密码,注意保存。

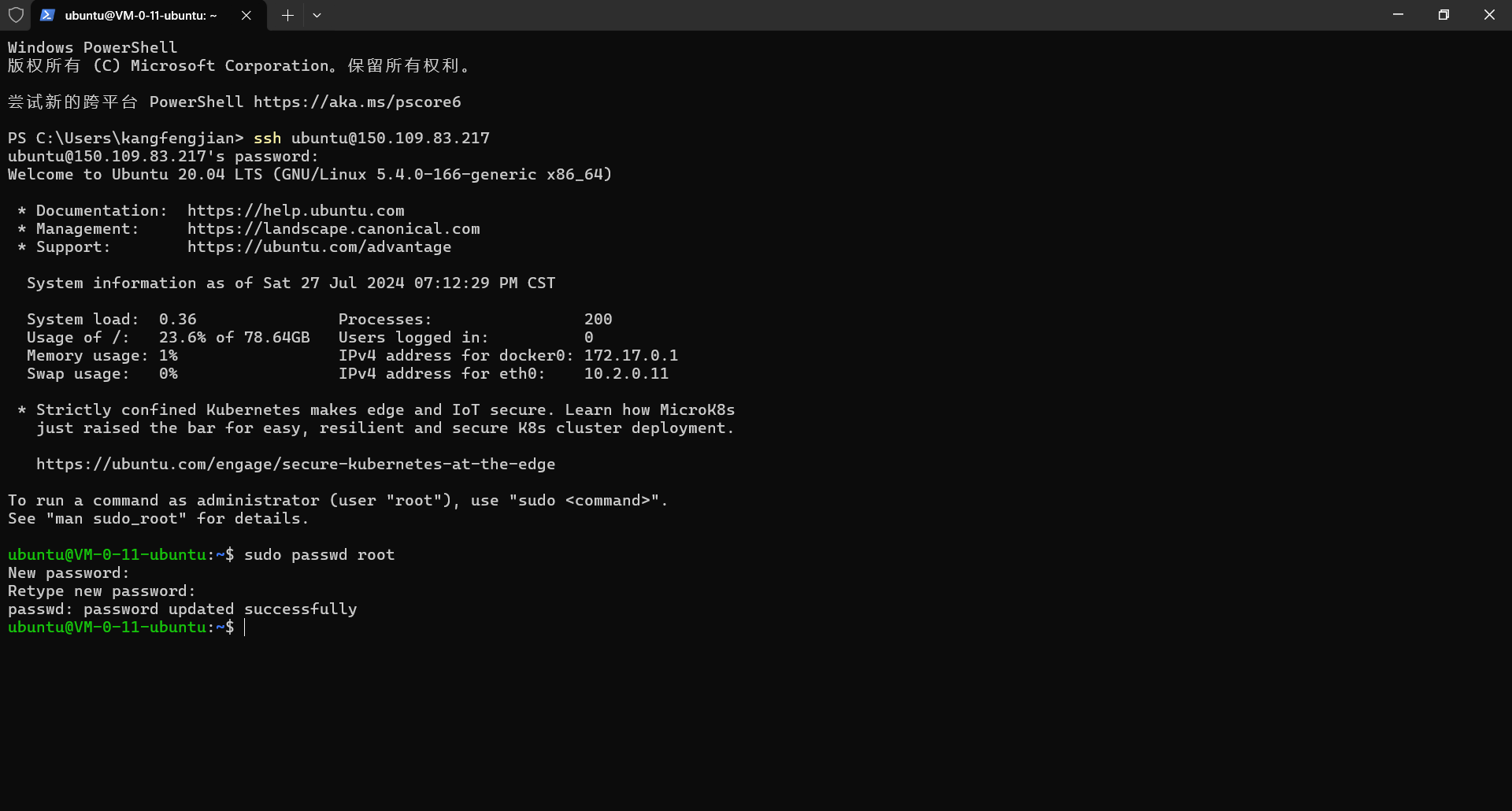

- 在任一终端使用 ssh 命令和 IP、用户名、密码登录。依次执行以下命令,这里使用 PowerShell 演示。

ssh ubuntu@42.42.42.42 # ssh连接,回车后输入密码,以服务器IP为 42.42.42.42 为例。 sudo passwd root # 设置root密码,注意保存,以后使用sudo命令会用到,回车后输入两次密码

安装 Miniconda

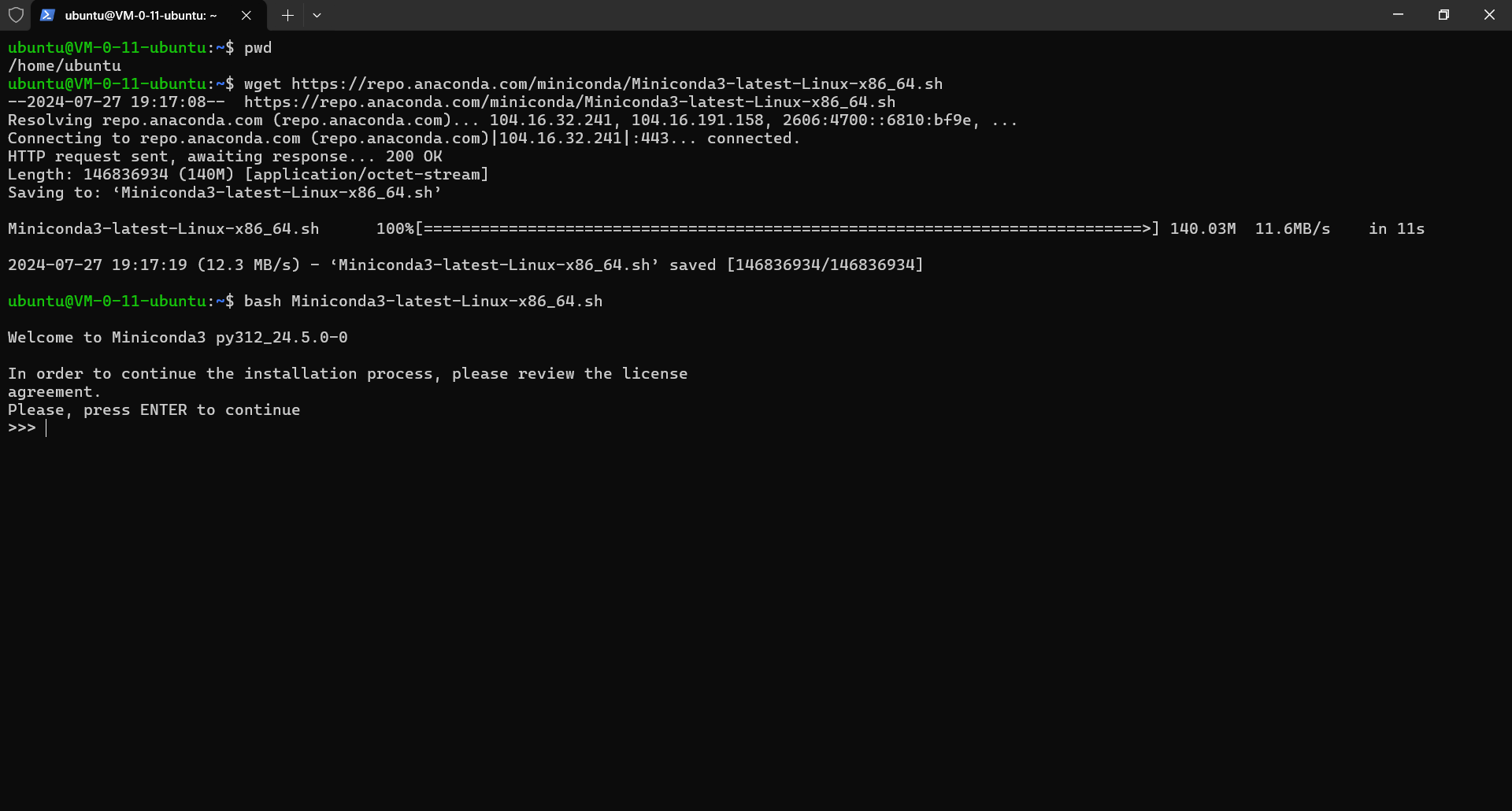

- 下载并安装 Miniconda,依次执行以下命令,直接在当前文件夹下执行即可

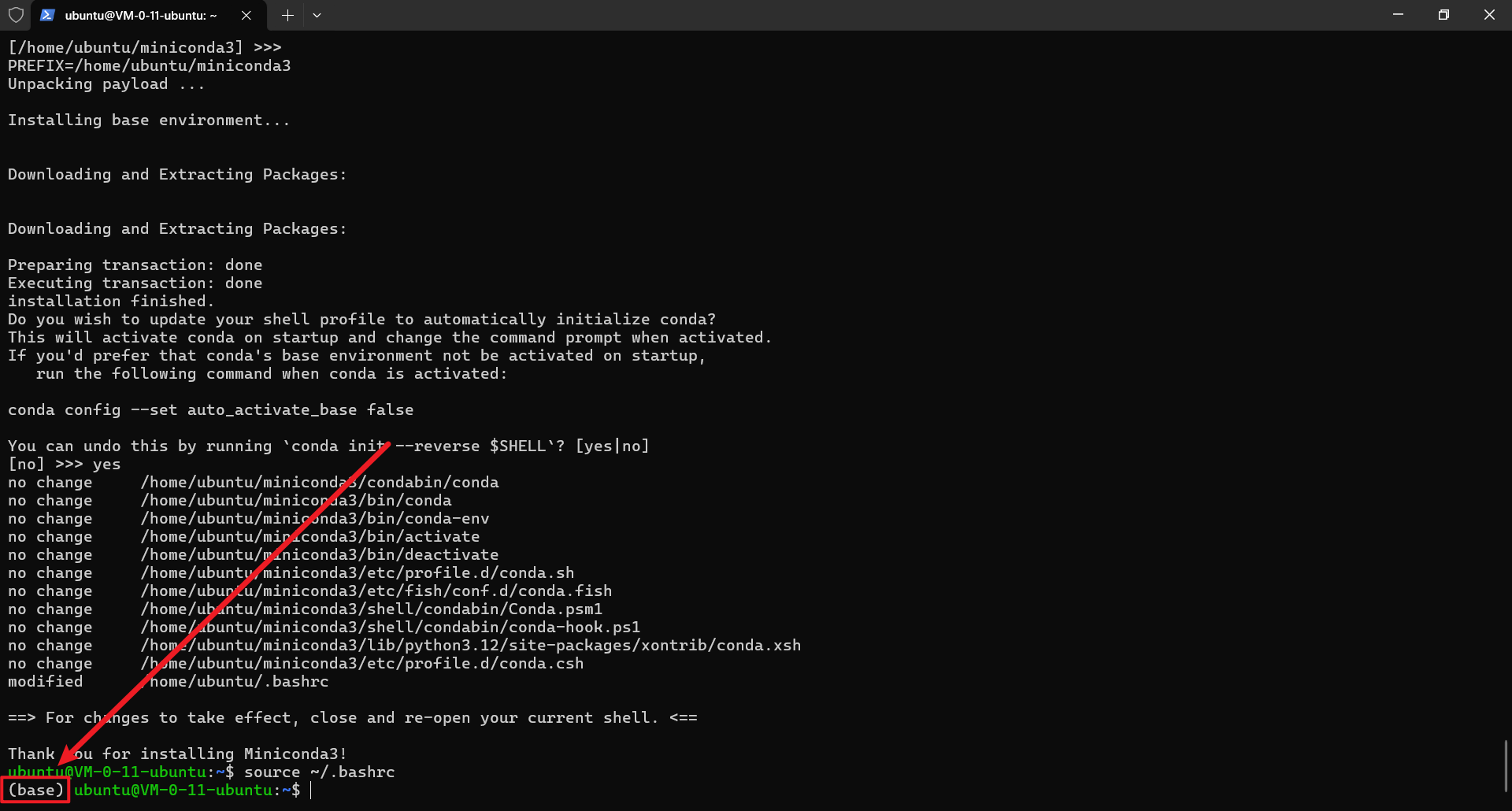

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh # 下载安装脚本 bash Miniconda3-latest-Linux-x86_64.sh # 执行安装脚本,过程中需要几处确认 source ~/.bashrc # 重新加载并执行 ~/.bashrc 文件中的命令和设置,使设置立即生效

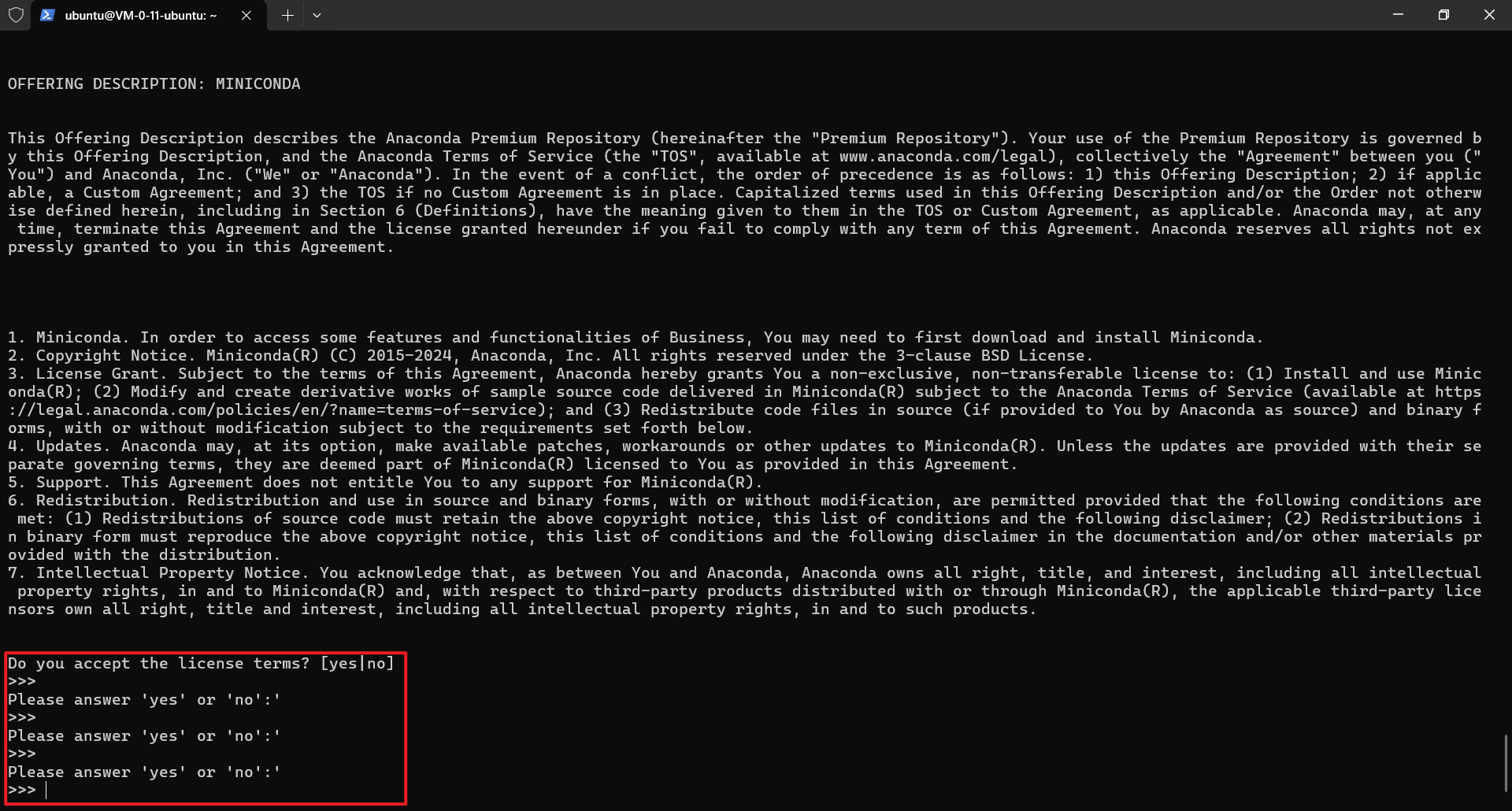

执行脚本后给出查看协议的提示,这里回车。

一直回车,直到给出是否同意协议的提示,此时输入 yes ,回车。

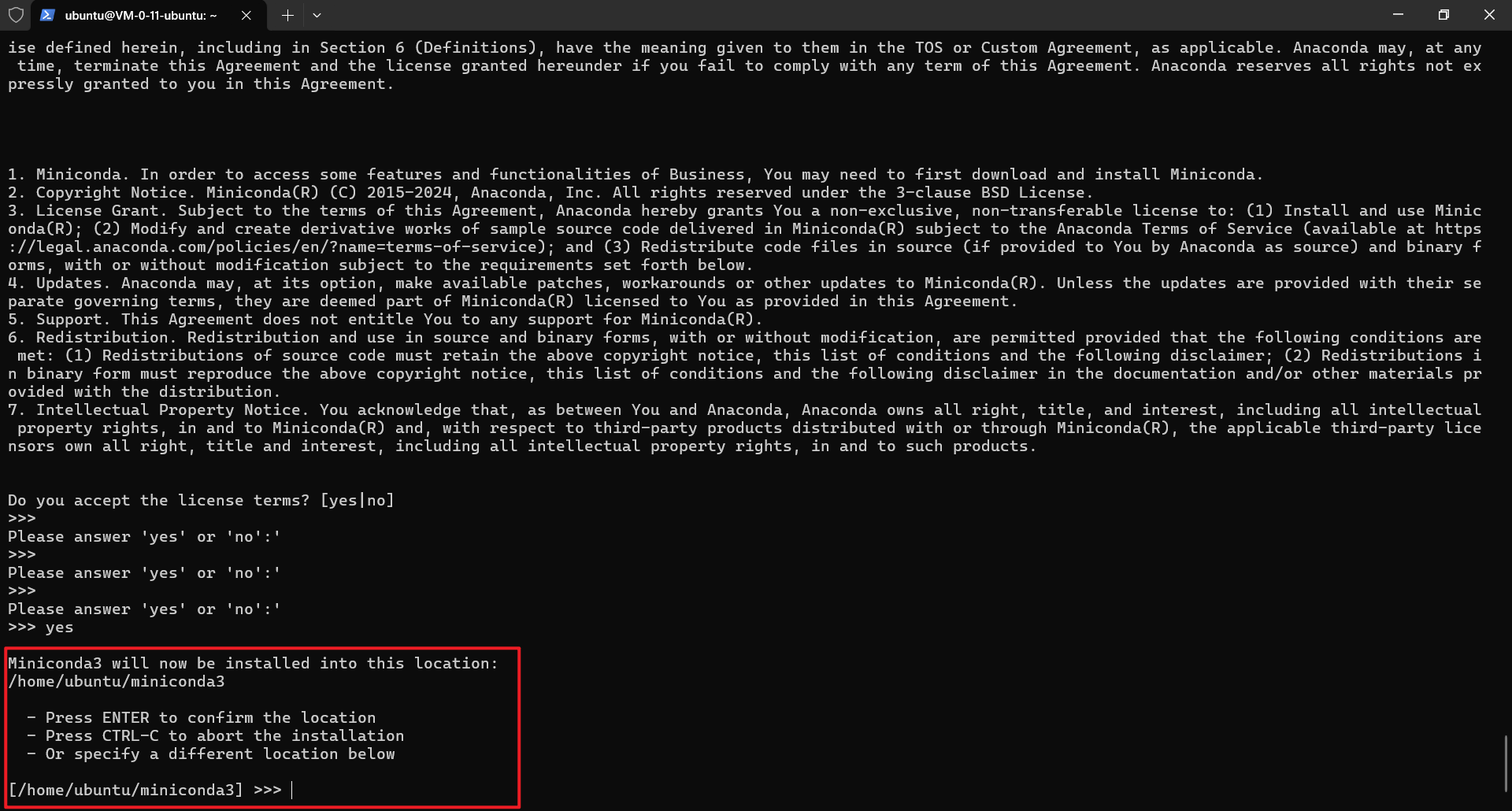

询问安装地址,这里使用默认地址即可,直接回车。

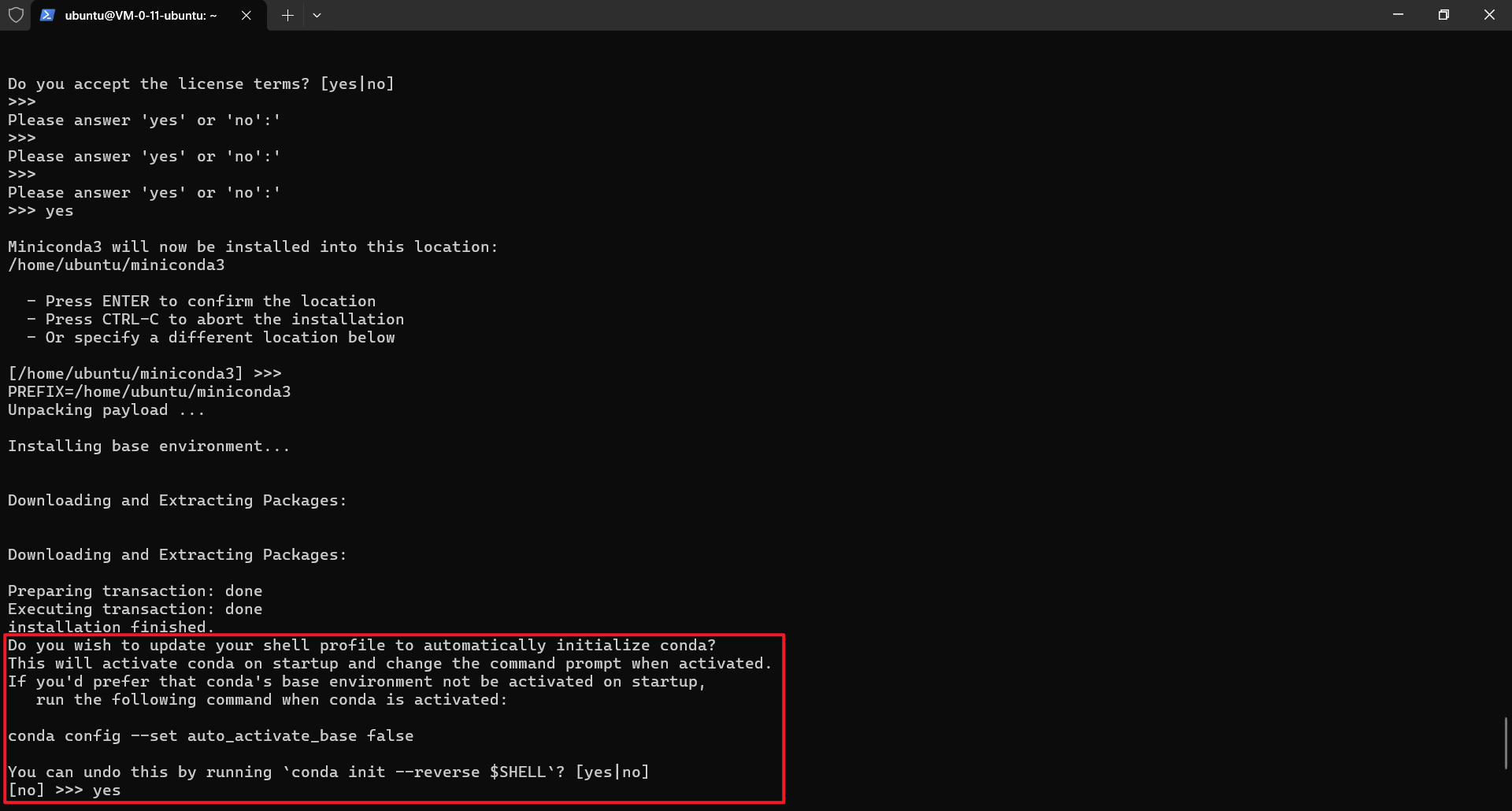

询问是否设置为进入系统直接激活 base 环境,可根据自己需求选择,我选择 yes,回车。

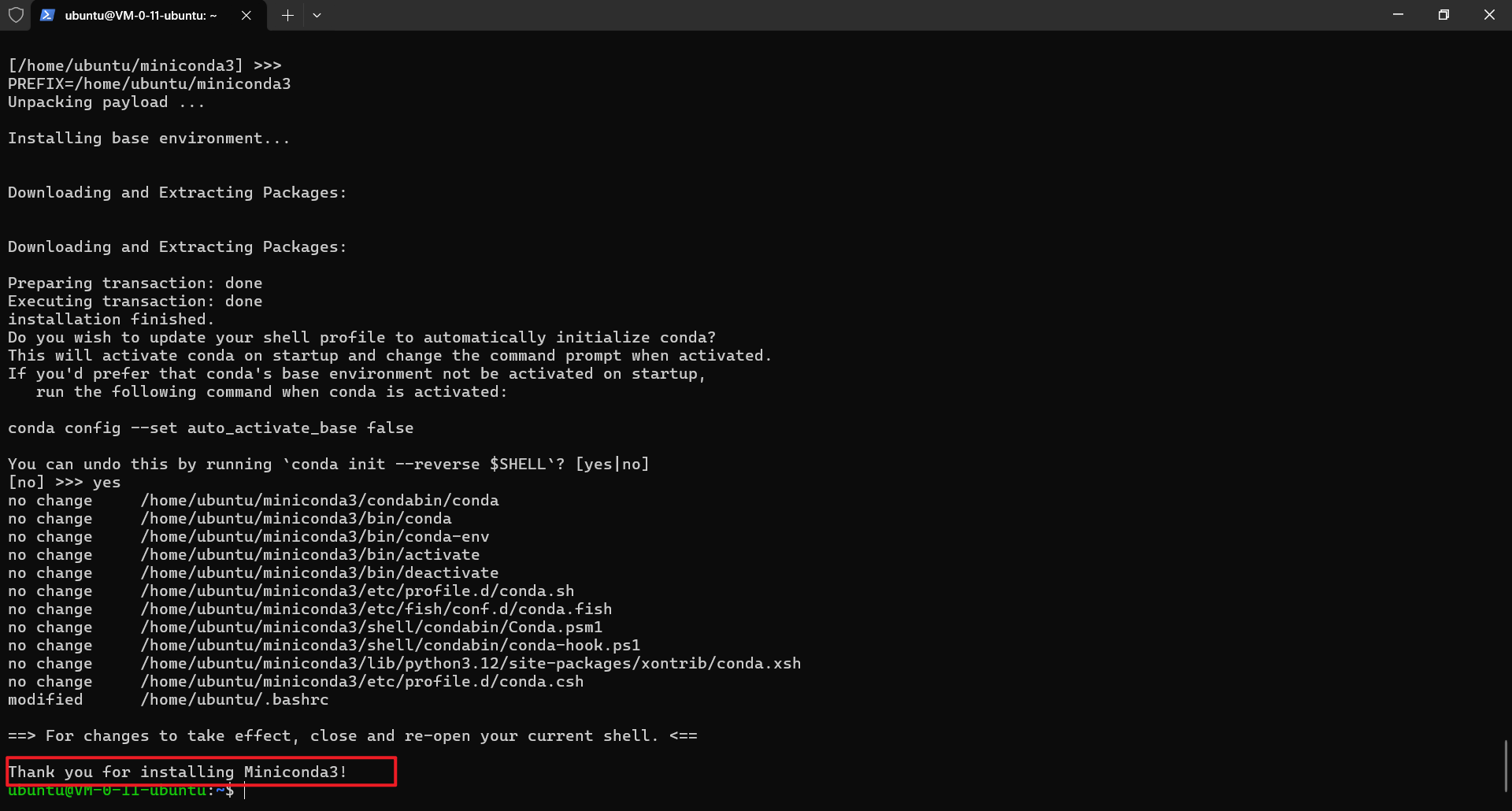

安装完成

重新加载并执行 ~/.bashrc 文件中的命令和设置,进入 base 环境

搭建python环境

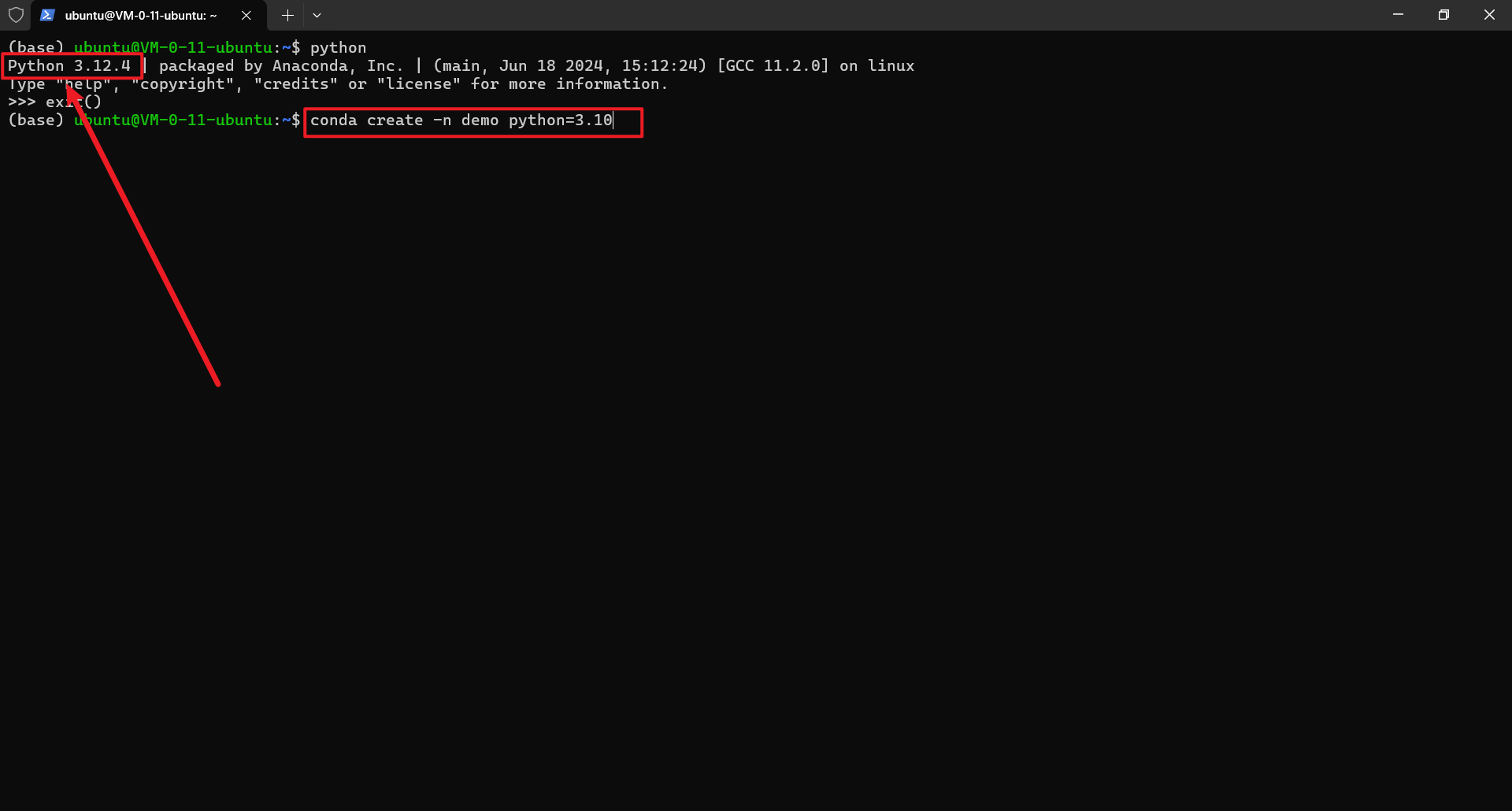

- base环境的python使用最新版本,可能遇到包文件不匹配的问题,此时新建一个虚拟环境,并指定python版本,依次执行以下命令。

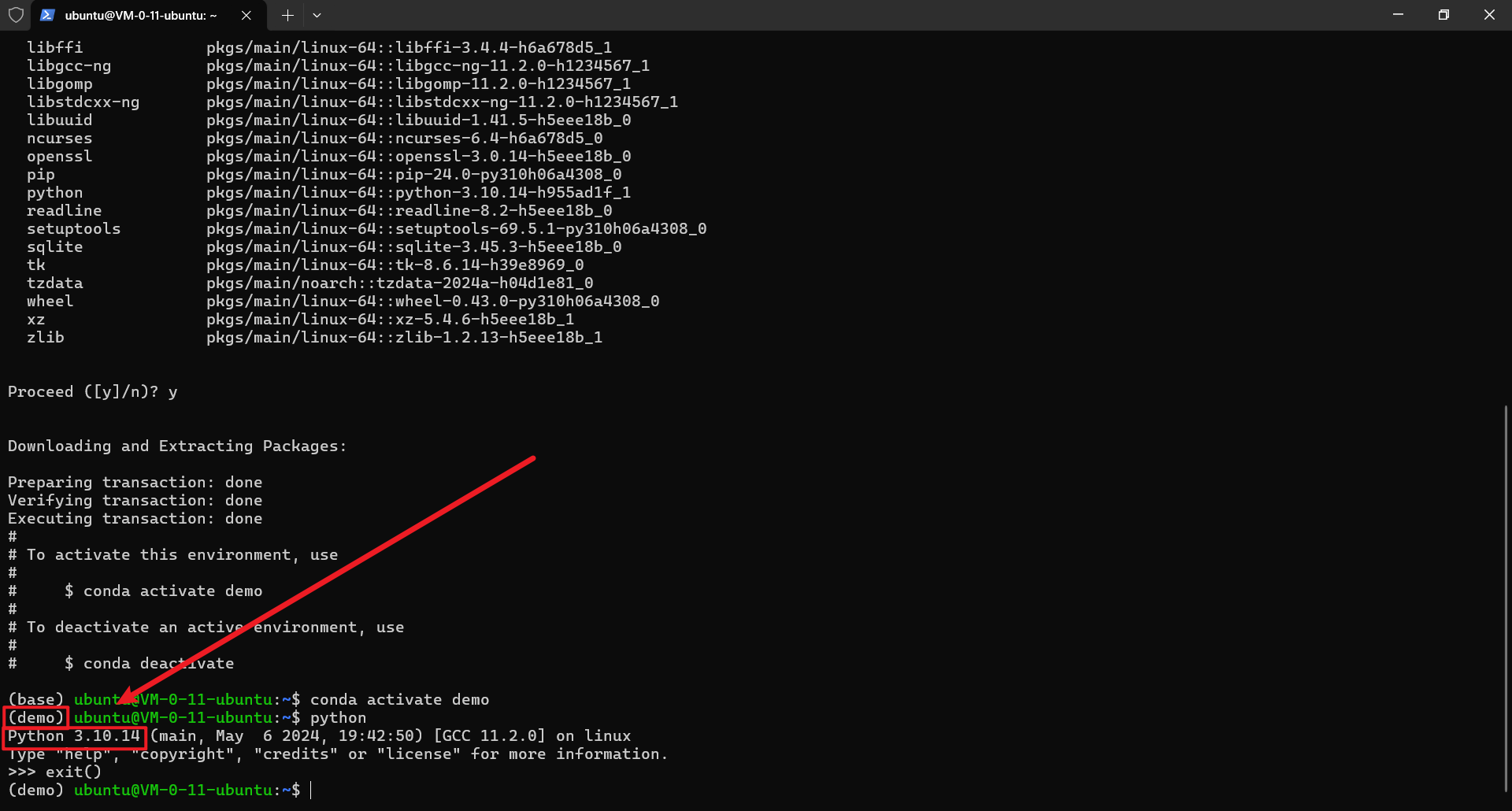

conda create -n demo python=3.10 # 新建python环境,其中demo是环境名,指定python版本为3.10 conda activate demo # 激活 demo 环境

当前python版本为 3.12.4,新建python版本为3.10的环境,执行命令,回车。

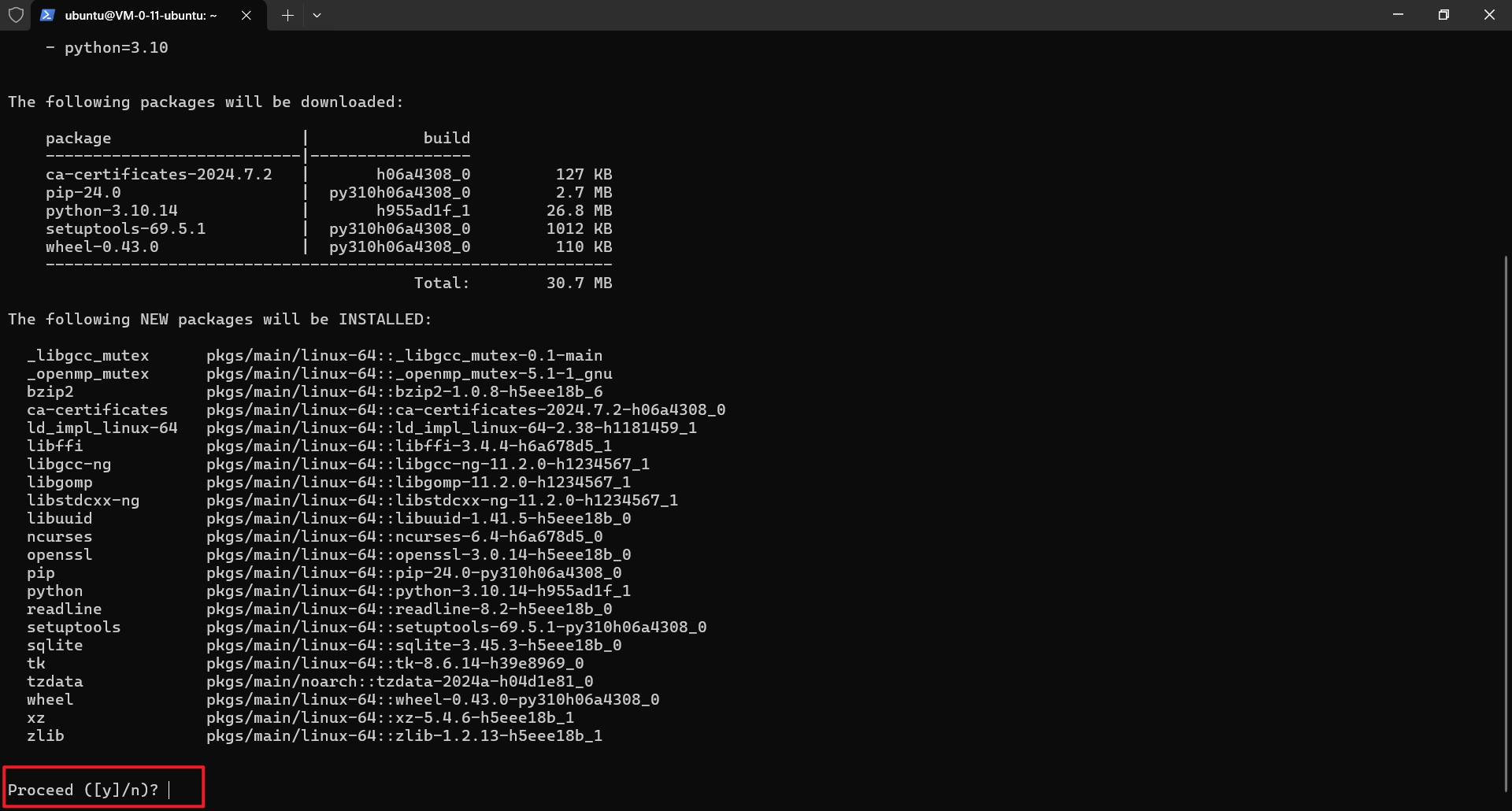

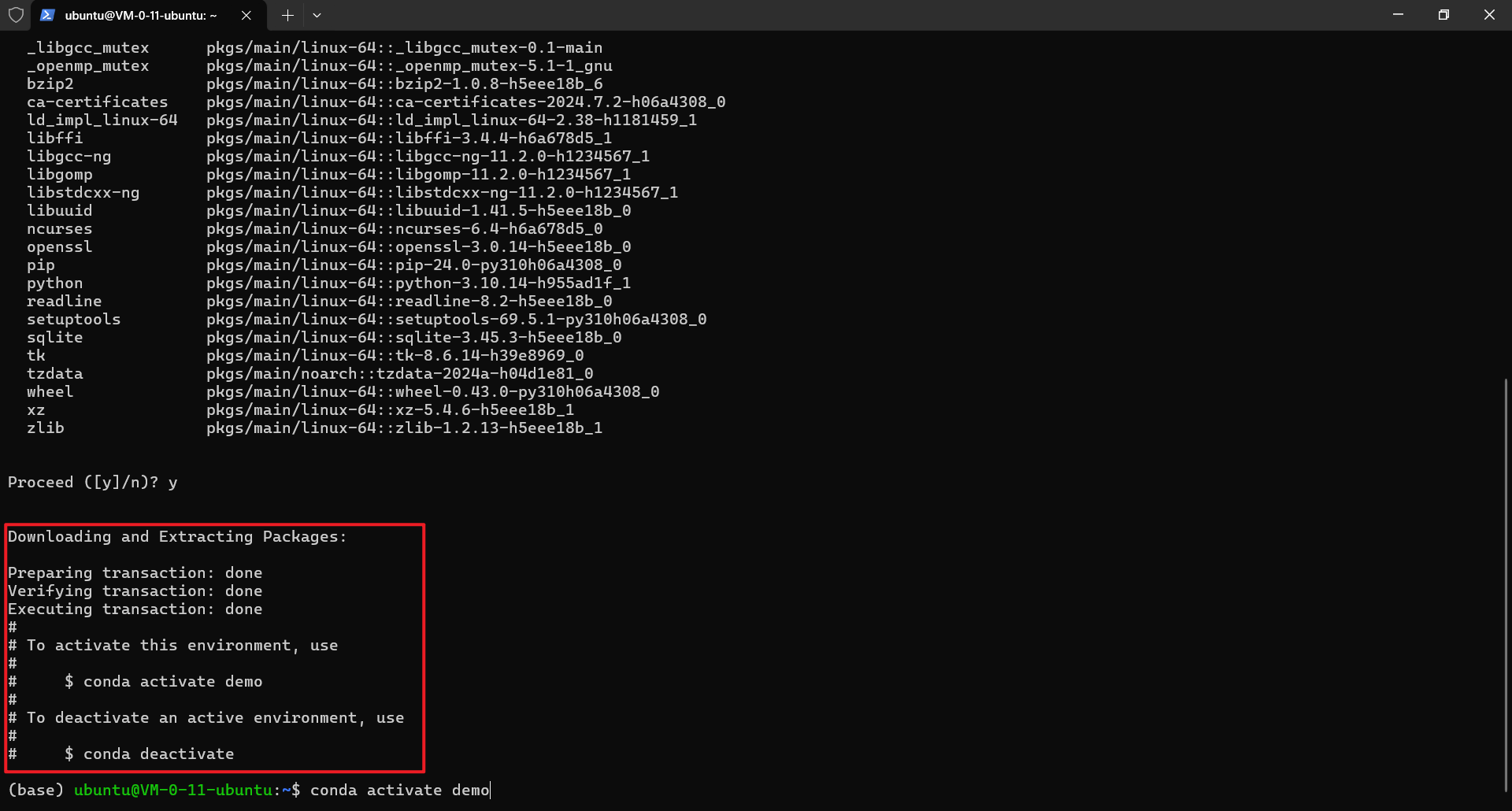

确认安装列出来的包,此处输入 y,回车。

环境安装完成,执行命令 conda activate demo 激活demo环境,回车。

已进入demo环境,并且python版本为3.10.14

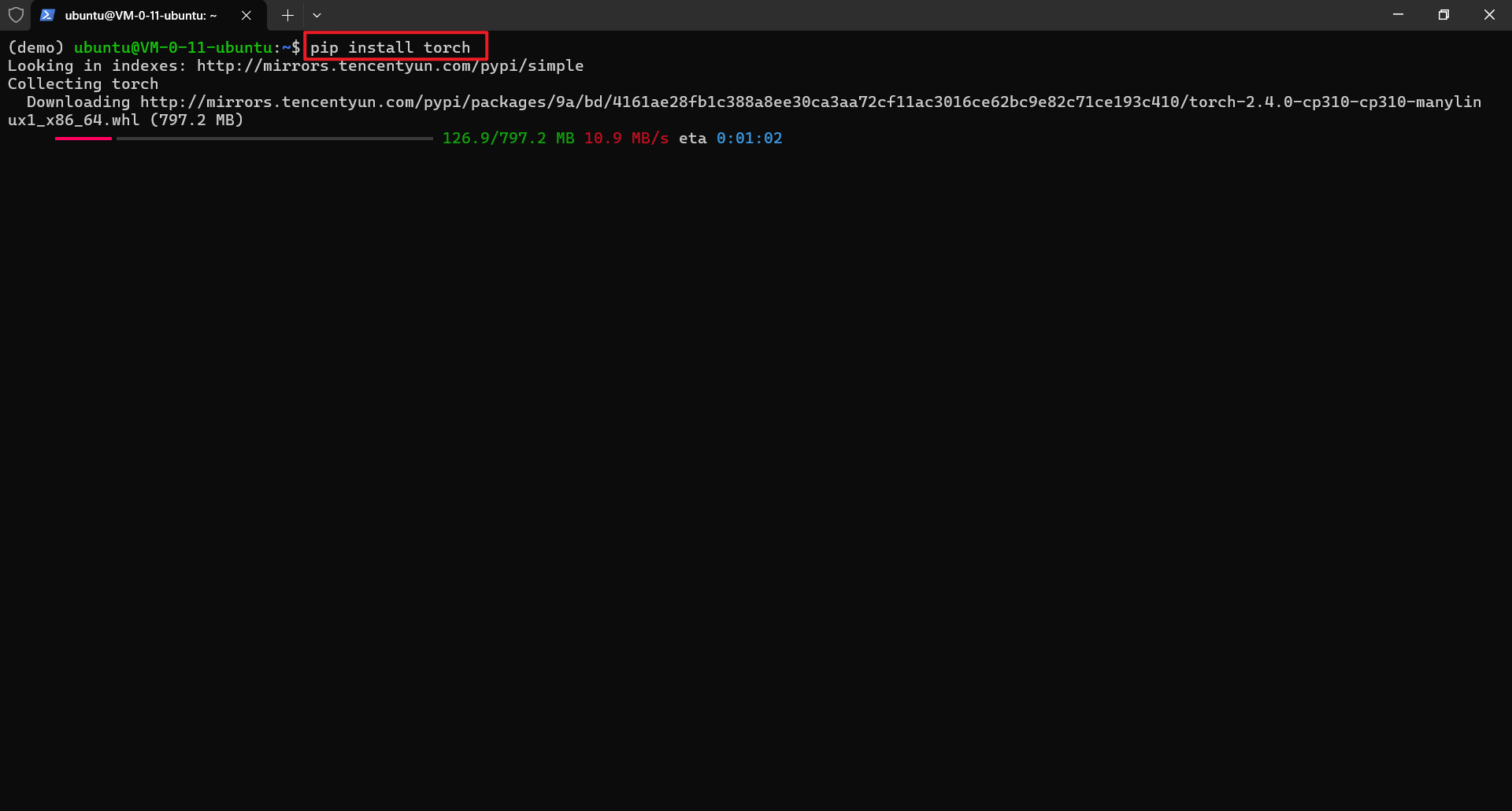

- 安装 torch,执行以下命令

pip install torch

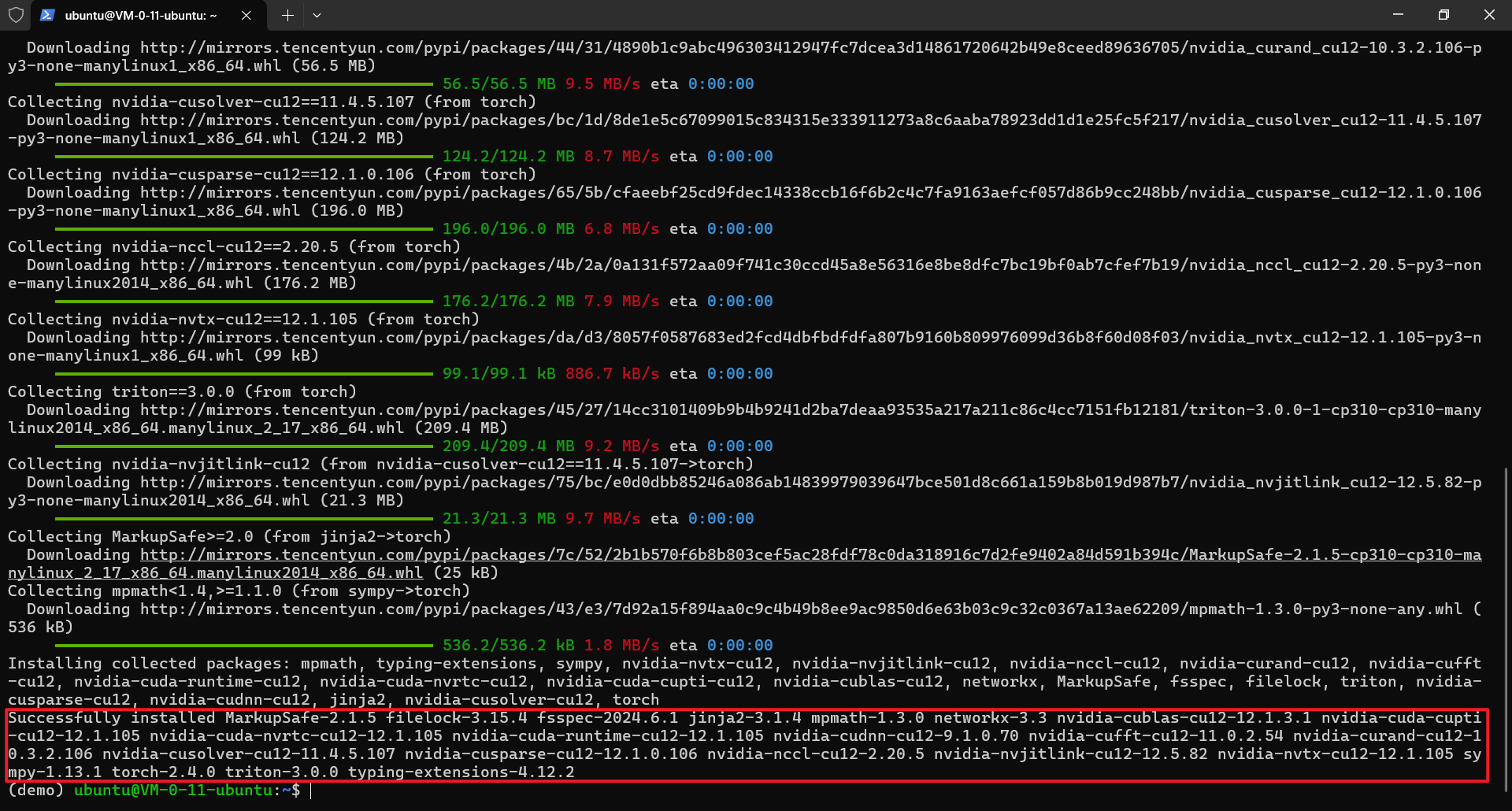

执行命令,默认选择的是腾讯云的镜像,等待下载并安装完成。

安装完成

检查GPU是否可用

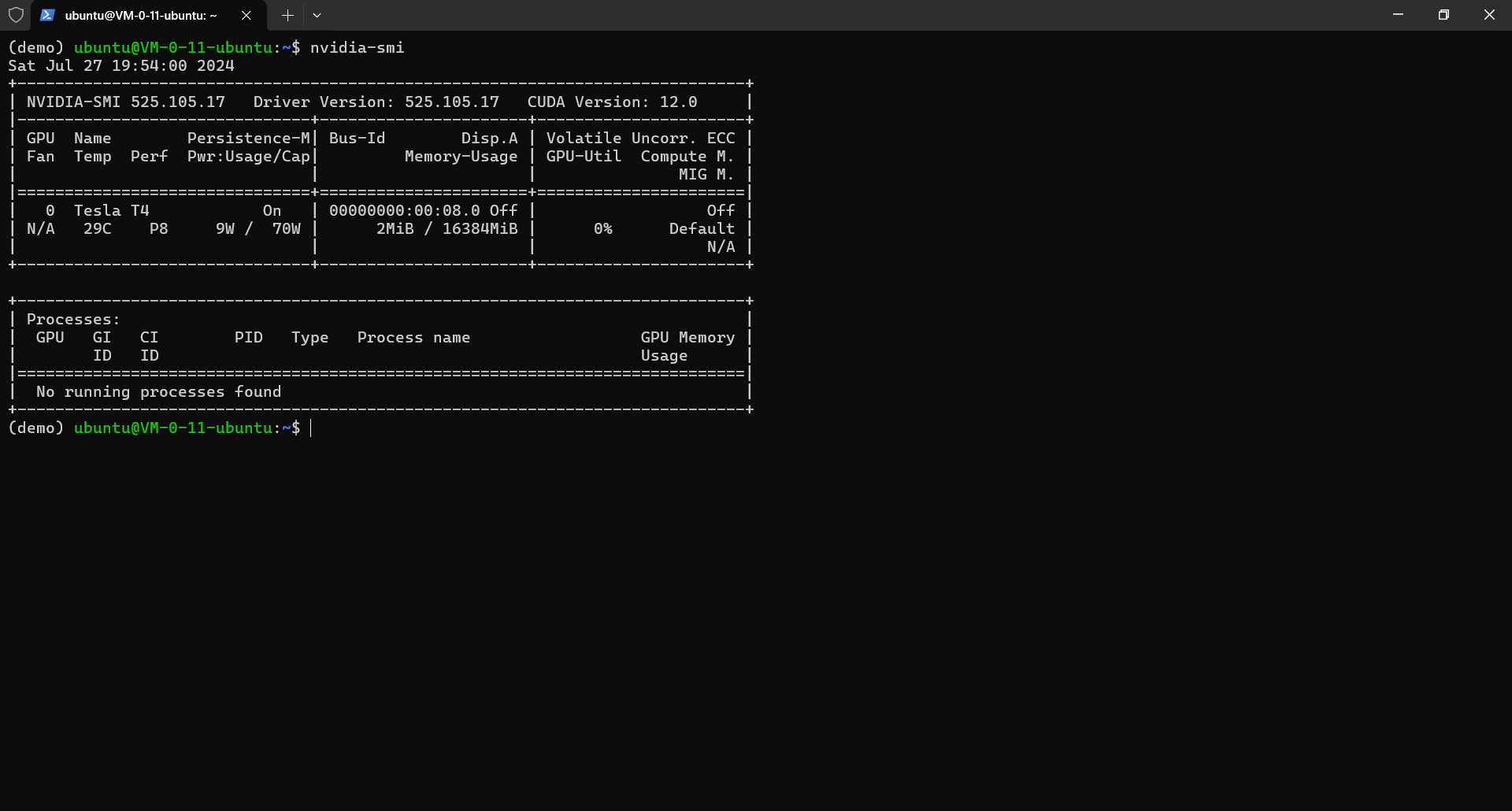

- 查看GPU状态,使用以下命令

nvidia-smi

正常显示GPU状态

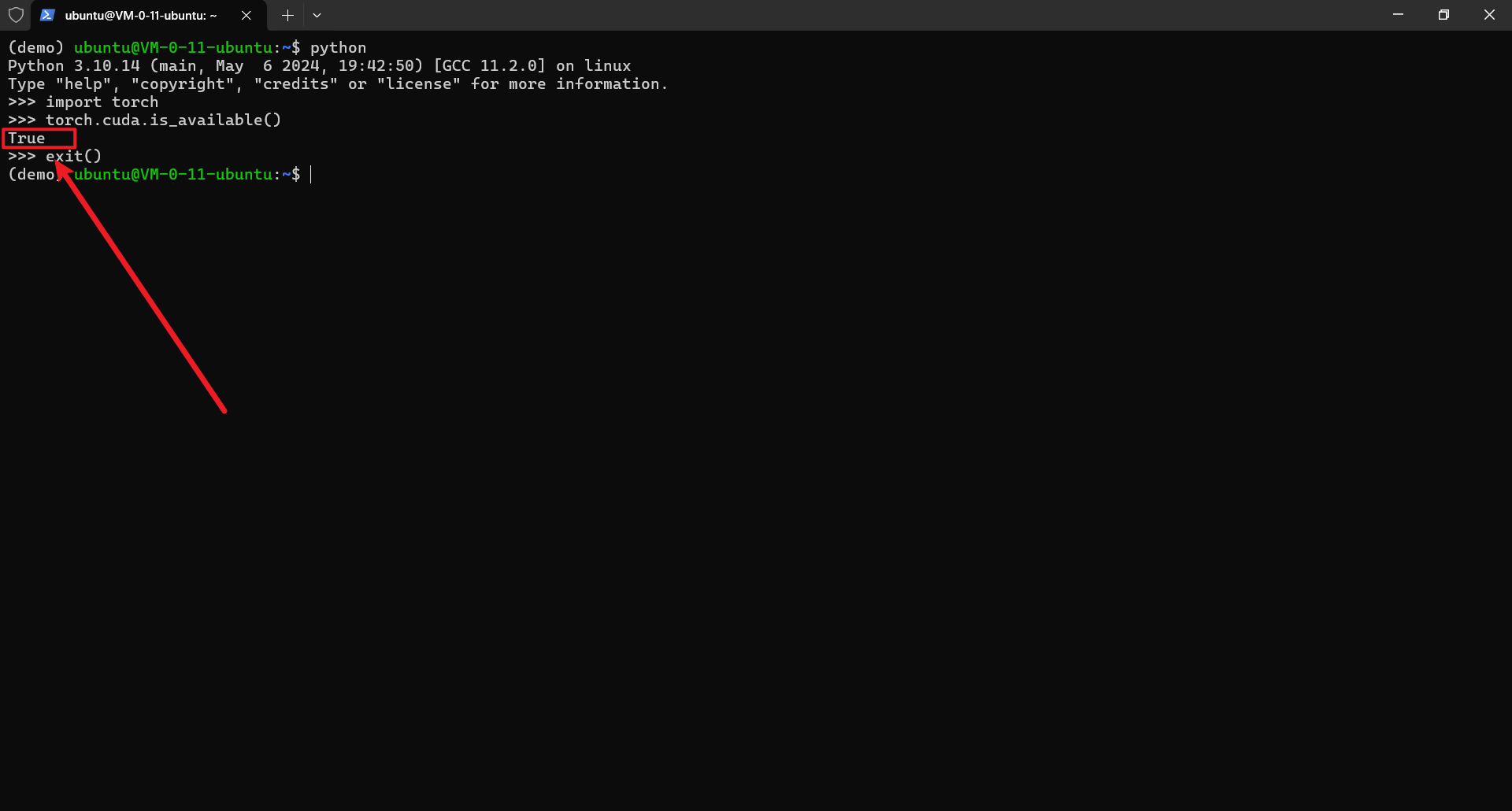

- 查看python是否可以调用CUDA,依次输入以下命令或代码

python # 进入python import torch # 引入 torch torch.cuda.is_available() # 检查cuda是否可用 exit() # 退出python

代码的输出为 True,表示 cuda 可用

这篇关于使用腾讯云GPU服务器搭建深度学习环境的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

您可能喜欢

-

从零开始学习贪心算法12-26

-

线性模型入门教程:基础概念与实践指南12-26

-

探索随机贪心算法:从入门到初级应用12-25

-

树形模型进阶:从入门到初级应用教程12-25

-

搜索算法进阶:新手入门教程12-25

-

算法高级进阶:新手与初级用户指南12-25

-

随机贪心算法进阶:初学者的详细指南12-25

-

贪心算法进阶:从入门到实践12-25

-

线性模型进阶:初学者的全面指南12-25

-

朴素贪心算法教程:初学者指南12-25

-

树形模型教程:从零开始的图形建模入门指南12-25

-

搜索算法教程:初学者必备指南12-25

-

算法高级教程:入门与初级用户指南12-25

-

随机贪心算法教程:初学者指南12-25

-

贪心算法教程:入门与实践指南12-25

栏目导航