人工智能学习

AI大模型企业应用实战(20)-RAG相似性检索的关键 - Embedding

本文主要是介绍AI大模型企业应用实战(20)-RAG相似性检索的关键 - Embedding,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

1 文本Embedding

将整个文本转化为实数向量的技术。

Embedding优点是可将离散的词语或句子转化为连续的向量,就可用数学方法来处理词语或句子,捕捉到文本的语义信息,文本和文本的关系信息。

◉ 优质的Embedding通常会让语义相似的文本在空间中彼此接近:

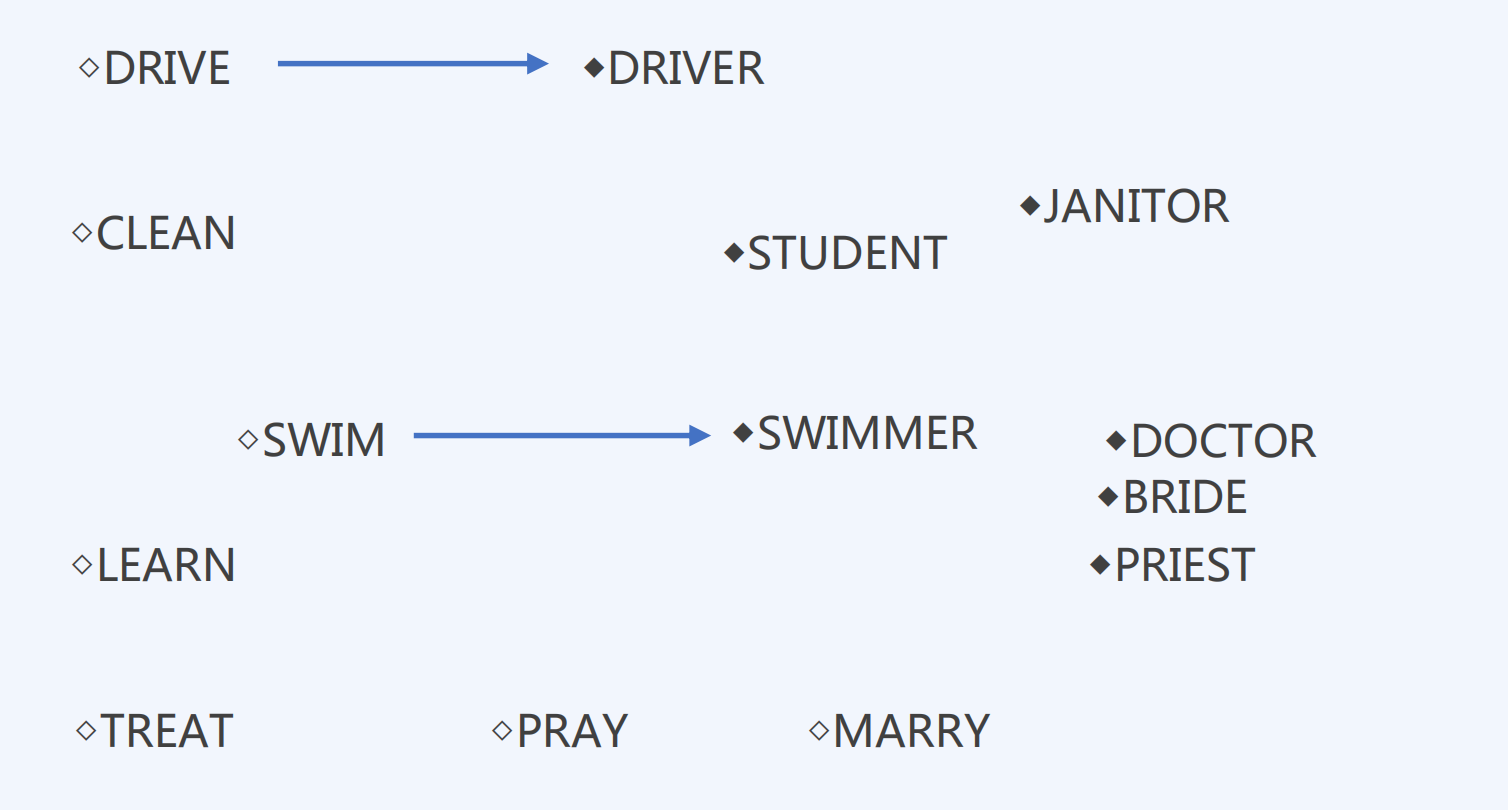

◉ 优质的Embedding相似的语义关系可以通过向量的算术运算来表示:

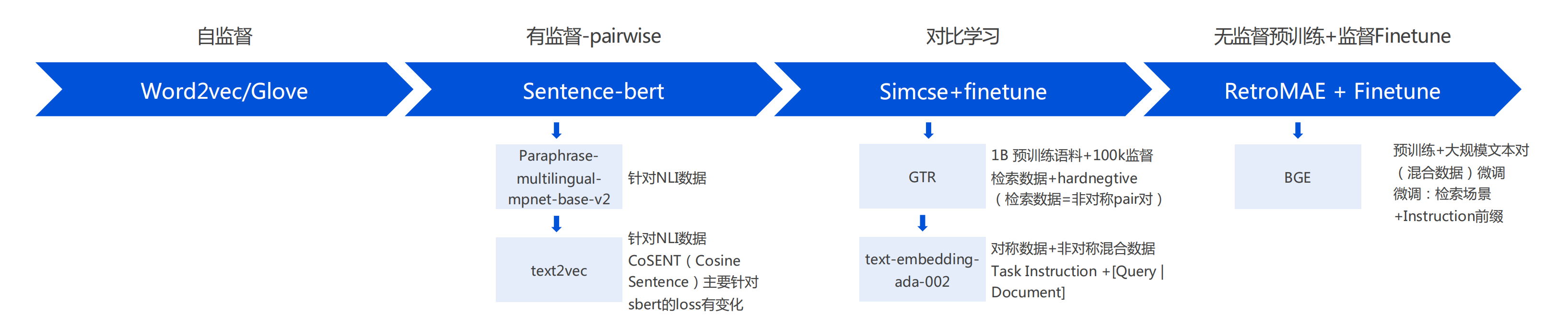

2 文本Embedding模型的演进与选型

目前的向量模型从单纯的基于 NLI 数据集(对称数据集)发展到基于混合数据(对称+非对称)进行训练,即可以做 QQ召回任务也能够做 QD 召回任务,通过添加 Instruction 来区分这两类任务,只有在进行 QD 召回的时候,需要对用户 query 添加上 Instruction 前缀。

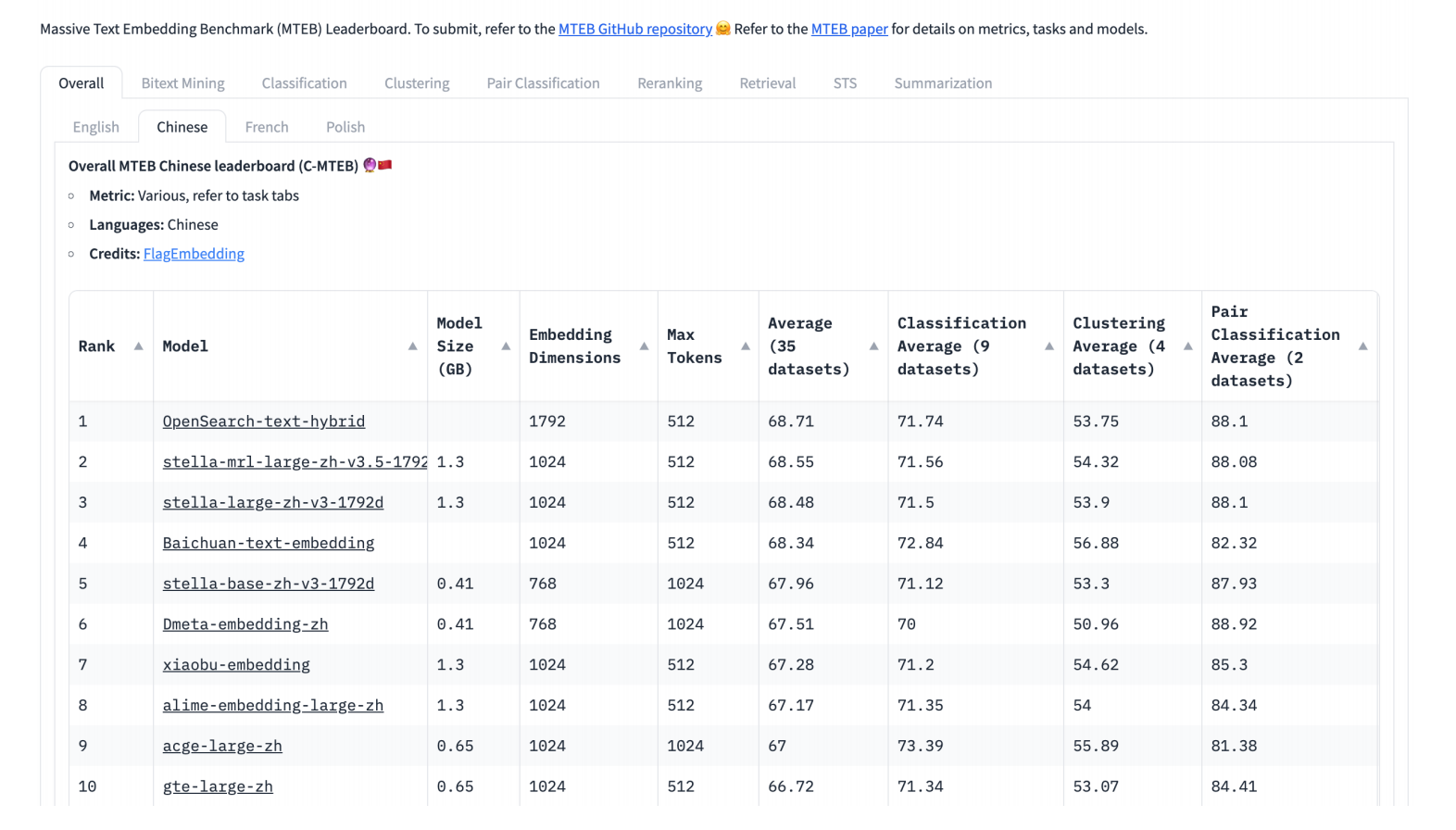

3 VDB通用Embedding模型

模型选择:

GPU资源:

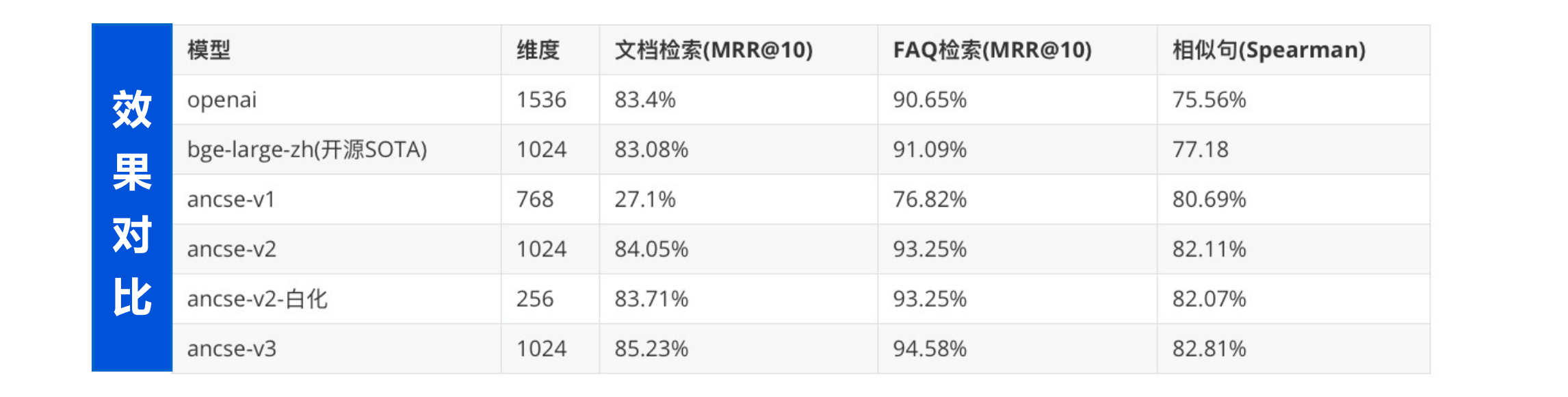

4 VDB垂类Embedding模型

用户提供垂类文档数据,VDB对模型进行微调,助力垂类应用效果更进一步。

优化1

对比学习拉近同义文本的距离,推远不同文本的距离

优化2

短文本匹配和长文本匹配使用不同prompt,提升非对称类文本效果

优化3

预训练阶段提升基座模型面向检索的能力,对比学习阶段提高负样本数

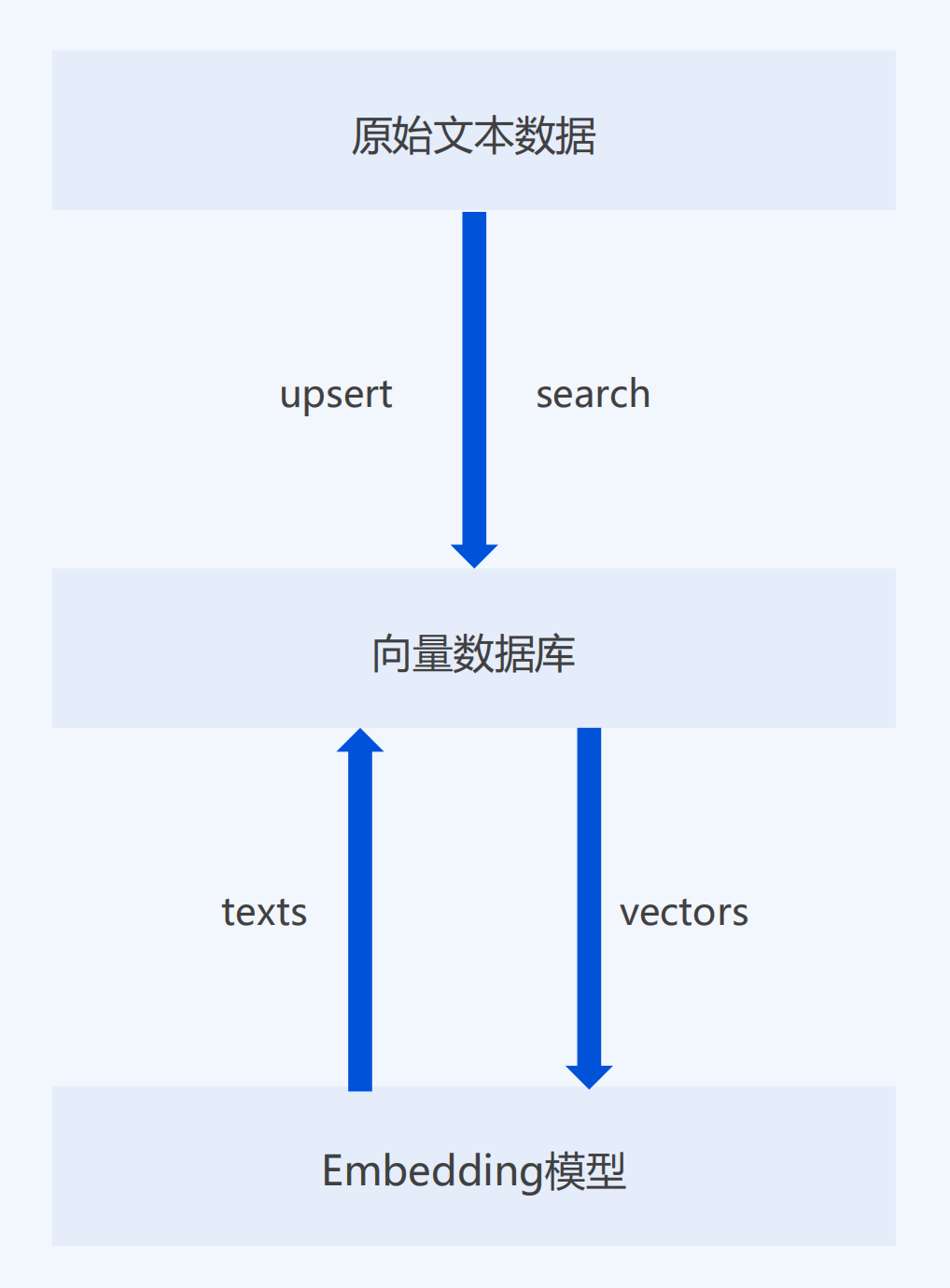

5 存储、检索向量数据

5.1 为啥需要一个专用的向量数据库

- 查询方式与传统数据库存在区别

- 简单易用,无需关心细节

- 为相似性检索设计,天生性能优势

5.2 腾讯云向量数据库的优势

“首家”:

- 通过信通院的标准化性能和规模测试

- 支持千亿级向量规模和最高500W QPS

自研:

- 内核源自集团自研OLAMA引擎

- 内部已有**40+**业务接入

性价比:

- 性能领先业内平均水平1.5倍

- 同时客户成本降低20%

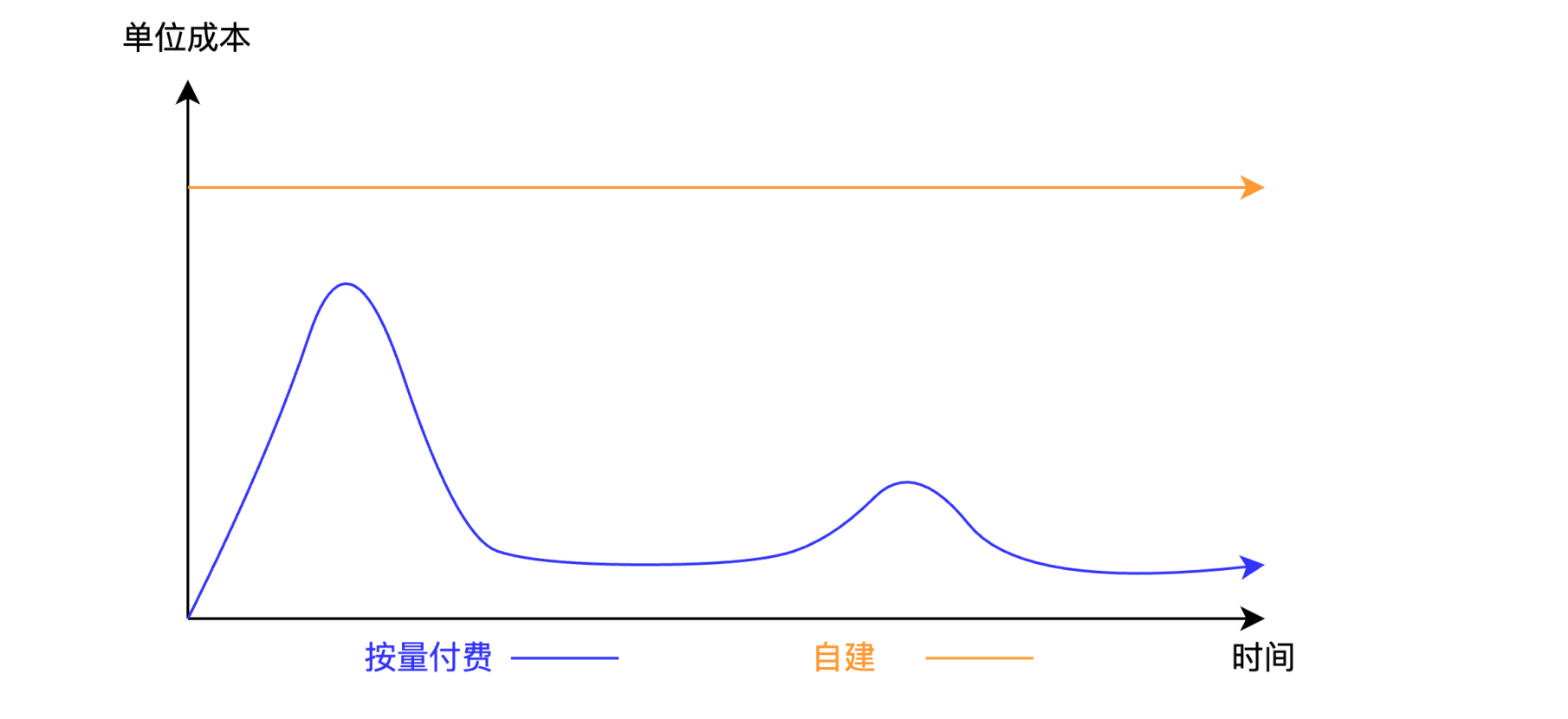

6 VDB优势

流程简化

模型简化:

共享GPU集群:

7 商用向量数据库

消除大模型幻觉,加速大模型在企业落地,如腾讯云:

7.1 端到端AI套件,AGI时代的知识库解决方案

提供一站式知识检索方案,实现业界内最高召回率、大幅降低开发门槛,帮助企业快速搭建RAG应用,解决大模型幻觉问题。

7.2 源自集团多年积累,产品能力行业领先

源自腾讯自研向量检索引擎OLAMA,集团内部40+业务线上使用,日均处理1600亿次检索请求。

- 『首家』通过中国信通院向量数据库标准测试

- 单索引支持最高千亿级超大数据规模

- 单实例最高可达500万 QPS

关注我,紧跟本系列专栏文章,咱们下篇再续!

作者简介:魔都架构师,多家大厂后端一线研发经验,在分布式系统设计、数据平台架构和AI应用开发等领域都有丰富实践经验。

各大技术社区头部专家博主。具有丰富的引领团队经验,深厚业务架构和解决方案的积累。

负责:

- 中央/分销预订系统性能优化

- 活动&券等营销中台建设

- 交易平台及数据中台等架构和开发设计

- 车联网核心平台-物联网连接平台、大数据平台架构设计及优化

- LLM应用开发

目前主攻降低软件复杂性设计、构建高可用系统方向。

参考:

- 编程严选网

这篇关于AI大模型企业应用实战(20)-RAG相似性检索的关键 - Embedding的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

您可能喜欢

-

从零开始学习贪心算法12-26

-

线性模型入门教程:基础概念与实践指南12-26

-

探索随机贪心算法:从入门到初级应用12-25

-

树形模型进阶:从入门到初级应用教程12-25

-

搜索算法进阶:新手入门教程12-25

-

算法高级进阶:新手与初级用户指南12-25

-

随机贪心算法进阶:初学者的详细指南12-25

-

贪心算法进阶:从入门到实践12-25

-

线性模型进阶:初学者的全面指南12-25

-

朴素贪心算法教程:初学者指南12-25

-

树形模型教程:从零开始的图形建模入门指南12-25

-

搜索算法教程:初学者必备指南12-25

-

算法高级教程:入门与初级用户指南12-25

-

随机贪心算法教程:初学者指南12-25

-

贪心算法教程:入门与实践指南12-25

栏目导航